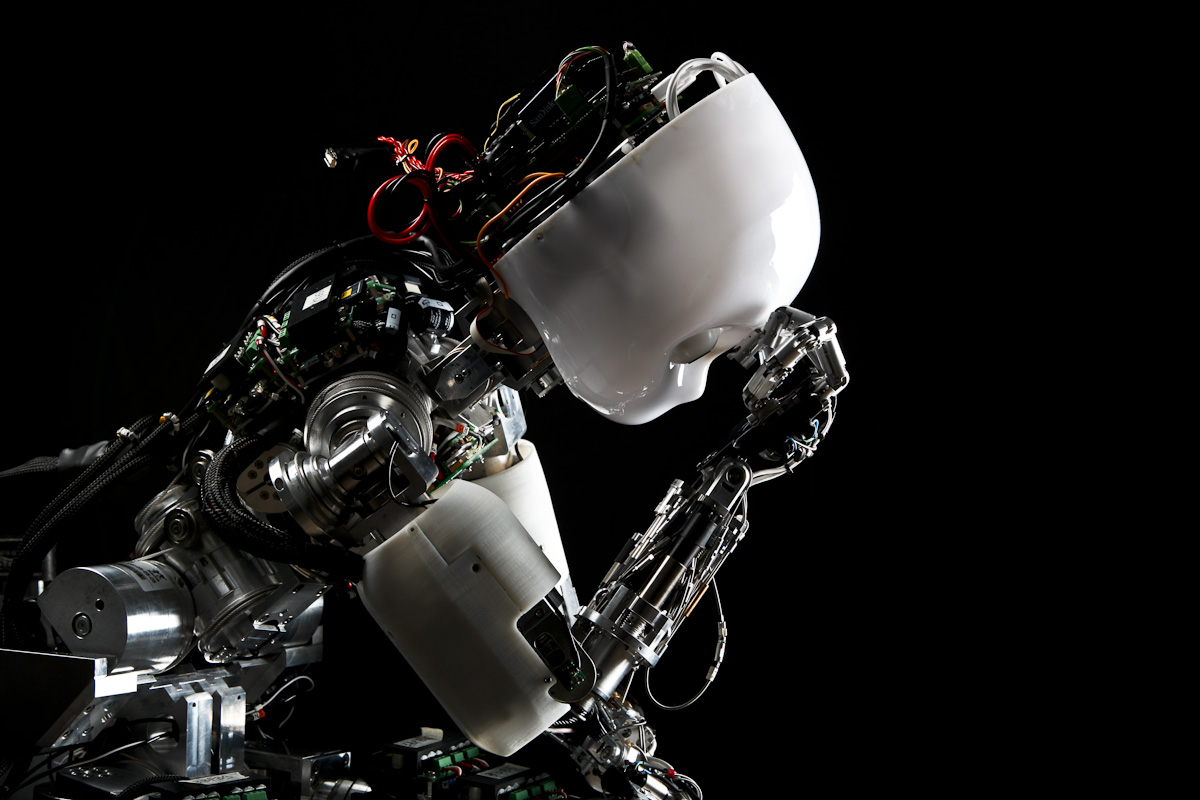

على غرار “لافندر” الإسرائيلي… مستشارة لدى الصليب الأحمر تناقش استخدام الذكاء الاصطناعي في الحروب

يثير وجود الروبوتات القاتلة في ساحة المعارك قلق المدافعين والمدافعات عن حقوق الإنسان . تؤكّد جورجيا هيندز، المستشارة القانونية للجنة الدولية للصليب الأحمر، على الحاجة الملحّة إلى إبرام معاهدة ملزمة لحظر الأسلحة ذاتية التشغيل، وتقييد استخداماتها بحلول عام 2026.

حدّد “لافندر” (Lavender)، وهو برنامج ذكاء اصطناعي طوّره الجيش الإسرائيلي، ما يصل إلى 37 ألف هدف محتمل في غزةرابط خارجي. ووفقاً لمصادر استخباراتية إسرائيليةرابط خارجي، أخذ البرنامج في الاعتبار هامش خطأ بنسبة 10%، وتم منح الإذن بقتل ما بين 15 و300 مدني.ة كـ ”أضرار جانبية“ لكل هدف تابع لحماس، اعتمادًا على رتبهم.

إسرائيل ليست استثناءً. تتطوّر الحرب في جميع أنحاء العالم لتصبح أكثر رقمية وسرعةً وأتمتةً، لدرجة أنه لم يتبق للبشر سوى ثوانٍ قليلة للضغط على الزناد – أو لا شيء على الإطلاق. في جنيف، تخشى الأمم المتحدة والمنظمات الإنسانية من تصاعد جرائم الحرب المرتبطة بهذه التقنيات التي تتطوّر بسرعة أكبر من سرعة تنظيمها.

تحدثت سويس إنفو (SWI swissinfo.ch) مع جورجيا هيندز، المستشارة القانونية للتكنولوجيات الجديدة للحرب لدى اللجنة الدولية للصليب الأحمر، وذلك على هامش مؤتمر الأمم المتحدة الأخير ”الذكاء الاصطناعي من أجل الصالح العام“، والذي عُقد في جنيف يومي 30 و31 مايو الماضي. وكانت هذه الأخيرة قد نشرت في وقت سابق من الشهر نفسه تقريرين جديدين حول تأثيرات الذكاء الاصطناعي على عملية صنع القرار العسكريرابط خارجي وتداعياته على المدنيين.ات والمقاتلين، وعلى القانون.

سويس إنفو: ما هي الأنواع المختلفة للتطبيقات العسكرية للذكاء الاصطناعي اليوم؟

جورجيا هيندز: يتم دمج الذكاء الاصطناعي بشكل متزايد في ساحة المعارك، في ثلاثة مجالات رئيسية على الأقل. وذلك أوّلا، في العمليات السيبرانية والمعلوماتية، وتغيير طبيعة المعلومات وانتشارها، على سبيل المثال باستخدام “تكنولوجيا التزييف العميق” لتصنيع محتوى واقعي للغاية – لكنه مزيف -. وثانيا، من خلال أنظمة الأسلحة، حيث يتم استخدام الذكاء الاصطناعي إما للتحكم جزئيًا، أو كليًا في وظائف مثل اختيار الهدف، أو توجيه ضربة، كما هو الحال مع أنظمة الأسلحة ذاتية التشغيل (AWS). وثالثا وأخيرًا، يتم استخدام الذكاء الاصطناعي في أدوات لدعم، أو تزويد عملية صنع القرار العسكري، بالمعلومات، على سبيل المثال من خلال، وضع نماذج لتأثيرات السلاح، ولكن أيضًا لتقديم توصيات، أكثر تعقيدًا، بشأن الأهداف المحتملة، أو مسارات العمل.

هل يمكن للقواعد التنظيمية، مواكبة تطوّر التكنولوجيا بسرعة كبيرة؟

علينا أن نضع في اعتبارنا أن الذكاء الاصطناعي لا يطوّر نفسه. حيث يختار البشر، تطوير هذه التكنولوجيا، ولا يزال لديهم.نّ خيار حول متى وكيف، يتم استخدامها في ساحة المعركة.

ولا ينظّم القانون الإنساني الدولي، بشكل صريح، الذكاء الاصطناعي العسكري، أو الأسلحة ذاتية التشغيل. لكنه “محايد من الناحية التكنولوجية”، ممّا يعني أن قواعده، تنطبق على استخدام أي سلاح، أو طريقة لشنّ الحرب – وبالتالي، لا توجد ثغرة قانونية تنظيمية بهذا المعنى. وتظلّ القيادات البشرية، مسؤولة عن ضمان تنفيذ أي هجوم، وفقًا لمبادئ التمييز (استهداف المقاتلين، أو الأهداف العسكرية فقط)، والتناسب (تجنب إلحاق الأذى غير المتناسب بالمدنيين والمدنيات)، وأخذ الاحتياطات اللازمة (اتخاذ جميع التدابير الممكنة، لتجنب إلحاق الضرر بالمدنيين والمدنيات)، مهما كانت التكنولوجيا المستخدمة.

ونرى، بعد كل ما سبق، حاجة ملحة، فيما يخص الأسلحة ذاتية التشغيل، على وجه الخصوص، لوضع قواعد جديدة، وملزمة قانونًا، لتوفير المزيد من الوضوح والتوجيه، بشأن كيفية تطبيق القانون الإنساني الدولي، من أجل حظر بعض أنظمة الأسلحة ذاتية التشغيل، وتقييد استخدام البعض الآخر. وهذا النوع من التوجيه، ضروري ليس للجيوش فحسب، بل أيضًا للمصنعين.ات والمطورين.ات، وكذلك من أجل معالجة المخاوف الأوسع التي تثيرها هذه الأسلحة، بما في ذلك من المنظور الإنساني، والأخلاقي، والأمني.

المزيد

الروبوتات القاتلة: هل تحتاج إلى قواعد تنظيمية صارمة؟

ما هي التدابير التي ينبغي اتخاذها لتقنين أنظمة الأسلحة ذاتية التشغيل (AWS)؟

تُعرّف اللجنة الدولية للصليب الأحمر، الأسلحة ذاتية التشغيل، بأنها أنظمة تختار وتطبّق استخدام القوة على الأهداف، بدون تدخل بشري. وقد دعونا إلى إبرام معاهدة جديدة وملزمة، بحلول عام 2026، تحظر بعض الأسلحة ذاتية التشغيل، وتضع قيودا صارمة على تصميم واستخدام جميع الأسلحة الأخرى. ويتعين على هذه القواعد التنظيمية بشكل خاص، حظر الأسلحة ذاتية التشغيل، التي لا يمكن توقع ما ستقوم به (والتي لا يمكن السيطرة على آثارها، على سبيل المثال عندما “تتعلم” الآلات من تلقاء نفسها)، وتلك التي تستهدف الناس بشكل مباشر. وهناك حاجة ماسة إلى هذه الأنواع من القواعد التنظيمية، للحفاظ على السيطرة البشرية على استخدام القوة، في الصراعات المسلحة، وبالتالي، الحدّ من آثار الحرب، ودعم تدابير الحماية الأساسية، ليس فقط للمدنيين والمدنيات، ولكن أيضًا للمحاربين والمحاربات.

حث الأمين العام للأمم المتحدة ورئيس اللجنة الدولية للصليب الأحمر، في عام 2023، الدول على إبرام صكّ ملزم قانونًا لحظر الأسلحة الفتاكة ذاتية التشغيل، بحلول عام 2026رابط خارجي. واعتمدت الجمعية العامة للأمم المتحدة، منذ ذلك الحين،قرارًارابط خارجي يعرب عن القلق من مخاطر الأسلحة ذاتية التشغيل. فما هي الخطوات التالية؟

سيصدر الأمين العام للأمم المتحدة، في الأشهر المقبلة، تقريرًا جوهريا، بشأن الأسلحة ذاتية التشغيل، استنادًا إلى آراء الدول، وكذلك آراء المنظمات الدولية والإقليمية، على غرار اللجنة الدولية للصليب الأحمر، والمجتمع المدني، والأوساط العلمية، والصناعة. وسيكون الأمر بعد ذلك، متروكًا للمجتمع الدولي، للتصرف بناءً على توصيات ذلك التقرير، ونحن نحثّ الدول على بدء المفاوضات، بشأن صكّ ملزم قانونًا، للتأكد من إمكانية الحفاظ على سبل الحماية الأساسية، للأجيال القادمة.

وعكفت مختلف المنظمات في جنيف، لأكثر من عقد من الزمن، على مناقشة المخاطر والتحديات الناجمة عن الأسلحة ذاتية التشغيل، في سياق الاتفاقية المتعلقة بأسلحة تقليدية معينة، والتي تسعى إلى حظر، أو تقييد استخدام الأسلحة التي تعتبر أضرارها مفرطة وآثارها عشوائية. ولدينا الآن أغلبية واضحة من الدول، تؤيد القواعد الملزمة قانونا، ولذلك، فإننا متفائلون.ات بأن هذا الزخم، يمكن أن يؤدي إلى إبرام معاهدة فعلية، بحلول عام 2026.

عُقدت مؤخرا قمة “الذكاء الاصطناعي من أجل الصالح العام” في جنيف. هل يمكن استخدام الذكاء الاصطناعي، لتجنب إلحاق الأذى بالمدنيين والمدنيات، أثناء الحرب، وبالتالي يكون أكثر امتثالًا للقانون الإنساني؟

من المهم أن نفحص بشكل نقدي، أي ادعاء بأن التكنولوجيات الجديدة، ستجعل الحرب أكثر إنسانية، بطريقة أو بأخرى. لقد سمعنا ادعاءات مماثلة من قبل، على سبيل المثال في سياق الأسلحة الكيميائية، والمسيّرات، ومع ذلك، ما زلنا نرى معاناة واسعة النطاق، ومدنيين ومدنيات، عالقين وعالقات، في الصراعات. ويتطلب إضفاء المزيد من الإنسانية، على الحرب، إعطاء الأولوية للامتثال للقانون الإنساني الدولي، بهدف محدد، هو حماية المدنيين والمدنيات. ونحن ندرك أن هناك إمكانية لبعض أنظمة الذكاء الاصطناعي، لمساعدة صناع وصانعات القرار، على الامتثال للقانون، على سبيل المثال في حرب المدن، إذا كان بإمكانها تزويد القادة والقائدات بمعلومات إضافية حول عوامل مثل البنية التحتية المدنية والسكان. وفي الوقت نفسه، يحتاج صناع وصانعات القرار إلى فهم، وتفسير القيود المفروضة، على هذه التكنولوجيات، مثل الفجوات الكبيرة في البيانات، والتحيز، وعدم القدرة على التنبؤ.

وفقًا لتحقيق أجراه فريق صحفي مقيم في القدسرابط خارجي، قام الجيش الإسرائيلي بنشر نظام ذكاء اصطناعي متطور في غزة، لاستهداف قادة حماس المفترضين. وفي بعض الحالات، يسمح البرنامج، بهوامش خطأ، تصل إلى 100 حالة وفاة مدنية، لكل هدف، كما تزعم التقارير. ما هو رأيك في هذا الخصوص؟ وكيف يمكننا مساءلة الدول، في ظل عدم وجود قانون؟

اللجنة الدولية للصليب الأحمر، هي منظمة إنسانية محايدة، وغير متحيزة، ولذلك، نمتنع عمومًا عن التعليق علنًا على استخدامات، وحالات محددة، في النزاعات الجارية – فهذه أمور تشكل جزءًا من حوارنا الثنائي السري، مع أطراف تلك النزاعات.

ومع ذلك، كما ذكرت من قبل، لا يوجد مكان، أو حالة خارجة عن القانون في الصراعات المسلحة. وسيستمر تطبيق القانون الإنساني الدولي، وأطر المساءلة، بغض النظر عن الأدوات المستخدمة. ولتطبيق هذه القواعد على هجوم استخدم فيه الجيش نظام الذكاء الاصطناعي، يمكننا أن ننظر فيما إذا كان من المعقول للقيادة، الاعتماد على نتائج نظام الذكاء الاصطناعي، وما إذا كانت قد اتخذت جميع الاحتياطات الممكنة، لتجنب إلحاق الضرر بالمدنيين والمدنيات.

المزيد

قائد الجيش السويسري يخطط لشراء طائرات مسلحة بدون طيار في المستقبل

هل تفقد البشرية السيطرة على أسلحتها؟

يعدّ فقدان السيطرة البشرية على تأثيرات أنظمة الأسلحة، أحد اهتماماتنا الرئيسية في سياق أنظمة الأسلحة ذاتية التشغيل، لا سيما ونحن نرى اتجاهات نحو أنظمة متزايدة التعقيد، مع توسيع معايير تشغيلها. وبناء على ذلك، فإن تقييمنا حاليًا، هو استمرار احتفاظ القوات العسكرية، بالقيادة عن بعد، أو الإشراف على أنظمة الأسلحة، حتى عندما يتم الإعلان عن أسلحة معينة، مثل المسيّرات المسلحة، على أنها تتمتع بالقدرة على العمل بشكل مستقل. ومن المهم الآن، وضع حدود واضحة، لتصميم الأسلحة ذاتية التشغيل واستخدامها، للتأكد من الحفاظ على هذه السيطرة على استخدام القوة.

يمكن أن يشكّل الجندي الآليّ ربعرابط خارجي الجيش البريطاني بحلول عام 2030. كيف يبدو مستقبل الحرب من وجهة نظرك؟

للأسف، مهما كانت التكنولوجيا المستخدمة، فإن مستقبل الحرب يبدو مروّعًا. ويتم في بعض الأحيان، إغفال هذه الحقيقة، عند الحديث عن التكنولوجيات الجديدة، لأن هذه المناقشات تجري بعيدا عن ساحة المعركة، ويتم تصوير التكنولوجيات الجديدة، بطريقة أو بأخرى، على أنها غير ملوثة للبيئة، أو دقيقة.

وتشير قراءتنا إلى أن تكنولوجيا الروبوتات بالتحديد، تتقدم بشكل أبطأ، من تطورات الذكاء الاصطناعي. وتثير التطورات الأقل وضوحا، في مجال الذكاء الاصطناعي، مخاوف فورية، ولا شك أن هذه التطورات، ستؤدي في نهاية المطاف، إلى تمكين المزيد من التعزيز لأنظمة الروبوتات.

ونرى على المدى القريب، أن إدماج الذكاء الاصطناعي، هو سمة رئيسية في ساحة المعركة، ليس فقط في أنظمة الأسلحة، ولكن طوال دورة التخطيط، وصنع القرار، بدءًا من تقديم التوصيات، إلى التحكم في جوانب أنظمة الأسلحة، أثناء الهجمات. وبالتالي، ستصبح الحرب المستقبلية، معقّدة بشكل متزايد، ولا يمكن التنبؤ بها. ولذلك، فإن أولويتنا هي تركيز اهتمام المجتمع الدولي، على التطبيقات المحددة للذكاء الاصطناعي، في النزاعات المسلحة، التي تشكل أكبر خطر على حياة الناس وكرامتهم. ن.

تحرير: فيرجيني مانجان

ترجمة: مصطفى قنفودي

مراجعة: عبد الحفيظ العبدلي/أم

المزيد

الاشتراك في النشرة الإخبارية

متوافق مع معايير الصحافة الموثوقة

المزيد: SWI swissinfo.ch تحصل على الاعتماد من طرف "مبادرة الثقة في الصحافة"

يمكنك العثور على نظرة عامة على المناقشات الجارية مع صحفيينا هنا . ارجو أن تنضم الينا!

إذا كنت ترغب في بدء محادثة حول موضوع أثير في هذه المقالة أو تريد الإبلاغ عن أخطاء واقعية ، راسلنا عبر البريد الإلكتروني على arabic@swissinfo.ch.