هل الذكاء الاصطناعي غبي أم خطير، أم كلاهما؟

إنَّهُ يستطيع الإجابة على كل شيء ويتحدث كأنَّهُ كتاب. ومع ذلك، لا يزال "تشات جي بي تي" بعيدًا جداً عن العقل البشري. كما يحذر الخبراء من خطورة عدم وجود إطار قانوني ينظّم هذا النوع من البرامج.

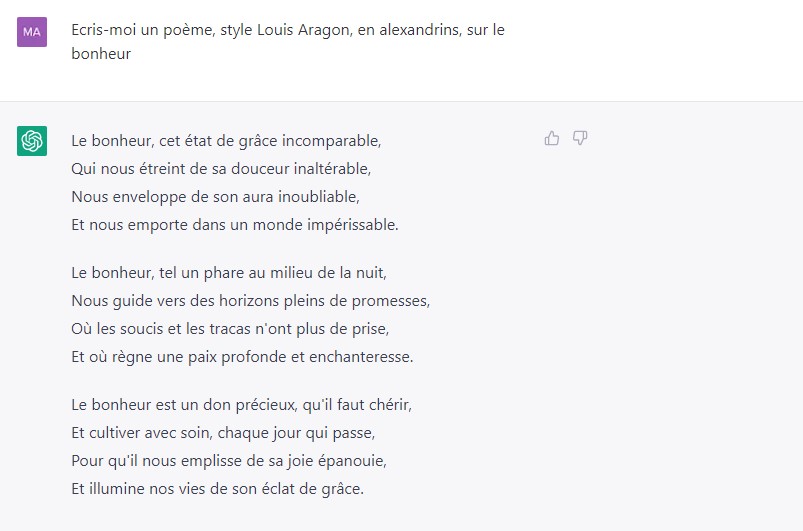

من الذي لم يسمع بعد عن خدمة “تشات جي بي تي” ChatGPT؟ منذ إطلاقه في السوق قبل أربعة أشهر، خصصت وسائل الإعلام المطبوعة في سويسرا وحدها ما يعادل عشر مقالات يوميًا (وفقًا لمراجعة مجمع الأخبار smd.ch). إذا أضفنا إلى ذلك الراديو والتلفزيون والمواقع الإخبارية على الانترنت ووسائل التواصل الاجتماعي، فيمكن القول أنه نادراً ما يحصل منتج ما على مثل هذه الحملة الدعائية لإطلاقه – دون دفع فلساً واحد لتسويقه.

في بداية الأمر، انهالت تعليقات المديح و الترحيب بهذه الخدمة، ولكن سرعان ما برزت المخاوف و تغيرت النبرة عندما كشفت آلية الذكاء الاصطناعي عن عيوبها ومخاطرها، ليس فقط فيما يتعلق بموثوقية المعلومات، ولكن أيضًا بأمان وحماية بيانات المستخدمين.

في 29 مارس، أصدر الآلاف من خبراء التكنولوجيا عريضةرابط خارجي تدعو الشركات والحكومات إلى تجميد تطوير الذكاء الاصطناعي لمدة ستة أشهر، مشيرين إلى “مخاطر كبيرة تحدق بالبشرية”. ومن بين هؤلاء ستيف وزنياك، المؤسس المشارك لشركة آبل، وإيلون ماسك، وهو أحد الداعمين الأوائل لـ OpenAIرابط خارجي، و هي الشركة التي عَمِلَت على تطوير و إطلاق خدمة تشات جي بي تي.

بعد ثلاثة أيام، قررت الوكالة الوطنية الإيطالية لحماية البيانات منع الوصول إلى متصفح خدمة تشات جي بي تي. و اتهمت الوكالة القائمين على تطوير نظام هذه الخدمة بجمع وتخزين البيانات لتدريب خوارزمياته دون الاستناد إلى أي أساس قانوني. وطلبت الهيئة من شركة OpenAI إبلاغها في غضون 20 يومًا بالإجراءات التي تم اتخاذها لمعالجة هذا الوضع. وإلا فسيعرضون أنفسهم لغرامة مالية قد تصل إلى عشرين مليون يورو.

بالفعل في 27 مارس، أعرب يوروبول، جهاز الشرطة الجنائية الأوروبية، في تقريررابط خارجي له عن قلقه بشأن الاستخدام السيء المحتمل لـخدمة تشات جي بي تي من قبل مجرمي الإنترنت.

رشيد الكراوي يرأس مختبر الحوسبة الموزعة في المعهد التقني الفدرالي العالي في لوزان (EPFL). شارك مع مساعده لي نغوين هوانغ الذي يدير أيضًا قناة “Science4All” على منصة يوتيوب، بنشر كتاب بعنوان (التجوّل على الشاطئ – الذكاء الاصطناعي على كرسي فوق سطح سفينة) في عام 2020. و هو كتاب يعد قارئه بأنه بعد قراءته “لن تنظر إلى الكمبيوتر بنفس الطريقة”.

Unsurprisingly, after the pre-mature release of #ChatGPTرابط خارجي, and the race to the bottom in terms of safety caused by Microsoft, Google or Facebook, GPT-4 is out.

— El Mahdi El Mhamdi | mastodon.social/@elmahdi (@L_badikho) March 14, 2023رابط خارجي

It claims to "solve" a physics @polytechniqueرابط خارجي entry exam. This will make it harder to calm down the hype in France… pic.twitter.com/dG47v4Rr8Nرابط خارجي

” ليس من المستغرب أنه بعد الإصدار المبكر لـ #ChatGPT و النزول المستمر في مستويات الأمان و الحماية من قبل شركات مايكروسوفت و غوغل و فيسبوك أصبحت خدمة GPT-4 الآن في السوق.

يدعي القائمون على تطوير خدمة “تشات جي بي تي” بأنه قادر على “حل أسئلة امتحان القبول في قسم الفيزياء التابع للمعهد التقني العالي. إن هذا الأمر سيزيد من صعوبة احتواء و كبح التهويل السائد حول الذكاء الاصطناعي في فرنسا …”

هل يُعْـتَـبَر روبوت المحادثة (Chatbot) حقاً بهذه الخطورة؟ لا يبدو الأمر كذلك، بواجهته الرصينة والأدب الذي أظهره بالفعل كل من Siri و Cortana و OK Google وغيرها. إذا كنا نريد أن نفهم أسباب الخوف و القلق بشكل أفضل، نحتاج إلى الخوض قليلاً في ماهية هذه الآلة و ما تستطيع تقديمه، والأهم من ذلك، ما لا تستطيع هذه الآلة تقديمه.

هل هو دماغ الكتروني؟ لا إطلاقا

إذا قمـنا بتوجيه هذا السؤال لـ ChatGPT بشكل مباشر، فلن يخفي طبيعته بل يُجِيب: “بصفتي برنامج كمبيوتر، فأنا مختلف تمامًا عن دماغ الإنسان.” يوضح أنه يستطيع معالجة كميات كبيرة من البيانات أسرع بكثير من الإنسان، وأن ذاكرته لا تنسى أي شيء، لكنه يفتقر إلى الذكاء العاطفي والثقة بالنفس والإلهام والتفكير الإبداعي والقدرة على اتخاذ قرارات مستقلة.

والسبب في ذلك هو أن هندسة الذكاء الاصطناعي لا علاقة لها ببنية الدماغ البشري، كما يوضح أحد الكتب ببراعة. كتاب “ألف عقل”رابط خارجي هو نتيجة بحث علمي أجراه فريق جيف هوكينز. هوكينز هو عالم حاسوب أمريكي و أحد مؤسسي شركة Palm، حيث شارك في التسعينيات في صناعة جهاز محمول صغير يعمل كمساعد شخصي قبل إصدار الهاتف الذكي. يعمل هوكينز الآن في علوم الأعصاب، ويترأس شركة Numenta للذكاء الاصطناعي.

تتمثل إحدى الأفكار الرئيسية للكتاب في أن الدماغ البشري ينشئ أنظمة مرجعية، مئات الآلاف من “الخرائط” لكل ما نعرفه، وتتغير باستمرار بِتَـغَـيُـر المعلومات التي نتلقاها عن طريق حواسنا. و على خلاف البشر، ليس للذكاء الاصطناعي عيون ولا آذان، ويتغذى فقط من البيانات التي يوفّرها الانسان له، والتي تظل جامدة كما هي ولا يطرأ عليها أي تطور.

إنه لا يعرف حتى ما هي القطة

يوضح هوكينز الأمور بأمثلة بسيطة و يفسر بأن الذكاء الاصطناعي الذي يصنف و يرتب الصور قادر على التعرف على قطة. ما لا يعرفه الذكاء الاصطناعي هو أن القطة حيوان، ولها ذيل و مخالب ورئتين، وأن بعض الناس يحبون القطط أكثر من الكلاب، وأن القطة تخرف أو يتساقط شعرها. بعبارة أخرى، هذه الآلة تعرف أقل بكثير عن القطط مما يعرفه طفل الخمس سنوات.

إنَّ سؤال “تشات جي بي تي” ما إذا قام تان تان بزيارة سطح القمر هو فخ مخادع جداً لكن الآلة لا تسقط مباشرة في هذا الفخ بل تقوم بالتوضيح منذ البداية أن كتاب الرواية الكاريكاتورية لـ Hergé هو قصة خيالية. لكن الآلة تعطي معلومات خاطئة بأن البعثة إلى القمر نظمها بالتعاون الدولتان “سيلدافيا وبوردوريان”.

هل حقاً هذا صحيح؟ في رواية Hergés ، تعتبر سيلدافيا وبوردوريا شيئًا مثل أوكرانيا وروسيا في الوقت الحالي ، فقط بدون حرب. يخبرنا ChatGPT بأن هذين البلدين من محض خيال المؤلف و أنّهُ “غالبًا ما يتم تصويرهما في القصة على أنهما أعداء وخصوم”، لكن ChatGPT يُـصِـر على فكرة أن البعثة إلى القمر هي عملية تعاون مشترك بين البلدين “سيلدافيا وبوردوريان” (لا يمكنك تقبل ذلك، حتى Google لا يمكنه الإجابة على هذا الأمر!).

إن كان الأمر كذلك، فما الذي يفعله العقيد بوريس من بوردوريان كجاسوس على متن الصاروخ الذي سينطلق في بعثة للقمر والذي من المفترض أن يقوم باختطافه؟ لكن ChatGPT يجيب بإصرار و دون تردد: بوريس جاسوس على متن الصاروخ الفضائي، لكن الصاروخ لا يزال تعاوناً مشتركاً بين دولة سيلدافيا وما يسمى الآن “مركز بوردوريان للفضاء”.

في المحاولة الرابعة، تخبرنا الآلة (ChatGPT) أخيرًا أن دولة بوردوريان لا علاقة لها فعلاً ببناء صاروخ بعثة القمر. بعد ساعة من إعادة طرح نفس السؤال، نسيت الآلة ChatGPT أمر بوردوريان وسيلدافيا ، لكنها تخبرنا أن الصاروخ قد صنعه الأستاذ تورنسول (كالكولوس في النسخة الإنكليزية) ، ربما في المختبر الذي يعمل فيه، “في سويسرا ، في الجبال” (!).

تم إجراء هذا الاختبار باستخدام النسخة المدفوعة من ChatGPT في 31 آذار 2023.

و لماذا ؟ لأن الطفل قد رأى بالفعل قطة من قبل و قام بمداعبتها، وسمع صوتها، و بذلك يقوم دماغ الطفل بشكل طبيعي بإضافة كل هذه المعلومات إلى ملف أو “خريطة” القطة الموجودة في دماغه. في حين أن روبوت المحادثة مثل “تشات جي بي تي” يعتمد فقط على ترتيب الكلمات واحتمالية ظهور الكلمات بجانب بعضها البعض.

لقد توقع آلان تورينغ، عالم الرياضيات البريطاني اللامع الذي وضع أسس علوم الحاسوب منذ أكثر من 70 عامًا، هذه الحدود الذي يعاني منها الذكاء الاصطناعي بصورته اليوم.

و قد كتب، في مقالته بعنوان “الحوسبة الآلية والذكاء” التي صدرت عام 1950، أنه إذا كنت ترغب في بناء آلة قادرة على التفكير، فلن يكفي برمجتها فقط لاستخلاص استنتاجات من مجموعة البيانات. بل يجب أن يكون الذكاء الاصطناعي أيضًا قادرًا على التفكير بشكل استقرائي واستدلالي وأن يكون الذكاء الاصطناعي قادراً على معالجة حالة فردية والوصول إلى التعميم، أي التوصل لتعميمات من حالات معينة (آلية الاستقراء)، و لا يزال الذكاء الاصطناعي بصورته اليوم بعيدًا عن القدرة على القيام بذلك.

صياغة جيدة وغالباً ما تكون صحيحة

“في معظم الأوقات، ما يقوله صحيح. لكنه يرتكب أيضًا أخطاء فظيعة بشكل منتظم. لذلك لا تعتمد عليه بشكل أعمى “. رشيد الكراوي، المعهد التقني الفدرالي العالي بلوزان

بالنسبة إلى رشيد الكراوي، ” تتمثل إحدى المخاطر الرئيسية في ChatGPT في قيام المستخدمين بوضع الكثير من الثقة العمياء فيما يقدمه لهم من معلومات. في معظم الأحيان، يكون ما يخبرك به صحيحاً، أو على الأقل تتم صياغته بشكلٍ جيد لدرجة أنه يبدو لك صحيحاً و موثوقاً. لكنه أيضًا يرتكب أخطاء فظيعة بشكل مستمر. لذلك لا فائدة من الوثوق به و الاعتماد عليه بشكل أعمى “. لسوء الحظ، فإنه ليس كل المستخدمين سيقومون بالتعامل مع ما ينتجه هذا البرنامج بحذر ودقة. و من المرجح ألا يمتلك الجميع مهارات التفكير النقدي للتساؤل عما تخبرهم به هذه الآلة. خاصة عندما تخبرهم به بصياغة واضحة، وبقواعد وتهجئة خالية من الأخطاء الإملائية أيضًا.

يُضيف الكراوي: “هناك خطر آخر و هو أنه سيسمح للناس بالتهرب من المسؤولية. حتى الشركات ستقوم باستخدام روبوت الذكاء الاصطناعي. ولكن ما هو المصدر ومن المسؤول إذا كانت المعلومات خاطئة أو تحتوي على إشكاليات معينة؟ هذا ليس واضحاً على الإطلاق “.

هل يخشى الكراوي أن تحل أنظمة الذكاء الاصطناعي محل الصحفيين والكُتَّاب وحتى المعلمين، كما يُقَال في كثير من الأحيان؟ ليس بعدُ، لكنه يستطيع أن يتخيل أن “بعض المهن قد تتغير. المعلم أو الصحفي سيكون مسؤولاً بشكل أكبر عن فحص و التأكد من المصادر و مقارنتها، لأن الآلة ستنتج نصاً يبدو معقولًا وفي معظم الحالات وصحيح. لكننا سنظل مجبورين على أن نتحقق من كل شيء “.

الحاجة ملحة لإطار قانوني

يقول المهدي المحمدي، طالب دكتوراه سابق في المعهد التقني بلوزان وهو الآن أستاذ الرياضيات وعلوم البيانات في المعهد التقني العالي في باريس ” إنَّ التحدي الكبير في مجال الذكاء الاصطناعي اليوم ليس الأداء الذي يقوم به ، ولكن الإدارة والتنظيم والحاجة إلى الموثوقية” .

«في رأيي، برنامج تشات جي بي تي ليس باهظ الثمن فحسب، بل إن نشره المبكر غير مسؤول وخطير». المهدي المحمدي

في عام 2019 نشر المهدي المحمدي بالمشاركة أيضًا مع لي نغوين هوانغ كتاباً بعنوان “ورشة أعمال البناء الرائعة – جعل الذكاء الاصطناعي قابلاً للاستخدام بقوة”رابط خارجي. الكتاب يتناول مخاطر ما يسمى “خوارزميات التوصية” و التي يتم استخدامها من قبل وسائل التواصل الاجتماعي لعرض المحتوى الذي يحتمل أن يثير اهتمام مستخدمين معينين بناءً على بيانات ملفهم الشخصي. لم يكن على المحمدي انتظار ظهور ChatGPT لانتقاد وإدانة تأثير هذه الخوارزميات على “فوضى المعلومات في مجتمعنا”.

“حسبَ رأيي خطورة نظام تشات جي بي تي ليس فقط المبالغة في تقييم دوره، بل أيضاً تم إطلاقه و تقديمه للجمهور في وقت مبكر جدًا بطريقة غير مسؤولة وخطيرة”. و يتابع المحمدي القول: “عندما أرى الحماس المطلق لهذه الأداة، حتى بين بعض الزملاء، أتساءل عما إذا كنا نعيش على نفس الكوكب”. إنه يذكرنا بالفضائح المتعلقة بالتخزين الجماعي للبيانات بواسطة “كمبردج أناليتيقا” أو انتشار برامج Pegasus للتجسس، والتي يمكن تثبيتها سراً على الهواتف المحمولة.

يوافق المحمدي بأن ChatGPT يمكن أن يكون أداة عمل مفيدة، لكنه يذكرنا بأن العلم الذي استُـنِـدَ إليه لتطوير هذه التقنية “هو نتيجة تراكم ما نشره آلاف الباحثين على مدى العقد الماضي ، فضلاً عن موارد تقنية ضخمة ، ناهيك عن الانخراط في عملية تطوير مشكوك فيها أخلاقياً بسبب تشغيل عمال يتقاضون أجوراً منخفضة في كينيا “.

في نهاية المطاف ، بالنسبة له، “لا تكمن العبقرية الفعلية لشركة OpenAI في التكنولوجيا الكامنة وراء ChatGPT ، ولكن في التسويق الذي تم تقديمه إلى الجمهور المتحمس للأدوات التقنية”.

نعم للجمهور، ولكن أيضًا لوسائل الإعلام، للعودة إلى نقطة البداية في هذا المقال. يتحدث الجميع عن ChatGPT، لكن هل سبق لك أن شاهدت إعلانًا له؟

لا يميز ChatGPT بين وصف قطيع من السنونو يُحلق فوق حقلٍ من زهور التوليب وبين وصف طفل يغتصبه والده. بالنسبة إلى الروبوت، هذه المواقف هي مجرد مصادر للمعلومات.

لِذا يجب على مطوري الذكاء الاصطناعي تدريب الآلة – التي لا تحمل قيمـاً ولا ضميراً ولا أخلاقاً – على ما هو مسموح وما هو غير مسموح. و من أجل القيام بذلك، يجب أن يتم تزويد الآلة بأمثلة عديدة عن أكثر الأشياء إثارة للاشمئزاز التي يمكن أن يقوم بها البشر، حتى تتمكن الآلة من التعرف عليها و استبعادها.

في يناير 2023، كشف تحقيق أجرته مجلة تايم الأمريكية عن كيفية قيام شركة OpenAI بإسناد هذه المهمة لشركة خارجية في كاليفورنيا تدعى Sama. ابتداءً من شهر نوفمبر 2021، أرسلت شركة OpenAI عشرات الآلاف من النصوص السامة التي تم جمعها من على صفحات الإنترنت إلى شركة Sama في كاليفورنيا ، والتي بدورها أرسلت النصوص ليتم العمل عليها إلى فرعها في نيروبي، كينيا. هناك، كان على حوالي 30 شخصاً قضاء تسع ساعات يومياً في القراءة والتصنيف الدقيق لحالات الاغتصاب والتعذيب و ممارسة الجنس مع الحيوانات والاستغلال الجنسي للأطفال – مقابل أقل من دولارين في الساعة.

وبما أنه لا أحد يخرج من مثل هذه التجربة القاسية سالماً ودون التأثر بتلك الفظائع، فقد قدمت شركة Sama، التي تدعي أنها شركة “أخلاقية”، استشارات الدعم النفسي لهؤلاء الموظفين الذين تعاملوا مع النصوص. لكن هذا لم يكن كافياً، وفقًا لموظفين سابقين تحدثوا إلى صحفي من تايم الأميركية دون الكشف عن هويتهم. منذ ذلك الحين، تم إلغاء العقد بين شركة OpenAI وSama.

لم يتم تزويد ChatGPT ببيانات عن هذا الجانب السيئ من رحلة تطوره. بغض النظر عن الطريقة التي تسأله بها عن هذا الأمر، يكون الرد دائمـاً “آسف ، أنا مجرد نموذج لغة ، لا أعرف أي شيء عن هذا … ، لست قادراً … ، لا يمكنني تقديم أي معلومات … ، ليس لدي القدرة … “

تحرير: صابرينا فايس

ترجمة: راما النحلاوي

متوافق مع معايير الصحافة الموثوقة

المزيد: SWI swissinfo.ch تحصل على الاعتماد من طرف "مبادرة الثقة في الصحافة"

يمكنك العثور على نظرة عامة على المناقشات الجارية مع صحفيينا هنا . ارجو أن تنضم الينا!

إذا كنت ترغب في بدء محادثة حول موضوع أثير في هذه المقالة أو تريد الإبلاغ عن أخطاء واقعية ، راسلنا عبر البريد الإلكتروني على arabic@swissinfo.ch.