هل الذكاء الاصطناعي بالذكاء الذي نتصوره فعلا؟

باتت الحواسيب تتخذ قرارات رئيسية بالنيابة عنّا على نحو متزايد. فهل يجب أن نسمح لها بفعل ذلك؟ يبين فريق أبحاث من معهد "إيدياب" السويسري كيف أن جزءاً كبيرأً من الذكاء الاصطناعي هو مجرد وَهْـم ليس إلا.

هل يُمكن للآلات أن تفكر؟ هذا هو السؤال الذي افتتح به عالم الرياضيات البريطاني، آلان تورينغ، مقالته العلمية الأشهررابط خارجي. وهي تلك المقالة المنشورة عام 1950، التي وضعت أسس مفهوم الذكاء الاصطناعي وتعريفه. وللإجابة على السؤال الذي طرحه، اخترع تورينغ “لعبة التقليد”، التي لا تزال تُستخدم حتى يومنا هذا بغية الحكم على ذكاء آلة ما.

هذه اللعبة، التي أصبحت تعرف لاحقاً باسم “اختبار تورينغ”، تضم ثلاثة لاعبين: اللاعب “ألف” هو رجل، واللاعب “باء” هي امرأة واللاعب “جيم”، الذي يلعب دور المُستجوِب، هو من أي من الجنسين. ولا يستطيع المستجوِبُ رؤية اللاعبيْن الآخريْن، لكنه يطرح عليهما سلسلة من الأسئلة كتابةً بغرض تحديد أي من اللاعبين رجل وأيهما امرأة. وهدف المجيب الذكر هو خداع المستجوب وإعطاء إجابات مضللة، في حين يتعيّن على المرأة أن تسهل تحديد هويتها على نحو صحيح.

والآن تخيّل لو استُبدل اللاعب “ألف” بالحاسوب. في هذا الصدد، كتب تورينغ أنه إذا لم يتمكن المستجوِبُ من التمييز بين الحاسوب والشخص، ينبغي حينها اعتبار ذلك الحاسوب كياناً ذكياً لأنه سيُثبت أنه مشابه للإنسان من ناحية الإدراك.

بعد مرور سبعين عاماً، مازالت نتائج ذلك الاختبار مُذهلة. إذ يشير هيرفي بورلار، الذي يدير معهد “إيدياب” للأبحاثرابط خارجي الواقع مقره في مدينة مارتيني، قائلاً: “في الوقت الحالي، لا يوجد نظام ذكاء اصطناعي واحد، ولا أي واحد، استطاع اجتياز اختبار تورينغ الأول”. وهذا المعهد الذي يوجد مقره في كانتون فاليه متخصّص في الذكاء الاصطناعي والمعرفي.

المزيد

الآلة والأخلاق.. تحديات الذكاء الاصطناعي

لا اصطناعي ولا ذكي

بعد أن بطل استخدام مصطلح الذكاء الاصطناعي في أوائل السبعينيات من القرن الماضي، حيث اعتبر آنذاك أنه سخيف وغير مواكب للعصر، عاد المصطلح ليُصبح رائجاً من جديد في تسعينيات القرن الماضي “لأسباب إعلانية وتسويقية وتجارية” على حد تعبير بورلار، وهو أيضاً أستاذ في الهندسة الكهربائية، موضحاً أن عودة ظهور المصطلح جاءت “على الرغم من عدم إحراز أيّ تقدم حقيقي عدا في قوة النماذج الرياضية”. ولا يزال يساوره الشك إزاء مصطلح الذكاء الاصطناعي وكيفية استخدامه اليوم.

ويقول إنه ليس ثمة شيء اسمه “الذكاء الاصطناعي” على اعتبار أنه لا يُوجد نظام يعكس أدنى درجة من الذكاء البشري. فحتى الطفل البالغ من العمر شهرين أو ثلاثة أشهر، باستطاعته أن يفعل ما لن يستطيع الذكاء الاصطناعي فعله أبداً.

مثال بسيط يوضح ما سبق. إذا وضعت كوباً ممتلئاً بالماء على الطاولة، ستلاحظ أن الطفل الرضيع يعرف حق المعرفة أن الكوب إذا انقلب رأسا على عقب، يصبح عندئذ فارغاً. ويفسر بورلار قائلاً: “لذلك السبب يستمتع الطفل الرضيع بقلب الكوب. وليس بمقدور أي آلة في العالم أن تفهم هذا الاختلاف”. وما يوضحه هذا المثال ينطبق أيضاً على الحس المنطقي السليم، أي القدرة البشرية المميزة التي لا يُمكن للآلات أن تكتسبها بالتقليد ولن تقدر على فعل ذلك مطلقاً، وفقاً لبورلار.

الذكاء يكمُن في البيانات

على أي حال، فإن الذكاء الاصطناعي مُعتمَد تماماً في الأعمال التجارية في الكثير من القطاعات، وهو يُسهم بصورة متزايدة في عمليات اتخاذ القرار في مجالات مثل الموارد البشرية والتأمين والإقراض المصرفي، على سبيل المثال لا الحصر. وتتعرف الآلات على هويتنا وعلى ما نحب من خلال تحليل السلوك البشري على شبكة الإنترنت. ثم تقوم محركات التوصية بتصفية المعلومات الأقل أهمية وتقترح مشاهدة الأفلام أو قراءة الأخبار أو شراء الملابس التي قد تُعجبنا على منصات وسائل التواصل الاجتماعي.

لكن ذلك لا يجعل الذكاء الاصطناعي ذكياً، وذلك وفقاً لبورلار الذي تولى إدارة المعهد في عام 1996 والذي يُفضل الحديث عن التعلّم الآلي. إذ يقول إنه توجد ثلاثة أشياء تجعل الذكاء الاصطناعي قوياً بطريقته الخاصة وهي: قدرة المعالجة، والنماذج الرياضية، وقواعد البيانات الواسعة والمنتشرة في كل مكان. وبالفعل، كان لكل من الحواسيب المتزايدة القوة وعملية رقمنة المعلومات الفضل في تحسين النماذج الرياضية تحسيناً هائلاً. ثم تولى الإنترنت بواسطة قواعد البيانات اللامتناهية إنجاز باقي المهمة، معززاً بذلك قدرات أنظمة الذكاء الاصطناعي أكثر فأكثر.

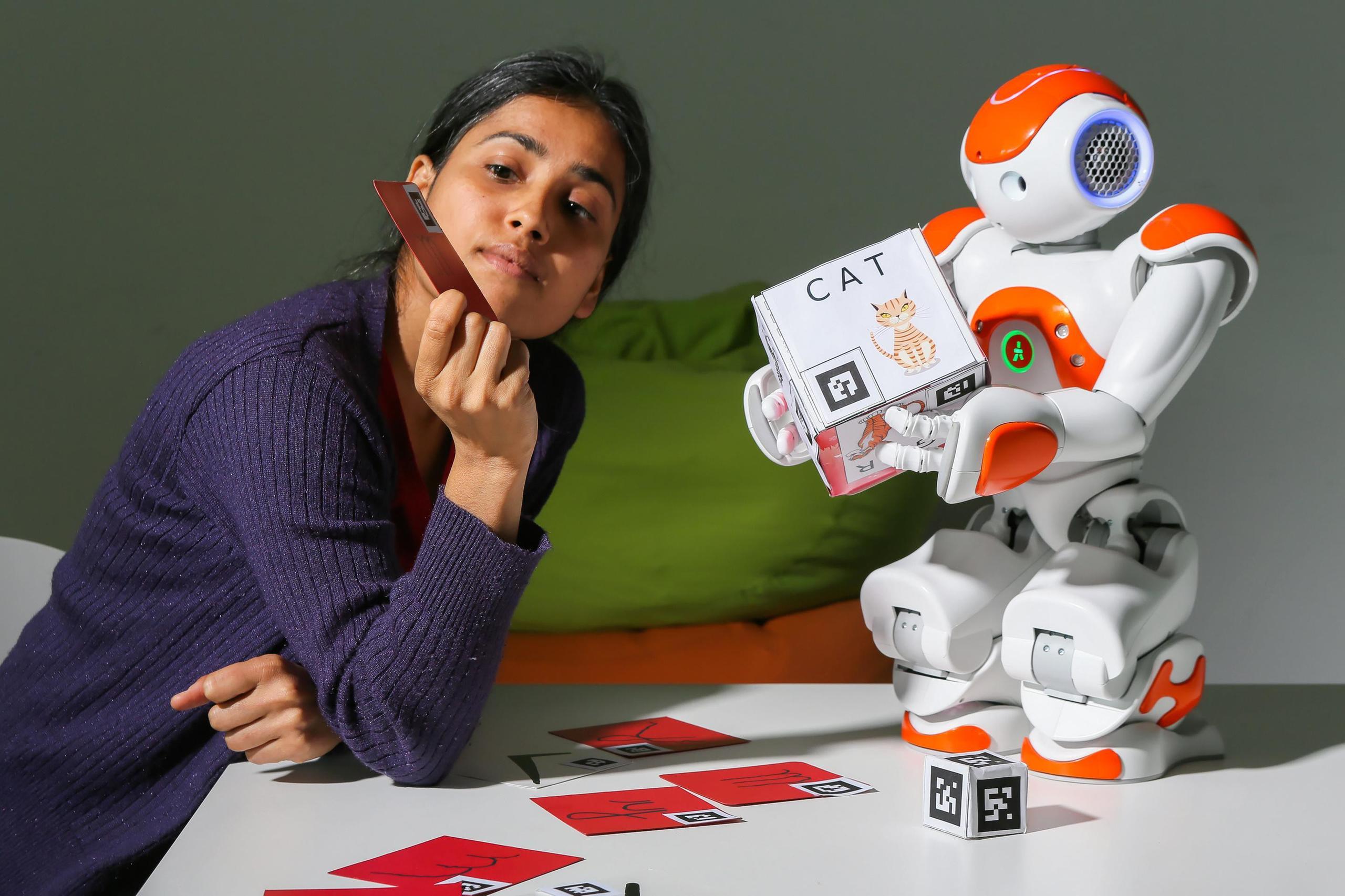

شاهد كيف يعرض باحثو معهد “ايدياب” للجمهور كيفية عمل الذكاء الاصطناعي وما الذي يُمكنه القيام به:

يُحاول معهد “إيدياب” للأبحاث أن يُبين للجمهور الدور الذي تؤديه البيانات المركزية في الذكاء الاصطناعي من خلال تقديم عدد من العروض الإيضاحية التي ستُعرض في متحف اليد بمدينة لوزانرابط خارجي اعتباراً من أول أبريل 2022.

فعلى سبيل المثال، ستتاح للجمهور الفرصة ليشاهد بشكل مباشر كيف يمكن للتكنولوجيا القائمة على الذكاء الاصطناعي من وراء الكاميرات في هواتفنا الذكية أن تُحسّن بشكل كبير جودة الصور منخفضة الدقة أو، على العكس من ذلك، جعلها أسوأ اعتماداً على البيانات التي زُودت بها.

وتلك ليست عملية سهلة: فهي تتطلب إدخال الكثير من البيانات ذات النوعية الجيدة التي يجب أن تكون مشروحة، أو “مسماة” بواسطة الإنسان (حتى وإن لم يتم ذلك كلياً بطريقة يدوية) بغية جعلها مفهومة بالنسبة للآلة. ويقول مايكل ليبلينغ، الذي يرأس مجموعة التصوير الحيوي الحاسوبي التابعة لمعهد “إيدياب” للأبحاث: “إننا لا نتعامل مع شيء قائم بذاته، بل مع نظام يتغذى على البيانات”.

كل ذلك لا يعني أن الذكاء الاصطناعي آمن تماماً. فمحدودية الآلة تتوقف على محدودية البيانات المتاحة. وبحسب ليبلينغ، يجب أن يجعلنا ذلك نفكر أين يكمن الخطر الحقيقي. وأضاف ليبلينغ: “هل يتمثل الخطر حقاً في سيطرة آلة الخيال العلمي على العالم؟ أم في الطريقة التي نوزع بها البيانات ونشرحها؟ أنا شخصياً، أعتقد أن التهديد يكمُنُ في الطريقة التي تُدار بها البيانات وليس في الآلات نفسها”.

المزيد

“الذكاء الاصطناعي لن يَحِلّ مَحلَّ البشر”

هناك حاجة للمزيد من الشفافية

تدرك شركات التكنولوجيا العملاقة، مثل غوغل وفيسبوك، قوة النماذج المزوَّدة بكميات كبيرة من البيانات إدراكاً تاماً، وقد بنت أعمالها التجارية حولها. وهذا الجانب، إضافة إلى التشغيل الآلي لبعض المهام البشرية، هو أكثر ما يثير قلق الأوساط العلمية. فحتى الباحثة السابقة في شركة غوغل، تيمنيت غيبرو، طُردت بسبب انتقادها النماذج اللغوية الهائلة والغامضة التي يقوم عليها محرك البحث الأكثر استخداما في العالم.

وتتمثل حدود نماذج التعلم الآلي في أنها لا تملك، حتى الآن على الأقل، قدرة تضاهي قدرتنا على التفكير. فهي قادرة على إعطاء إجابات، لكنها لا تستطيع تفسير سبب توصلها إلى مثل هذا الاستنتاج. ويقول أندريه فريتاس، الذي يرأس مجموعة الأبحاث المعنية بالذكاء الاصطناعي التفسيري والاستدلالي في معهد “إيدياب”: “يتعيّن عليك أيضاً أن تجعل تلك النماذج شفافة ومفهومة لجمهور من الناس”.

وهو يشير بالمناسبة إلى أن الخبر السّار هو أن الأوساط المعنية بالذكاء الاصطناعي، التي ركزت في الماضي في المقام الأول على تحسين الأداء ودقة النماذج، تسعى الآن أيضاً إلى تطوير نماذج تتسم بأنها أخلاقية وقابلة للتفسير وآمنة ونزيهة.

عمليا، تقوم مجموعة الأبحاث التي يرأسها فريتاس ببناء نماذج للذكاء الاصطناعي قادرة على تفسير الاستنتاج الذي تتوصل إليه. فعلى سبيل المثال، لن يكون بمقدور تلك النماذج أن تتنبأ وتقدم التوصيات بشأن موعد إدخال المرضى المصابين بكوفيد-19 إلى وحدات العناية المركزة فحسب، بل ستكون أيضاً قادرة على تقديم شرح للطاقم الطبي عن كيفية توصلها إلى تلك الاستنتاجات وعن ماهية أوجُه القصور المحتملة للنموذج باستخدام النموذج نفسه.

ويقول فريتاس: “إننا من خلال بناء نماذج للذكاء الاصطناعي قادرة على تفسير نفسها للعالم الخارجي، يُمكننا أن نزود المستخدمين بالأدوات اللازمة كي يحظوا بنظرة انتقادية فيما يتعلق بمكامن قوة النموذج ومواطن ضعفه”. والغرض من ذلك هو تحويل الخوارزميات المعقدة والمصطلحات التقنية إلى شيء مفهوم وسهل المنال. وفي الوقت الذي بدأت فيه تطبيقات الذكاء الاصطناعي تتغلغل في شتى مناحي حياتنا، يوصي فريتاس قائلاً: “إذا وقعتَ على نظام ذكاء اصطناعي، تحدَّه أن يفسّر نفسه”.

المزيد

ما الذي يحدث عندما تتخلى غوغل عن “أخلاقياتها”؟

التوهّم بأنه ذكاء

غالبا ما يُوصف الذكاء الاصطناعي بأنه القوة الكامنة خلف التقنيات الراهنة. لذا، فهو يثير تلقائياً الاهتمام والتطلعات الكبيرة. إذ أصبحت الحواسيب التي تستخدم نماذج الشبكة العصبية المستوحاة من طريقة عمل الدماغ البشري، تُبلي بلاءً حسناً في مجالات لم يكن من الممكن التفكير فيها سابقاً. وتقول لونيكي فان دير بلاس، قائدة مجموعة الحوسبة والإدراك واللغة في معهد “إيدياب”: “إن ذلك جعلنا نعتقد أن الذكاء الاصطناعي سيُصبح ذكياً بقدر ذكائنا وأنه سيحل مشاكلنا كلها”.

وتعطي فان دير بلاس مثالاً عن التقدم المتزايد للقدرات في مجال الأدوات اللغوية، مثل المُساعدين الافتراضيين أو أدوات الترجمة الآلية. إذ تقول بشأن تلك القدرات: “إنها تجعلنا منبهرين وتحملنا على الاعتقاد أنه إذا كان بمقدور الحاسوب الانخراط في شيء معقد كاللغة، فلا بد من وجود ذكاء كامن فيه”.

وباستطاعة الأدوات اللغوية تقليدنا لأن النماذج الأساسية قادرة على تعلم أنماط من كميات كبيرة من النصوص. ولكن إذا قارنا قدرات المساعد الافتراضي (المفعَّل صوتياً) بقدرات طفل عادي عندما يتحدث كل منهما عن طائرة ورقية مثلاً، نلاحظ أن المساعد الافتراضي يحتاج إلى الكثير من البيانات كي يصل إلى مستوى الطفل، إضافة إلى أنه سيُواجه مشقة في تعلم المعارف البسيطة، كالحس المنطقي السليم مثلاً. وتقول فان دير بلاس: “إنه من السهل أن ننخدع، فتمتع الآلة بقدرات بشرية لا يعني تلقائياً تمتعها بذكاء بشري”.

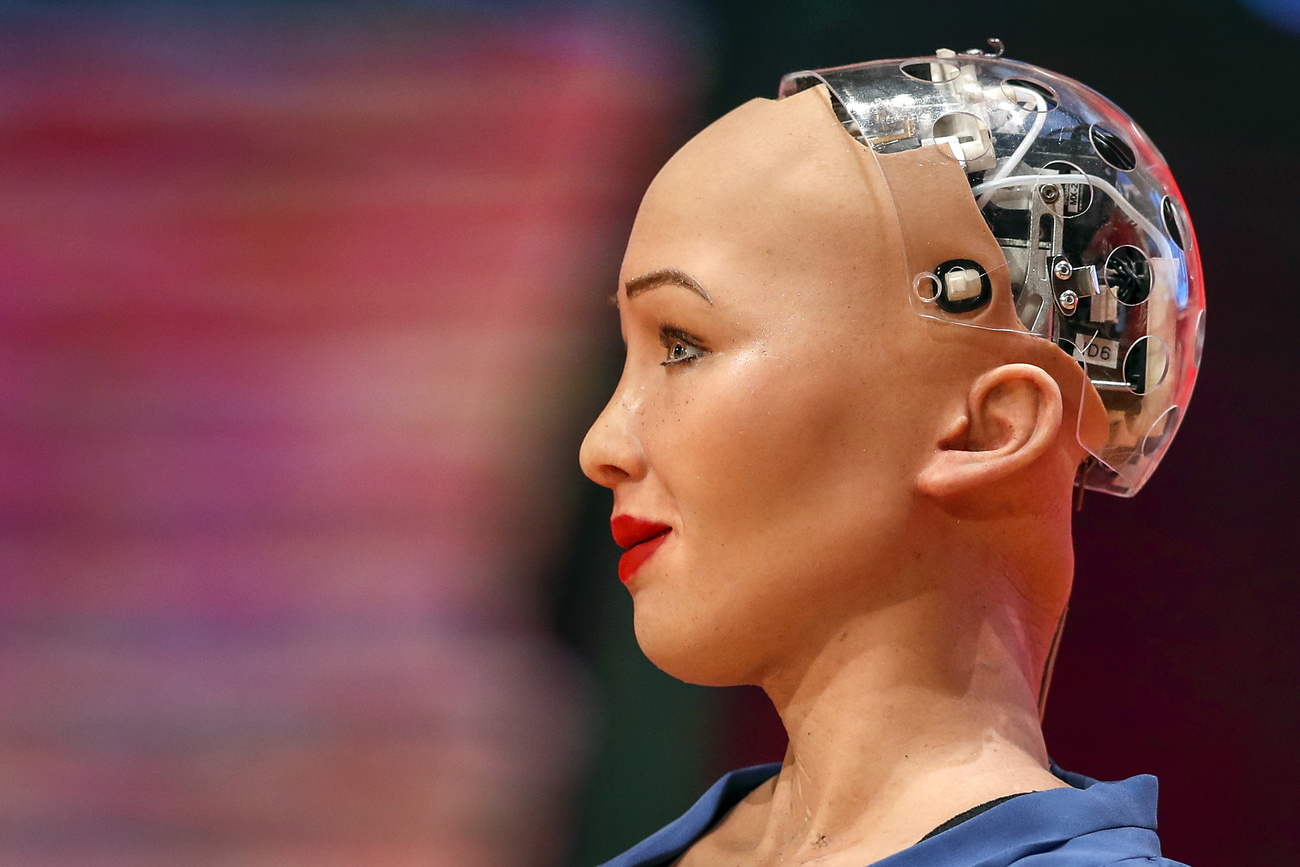

وفي نهاية المطاف، لقد سبق أن قال تورينغ قبل سبعين عاماً: “إنه لا داعي لمحاولة أنسنة “آلة التفكير” من خلال تزيينها وتجميلها. فقيمة الكتاب لا تُقاس بشكل غلافه”.

المزيد

متوافق مع معايير الصحافة الموثوقة

المزيد: SWI swissinfo.ch تحصل على الاعتماد من طرف "مبادرة الثقة في الصحافة"

يمكنك العثور على نظرة عامة على المناقشات الجارية مع صحفيينا هنا . ارجو أن تنضم الينا!

إذا كنت ترغب في بدء محادثة حول موضوع أثير في هذه المقالة أو تريد الإبلاغ عن أخطاء واقعية ، راسلنا عبر البريد الإلكتروني على arabic@swissinfo.ch.