人工智慧真像我們以為的那麼有智慧嗎?

電腦正越來越多地替我們做出重要決定。我們應該放手嗎?瑞士Idiap研究院的團隊向我們說明,為何機器智能基本上還只是一種假象。

阅读本文简体字版本请 点击这里

機器會思考嗎?這是英國數學家艾倫·圖靈(Alan Turing)在其最著名論文(英)外部链接中提出的開放性問題。這篇1950年發表的論文為人工智慧的構想與定義奠定了基礎。為了回答自己的問題,圖靈發明了“模仿遊戲”(imitation game),如今仍被用於判斷機器的智能。

這個遊戲後來以“圖靈測試”之名為人所知,遊戲包括三個參加者:代號A的參加者是名男性,代號B的參加者為女性,而代號C的參加者扮演提問者,其性別不限。提問者不能看到另兩位參加者,只能通過書面方式提出一系列問題,並根據得到的答案來判斷誰是男性,誰是女性。男回答者的目的是用有誤導性的答案欺騙提問者,而女回答者則必須便利對她正確身份的識別。

現在,設想電腦代替了參加者A。圖靈寫道,如果提問者無法分辨人和電腦,那麼這台電腦應被認為具有智能,因為它被證明具有類似人類的認知能力。

70年後,測試的結果令人震驚。 “目前,沒有一個人工智慧係統-確實一個也沒有-能通過第一次圖靈測試,”Idiap研究院院長埃爾韋·布爾拉(Hervé Bourlard)說道。該研究院專攻人工智慧和認知。

相关内容

人工智能面临伦理考验

既不人工,也不智慧

布爾拉聲稱早在20世紀70年代,“人工智慧”一詞就因被視作過時滑稽而不再使用,到90年代“出於廣告、營銷和商業原因”重新時髦起來。這位電子工程學教授補充說:“可是人工智慧除了數學模型能力外,沒有任何真正的進步。”

他對“人工智慧”一詞及其如今的使用方式仍持懷疑態度。他指出,就不存在“人工智慧”這樣東西,因為沒有哪個系統反映出哪怕是一丁點的人類智能。即使是兩三個月大的嬰兒,也能做人工智慧機器永遠做不到的事。

一個簡單的例子就足以說明這一點:拿起桌上的一杯水。連嬰兒都明白,如果把杯子倒過來,杯裡就沒有水,成了空杯子。 “這是為什麼嬰兒喜歡打翻杯子。世界上沒有一台機器能明白這個區別,”布爾拉表示。

這個例子所展示的,也同樣適用於常識。在布爾拉看來,機器永遠也模仿不了人類特有的這種能力。

智慧在於數據

然而,人工智慧已在許多行業的企業里站穩腳跟,越來越多地效力於多種領域的決策過程,例如人力資源、保險、銀行貸款,諸如此類。

通過分析網路上的人類行為,機器正在了解我們都是誰、我們喜歡什麼。然後搜尋引擎過濾掉較不相干的資訊,在社交媒體上向我們推薦可看的電影、可讀的新聞,或者我們可能喜歡的衣服。

但這仍然不會使人工智慧就真的有智慧了,布爾拉指出。 1996年布爾拉就接手了Idiap的管理工作,他很喜歡談論機器學習。他說,有三樣東西讓人工智慧以自己的方式變得強大:計算能力、數學模型,以及龐大和無處不在的數據庫。

愈發強大的電腦和資訊的數字化,使得數學模型獲得極大的改進。而擁有無限數據庫的網路,則完成了其餘的工作,推動人工智慧係統的能力步步深化。

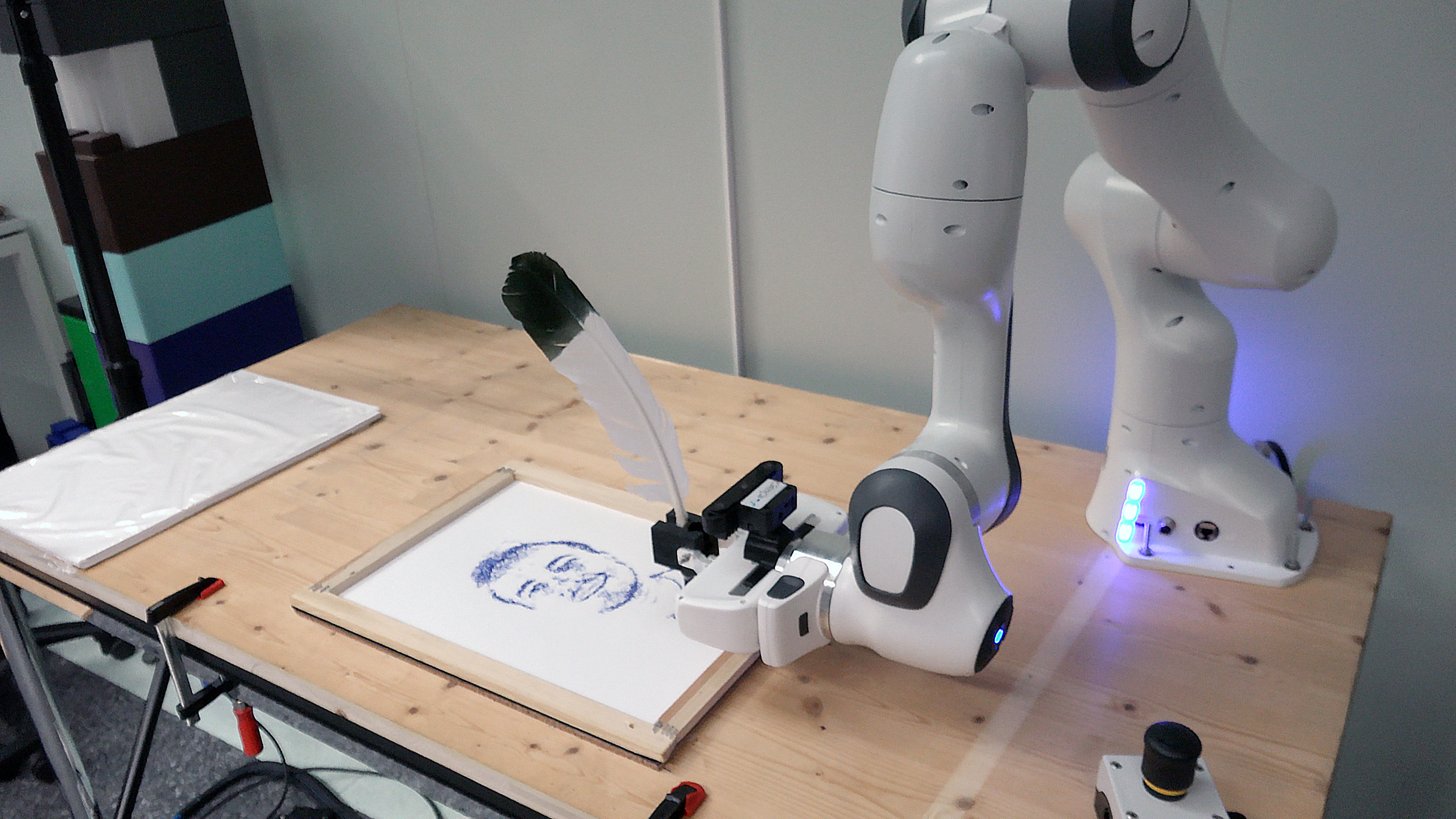

觀看Idiap研究人員向公眾展示人工智慧的工作原理及能做的事:

相关内容

參觀人工智慧實驗室

Idiap研究院嘗試通過一些演示,向公眾表明數據對人工智慧係統而言有多麼關鍵。這些演示將從4月1日起在洛桑的手博物館(Musée de la main,法)外部链接展出。

舉例來說,觀眾將有機會親眼看到,我們智能手機攝影機背後基於人工智慧的技術-取決於訓練它的數據量大小-可以極大地提高低分辨率圖像的質量,或者令其質量更差。

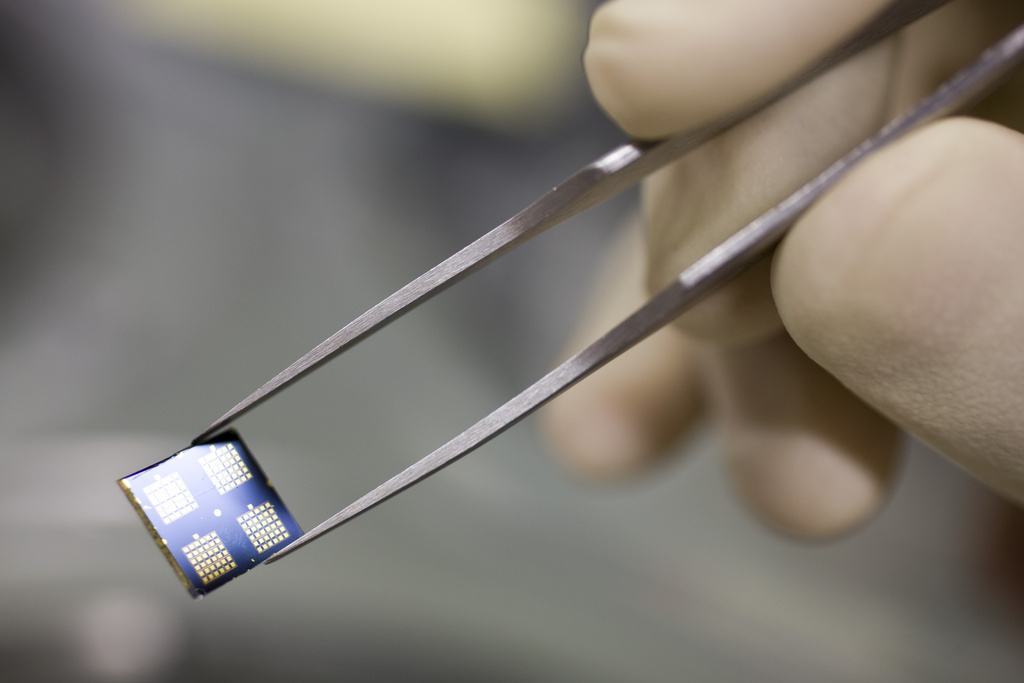

這個過程並不容易:需要許多必須由人(即使不是完全通過手工)加註(即“已添加標籤”)的優質數據,才能讓機器能夠“理解”。

“我們不是在處理一個有生命的東西,而是個需要供給大量數據的系統,”領導Idiap計算生物成像研究團隊的邁克爾·利布靈(Michael Liebling)解釋道。

這並不是說人工智慧就絕對安全。數據的侷限決定了機器的侷限。在利布靈看來,這應該使我們思考,真正的危險在哪裡。

“危險真的在於這個世界被科幻機器接管嗎?還是在於我們對數據的分配與加註?就我個人來說,我認為威脅在於數據的管理方式,而不在於機器本身,”他表示。

相关内容

人工智慧不會取代人類

需要更加透明

被供給了海量數據的各種模型擁有多大的能力,Google和Facebook等科技巨頭都非常清楚,也基於這種能力發展了各自的業務。最讓科學界擔憂的,就是這一方面,以及某些人工任務的自動化。

前Google研究員Timnit Gebru批評了這個世界最常用搜索引擎使用的非常巨大與不可測知的語言學模型,她因此甚至被解雇。

機器學習模型的侷限,是這些模型並未-至少還沒有-展示出可與我們的推斷力相提並論的能力。它們能夠提供答案,卻解釋不了為什麼會得出這個結論。

領導Idiap推理與可解釋性人工智慧研究團隊的安德烈·弗雷塔斯(André Freitas)說:“你還得使這些模型更為透明,讓人類受眾能夠理解。”

弗雷塔斯的研究團隊正在構建能夠解釋推理過程的人工智慧模型。其目的是要把複雜的算法與科技術語變成能夠理解、可為人所知的東西。隨著人工智慧開始滲透進我們的生活,他建議:“如果你遇到人工智慧係統,叫它解釋自己,以此來挑戰它。”

相关内容

谷歌炒掉自己的伦理专家后会发生什么?

智慧的假象

人工智慧常被描繪成今日科技背後的驅動力。因而它會自然而然地引起人們的興奮與很高的期望值。使用受人腦啟發而建的神經網絡模型的電腦,在此前無法想像的很多領域都大顯身手。 “這讓我們以為人工智慧會變得像我們一樣聰明,解決我們的一切問題,”領導Idiap計算、認知與語言研究團隊的羅內科·馮·德·普拉斯(Lonneke van der Plas)說道。

馮·德·普拉斯舉了語言工具日益進步的各種能力,例如虛擬助理或自動翻譯器。 “這些都叫我們啞口無言,我們以為,如果連語言這麼複雜的事電腦都能辦到,那麼它裡面必定有智能,”她解釋。

語言工具之所以能模仿我們,是因為裡麵包含的模型能夠從海量文本中習得各種模式。但我們若是拿(聲控)虛擬助理的能力與普通小孩的能力進行比較,比方說虛擬助理和小孩討論紙飛機時,工具就需要更多數據來達到小孩的程度-而且它將難以學到常識等普通的知識。 “要騙我們自己很容易,因為聽起來像人,並不意味著後面就有人的智能,”馮·德·普拉斯指出。

無論如何,圖靈70年前就說過:通過美化來人性化“思考機器”不值得嘗試。一本書的價值不取決於它的封面。

相关内容

(譯自英語:于雷)

符合JTI标准

您可以在这里找到读者与我们记者团队正在讨论交流的话题。

请加入我们!如果您想就本文涉及的话题展开新的讨论,或者想向我们反映您发现的事实错误,请发邮件给我们:chinese@swissinfo.ch。