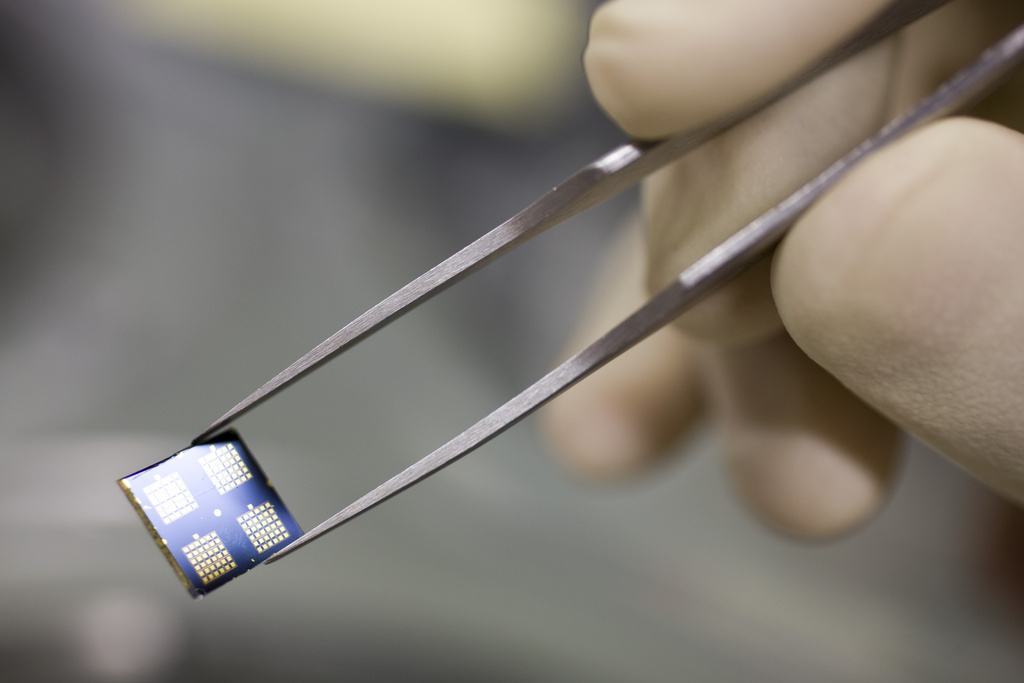

ChatGPT:人工的智能、愚蠢还是恶意?

它能回答所有问题,说起话来文绉绉。OpenAI的对话机器人ChatGPT是人工智能新时代的旗舰产物。但专家警告说,它和人脑比起来还差得很远,而且极端缺乏法律框架。

閱讀本文繁體字版本請 點擊此處

谁能躲开ChatGPT的重磅来袭?推出只四个月时间,仅在瑞士,平均每天就有10篇纸媒对它进行报道(媒体数据库smd.ch的统计结果)。如果再加上广播、电视、网络媒体和社交网络,可以说,很少有一个产品能受益于如此之多的媒体推广-而且完全免费。

最初是声声赞美,但随着对话机器人缺陷的逐步暴露,评论很快就变调了:ChatGPT无论是在信息可靠性,还是在对用户数据的保护方面均存在漏洞。

3月29日,一千名科技专家以 “对人类的重大风险 “为由,向企业界和各国政府发出请愿,要求冻结ChatGPT六个月。

三天后,意大利国家数据保护局决定禁止境内用户使用该产品。该机构指责ChatGPT在没有任何法律依据的情况下收集和储存信息以训练完善自身算法。该局要求OpenAI在20天内给出补救这一问题的措施,否则将被处以最高2000万欧元的罚款。

Unsurprisingly, after the pre-mature release of #ChatGPT外部链接, and the race to the bottom in terms of safety caused by Microsoft, Google or Facebook, GPT-4 is out.

— El Mahdi El Mhamdi | mastodon.social/@elmahdi (@L_badikho) March 14, 2023外部链接

It claims to "solve" a physics @polytechnique外部链接 entry exam. This will make it harder to calm down the hype in France… pic.twitter.com/dG47v4Rr8N外部链接

>> “不出所料,在ChatGPT过早发布以及微软、谷歌或Facebook在安全层面竞争的背景下,GPT-4出世了。”El Mahdi El Mhamdi说。这位巴黎综合理工学院的教授,曾在洛桑联邦理工学院Rachid Guerraoui教授的指导下完成博士论文。他一直在对人工智能缺乏监管的情况发出警告和批评。

为了更好地理解前因后果,我们需要了解一下ChatGPT是什么-以及更重要的:它不是什么。

你是电子的大脑吗?根本不是。

如果对方开门见山的提出这个问题,ChatGPT毫不掩饰自己的属性:”作为一个计算机程序,我与人脑有着根本的不同。”它继续解释说,它可以比人类更快地处理大量数据,而且不会忘记任何事情,但它缺乏情商、自我意识、灵感、创造性思维和独立做决定的能力。

这是因为人工智能的结构与人类大脑的结构完全不同。杰夫·霍金斯团队的新书《一千个大脑》(又译:千脑智能)对此作了精彩的解释。这位美国计算机工程师是20世纪90年代掌上电脑Palm的联合发明人,而Palm作为袖珍个人数字助理也预示着智能手机的出现。现在,霍金斯转而研究神经科学,且成为人工智能公司Numenta的老板。

该书的重要观点之一是:大脑能够创造很多“参照体系”,把个人所知道的一切“绘制”成数十万张 “地图”,建构起个人的“世界模型”,且不断地用从感官接收到的信息来修改完善着这一模型。但是人工智能既没有眼睛也没有耳朵,它只会吸收数据,而这些数据是固定的,不会进化。

相关内容

民主监管缺位,人工智能失控

不知道什么是猫?!

霍金斯用简单的例子说明了这一观点。例如,一项识别图像的人工智能技术能够识别一只猫。但它并不知道猫是一种动物,不知道它有尾巴、腿和肺,不知道有些人喜欢猫多于狗,也不知道猫会打呼噜或掉毛。换句话说,这台机器对猫的了解远不及一个五岁小孩。

为什么呢?因为孩子们见过猫,抚摸过它,听过它打呼噜,所有这些信息都丰富了其大脑中的 “猫地图”。而像ChatGPT这样的对话机器人的认知则完全依赖于单词序列和它们排列组合的可能性。

>> 在下方视频中,El Mahdi El Mhamdi和Rachid Guerraoui著作的联合作者Lê Nguyên Hoang讲述了他眼中ChatGPT的真正危险所在(法):

说得很好,而且往往很有道理

Rachid Guerraoui是瑞士洛桑联邦理工学院(EPFL)分布式计算实验室的负责人。他与合作者Lê Nguyên Hoang(也是Youtube频道 “Science4All “的主持人)在2020年发表了《海滩上的图灵-躺椅上的人工智能》(Turing à la plage, L’intelligence artificielle dans un transat)一书。

“大多数时候,ChatGPT说的都是真的。但它也经常会出大错。所以不应该盲目依赖它。“ Rachid Guerraoui,洛桑联邦理工学院

在Guerraoui看来,ChatGPT的主要风险之一是人们对其过度信任。”大多数时候,ChatGPT说的都是真的。至少写得像模像样,看起来似乎完全真实。但它也经常会出大错。所以不应该盲目依赖它。“

值得小心的是,不是每个人都有足够的批判思维来质疑机器人的话-特别是当它的言辞条理清晰,且没有拼写或语法错误时。

“我看到的另一个危险是,它促使人们放弃了责任,”这位教授继续道,”甚至公司也会使用对话机器人处理信息。但谁是信息来源,如果信息有误,谁来负责?这些问题却没有清楚的答案。“

Guerraoui是否担心人工智能会取代记者、作家甚至是教师的工作呢?目前还没有,但他能想象 “某些工作可能会发生变化。比如,教师或记者的工作将转向负责检查核对消息来源,因为即使机器人给出的文本内容看起来可信,且在大多数情况下是真实的,但我们依然要对一切进行核实。“

相关内容

政府和企业不会停止人工智能竞赛

亟待规范

El Mahdi El Mhamdi认为:”今天人工智能的最大挑战不是性能和绩效,而是管理、监督和可靠性。”

“在我看来,ChatGPT不仅被高估了,而且其过早的推出也是不负责任的、很危险的行为。” El Mahdi El Mhamdi,巴黎综合理工学院

2019年,他出版了(同样与Lê Nguyên Hoang合作)《奇幻工地-如何从人工智能中稳固受益》(Le fabuleux chantier – rendre l’intelligence artificielle robustement bénéfique)一书,主要论述所谓推荐算法的危险。

“在我看来,ChatGPT不仅被高估了,而且其过早的推出也是不负责任的、很危险的行为。”这位教授警告说。”当我看到人们-甚至包括我的一些同事-对这个工具表达出无限热情时,我真的万分不解。“他例举了几个令人警醒的案例。比如剑桥分析公司数据泄露丑闻,或者像Pegasus这样可以秘密安装在手机上的间谍软件的扩散。

El Mhamdi承认ChatGPT可以成为一个很好的工作辅助工具,但他同时提醒说,ChatGPT所依赖的科学基础是 “在过去十年间,数千名研究人员发表的学术内容、巨大的工程学积累以及在伦理上颇有争议的肯尼亚工人的底薪工作(具体内容请见下方信息框)。

最后,El Mhamdi说,”OpenAI真正的天赋不在于ChatGPT的科学依托,而在于营销,因为后者,它受到小工具爱好者的追捧。”

(编译自法语:郭倢,编辑:Sabrina Weiss)

人工智能设计师必须教机器工作-后者没有价值观、良知或道德-以分辨什么是允许的,什么是不允许的。要让机器做到这一点,必须向它提供有关人类卑劣先例的信息,以便机器能够识别和避免同样情况的发生。

2023年1月,美国《时代》杂志的一项调查揭露出OpenAI将这一操作外包的真相。从2021年11月开始,该公司将数以万计的互联网有毒文本摘录发送给加利福尼亚公司Sama,该公司主要在其位于肯尼亚内罗毕的分支机构内对这些文本进行解构。在那里,大约30名员工必须每天花9个小时阅读和标记强奸、酷刑、恋童癖和恋童癖行为的精确描述。所有这些工作,每小时仅挣两美元。

由于没有人能够在在处理这类恐怖文字中毫发无损,具有 “伦理”标签的Sama公司为这些“阴影下的员工”提供了心理支持。但据《时代》周刊匿名采访的前雇员称,这些措施远远不够。从那以后,OpenAI中止了和Sama公司的合同。

符合JTI标准

您可以在这里找到读者与我们记者团队正在讨论交流的话题。

请加入我们!如果您想就本文涉及的话题展开新的讨论,或者想向我们反映您发现的事实错误,请发邮件给我们:chinese@swissinfo.ch。