Des chercheurs suisses chassent les «deepfakes»

Les vidéos truquées à l'aide de l'intelligence artificielle deviennent toujours plus sophistiquées. Des experts en Suisse romande réévaluent les risques que leur utilisation malveillante fait courir à la société, tout en mettant au point des outils innovants pour arrêter leurs auteurs.

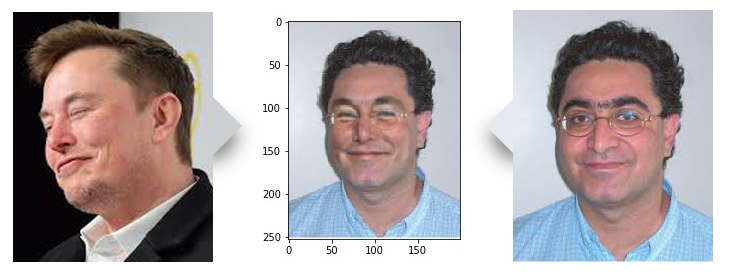

Dans un laboratoire informatique du vaste campus de l’École polytechnique fédérale de Lausanne (EPFL), l’équipe d’ingénieurs du Multimedia Signal Processing GroupLien externe contemple l’image d’un homme souriant, à lunettes, au teint rosé et aux boucles sombres.

«Oui, elle est bonne», lâche le chercheur en chef Touradj Ebrahimi, qui ressemble un peu à l’homme sur l’écran. L’équipe a fondu son portrait avec celui d’Elon Musk, le fondateur de Tesla. Cette technique de synthèse d’images basée sur l’intelligence artificielle permet de produire des vidéos ou des images où l’on se fait passer pour un autre.

C’est l’une des nombreuses falsifications – certaines plus réalistes que d’autres – que l’équipe de l’EPFL a créées. Cela en développant un logiciel, en collaboration avec la société de cybersécurité Quantum Integrity Lien externe(QI), qui peut détecter les images truquées, y compris les deepfakes.

Grâce au «machine learning» (apprentissage statistique), le même procédé que pour les deepfakes, le logiciel apprend à faire la différence entre le vrai et le faux.

«Avec beaucoup d’entraînement, ce programme peut aider à détecter les faux comme le ferait un humain», détaille M. Ebrahimi. «Plus on l’utilise, meilleurs sont ses résultats.»

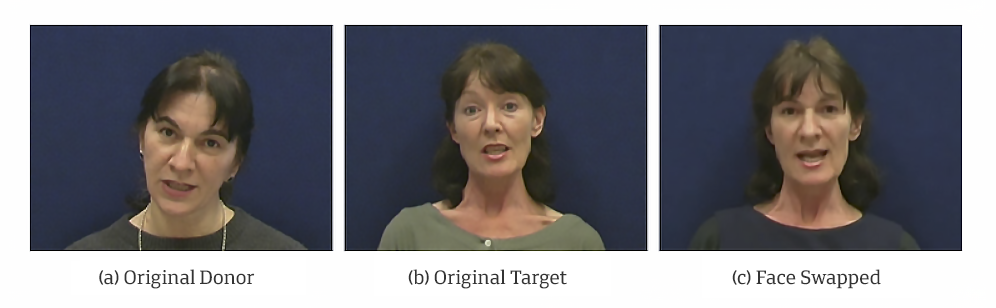

Les photos et vidéos contrefaites existent depuis longtemps. Mais ce n’est que récemment que les techniques d’IA ont permis aux faussaires de modifier les visages dans une vidéo ou de faire croire que la personne prononce des paroles qu’elle n’a jamais dites.

La fabrication de vidéos truquées est devenue «exponentiellement plus rapide, plus facile et moins chère», grâce à des logiciels accessibles et faciles à utiliser et des services payants, selon l’International Risk Governance Center (IRGC) de l’EPFL.

«C’est précisément parce que ce domaine évolue si vite que nous devons déterminer où cela pourrait conduire, quels secteurs, groupes et pays pourraient être touchés», relève son directeur adjoint, Aengus Collins.

Bien qu’une grande partie de ces images malintentionnées utilisent le registre de la pornographie, il devient urgent de se préparer à l’utilisation de ces techniques pour manipuler l’opinion publique.

Un domaine qui évolue rapidement

Quand Touradj Ebrahimi a commencé à travailler avec QI sur un logiciel de détection il y a trois ans, les deepfakes n’étaient pas dans le radar de la plupart des chercheurs. À l’époque, les clients de QI étaient préoccupés par les images truquées d’accidents en vue de demandes d’indemnisation frauduleuses auprès des assurances. En 2019, cependant, les deepfakes ont atteint un niveau de sophistication tel que Quantum Integrity a décidé de consacrer beaucoup plus de temps à cette question.

«Je ne pensais pas que la technologie évoluerait aussi vite», déclare Anthony Sahakian, directeur général de QI.

Ce dernier a pu constater par lui-même à quel point ces techniques de contrefaçon ont permis d’obtenir des résultats réalistes, comme récemment l’échange de visages sur une photo de passeport qui parvient à laisser intacts tous les sceaux du document.

En outre, le nombre de vidéos truquées en ligne a presque doublé en neuf mois pour atteindre 14’678 en septembre 2019, selon une estimation de DeeptraceLien externe, une société néerlandaise de cybersécurité.

L’IA pour créer et détecter

Cette technologie peut provoquer la panique dans certains milieux, mais tout le monde ne s’accorde pas à dire que les vidéos truquées sont suffisamment réalistes pour tromper la plupart des utilisateurs. Les experts affirment que la qualité des deepfakes dépend encore aujourd’hui en grande partie des compétences du créateur. L’échange de visages sur une vidéo entraîne inévitablement certaines imperfections dans l’image, explique l’expert en sécurité biométrique Sébastien Marcel.

«La qualité sera très variable, en fonction de l’intervention manuelle effectuée pour agrandir l’image, dit-il. Si le créateur fait l’effort de peaufiner le résultat, le faux peut être très difficile à détecter.»

Sébastien Marcel et ses collègues de l’Institut de recherche IdiapLien externe à Martigny, dans le canton du Valais, travaillent sur leur propre logiciel de détection, dans le cadre d’un projet sur la manipulation des visages et des voix dans les séquences vidéo.

«Ce problème ne sera pas résolu aujourd’hui, souligne Sébastien Marcel. C’est un sujet de recherche en pleine expansion, nous prévoyons donc d’y consacrer davantage de ressources.»

Pour l’aider à tirer parti de certains résultats initiaux, l’institut à but non lucratif participe à un défi lancé par Facebook pour produire un logiciel de détection de deepfakes. Le géant des réseaux sociaux s’engage à verser plus de 10 millions de dollars aux chercheurs du monde entier (voir encadré).

Mais l’objectif fait débat: «Il est peu probable que ce concours fournisse une solution miracle, souligne Aengus Collins. Quel que soit l’ensemble des techniques de détection, un adversaire finira par trouver un moyen de les contourner.»

Le jeu du chat et de la souris

Anthony Ebrahimi et Sébastien Marcel affirment tous deux que leur but n’est pas de proposer un outil à sécurité intégrée. Une partie du travail consiste à anticiper la direction suivie par les manipulateurs et les méthodes qu’ils utilisent pour y parvenir.

Sébastien Marcel prévoit un avenir où les créateurs pourront non seulement changer un élément d’une vidéo, comme le visage, mais l’image entière: «La qualité des deepfakes va s’améliorer, nous devons donc aussi améliorer les détecteurs», pour que le rapport coût-bénéfice de la fabrication de deepfakes malveillants ne soit plus en faveur du créateur.

Anthony Ebrahimi estime, lui, qu’un événement majeur, comme les prochaines élections présidentielles aux États-Unis, pourrait inciter les acteurs malveillants à accélérer leur travail.

Mais il faudra peut-être des mois ou des années avant que l’œil exercé ne soit plus capable de repérer un faux, dit-il, et à ce moment-là, seules les machines auront la capacité de faire la distinction.

Les plates-formes de réseaux sociaux prennent des mesures

En mars 2020, Twitter a introduit une nouvelle règlementation contre le partage de contenus médiatiques synthétiques ou manipulés qui peuvent causer des dommages. Parmi les mesures, figure l’étiquetage de ces tweets et la diffusion d’avertissements aux utilisateurs. YouTube, propriété de Google, s’est engagé à ne pas tolérer les vidéos truquées liées aux élections et au recensement américains de 2020 qui visent à induire le public en erreur. Facebook a lancé un défi, d’une valeur de plus de 10 millions de dollars, pour soutenir les chercheurs en détection dans le monde entier. Facebook et Google ont tous deux publié des ensembles de données d’images truquées pour aider les chercheurs à développer des techniques de détection.

Deepfakes pour le bien

Les «deepfakes» les plus diffusés ont un caractère parodique, impliquant des individus très en vue, comme des célébrités et des personnalités politiques, selon l’International Risk Governance Center (IRGCLien externe), qui souligne que «tous les deepfakes ne sont pas créés dans un but malveillant». Hollywood a également mis au point des technologies pour permettre le retour au cinéma d’acteurs décédés depuis longtemps. Antony Ebrahimi, de l’EPFL, affirme que, si tout se passe comme prévu, un sous-produit du projet EPFL/QI pourrait être l’utilisation éventuelle de cette même technologie pour créer des effets spéciaux de film.

Selon l’IRGC, d’autres utilisations positives des techniques de contrefaçon sont la synthèse vocale à des fins médicales et la médecine légale numérique dans les enquêtes criminelles.

Traduit de l’anglais par Frédéric Burnand

En conformité avec les normes du JTI

Plus: SWI swissinfo.ch certifiée par la Journalism Trust Initiative

Vous pouvez trouver un aperçu des conversations en cours avec nos journalistes ici. Rejoignez-nous !

Si vous souhaitez entamer une conversation sur un sujet abordé dans cet article ou si vous voulez signaler des erreurs factuelles, envoyez-nous un courriel à french@swissinfo.ch.