«KI wird auf dem Schlachtfeld zunehmend eingesetzt»

Der Einsatz von Killerrobotern auf dem Schlachtfeld beunruhigt Menschenrechtsaktivist:innen. Georgia Hinds, Rechtsberaterin beim Internationalen Komitee vom Roten Kreuz, betont die dringende Notwendigkeit eines verbindlichen Abkommens, das autonome Waffen bis 2026 verbietet und einschränkt.

«Lavender» – eine von der israelischen Armee entwickelte Software mit künstlicher Intelligenz – identifizierte bis zu 37’000 potenzielle Ziele im GazastreifenExterner Link.

Laut israelischen GeheimdienstquellenExterner Link berücksichtigte das Programm eine Fehlerquote von 10% und erhielt die Erlaubnis, je nach Rang des anvisierten Hamas-Mitglieds zwischen 15 und 300 Zivilpersonen als «Kollateralschaden» zu töten.

Israel ist keine Ausnahme. Überall auf der Welt wird der Krieg digitaler, schneller und automatisierter, so dass dem Menschen nur wenige Sekunden bleiben, um den Abzug zu betätigen – oder gar keine Zeit mehr.

Die Vereinten Nationen und humanitäre Organisationen befürchten eine Zunahme von Kriegsverbrechen im Zusammenhang mit diesen Technologien, die sich schneller entwickeln als ihre Regulierung.

Am Rand des UNO-Gipfels «AI for Good», der am 30. und 31. Mai in Genf stattfand, sprach SWI swissinfo.ch mit Georgia Hinds, Rechtsberaterin für neue Kriegstechnologien beim Internationalen Komitee vom Roten Kreuz (IKRK).

Sie hat Mitte Mai zwei neue BerichteExterner Link über die Auswirkungen der künstlichen Intelligenz auf die militärische Entscheidsfindung und deren Folgen für Zivilpersonen, Kombattanten und das Recht veröffentlicht.

SWI swissinfo.ch: Wie sehen die verschiedenen militärischen Anwendungen der KI heute aus?

Georgia Hinds: Künstliche Intelligenz wird auf dem Schlachtfeld zunehmend in mindestens drei Schlüsselbereichen eingesetzt.

Der erste Bereich sind Cyber- und Informationsoperationen, welche die Art und die Verbreitung von Informationen verändern, beispielsweise durch den Einsatz von «Deepfake-Technologie», mit der sehr realistische – aber gefälschte – Inhalte erzeugt werden können.

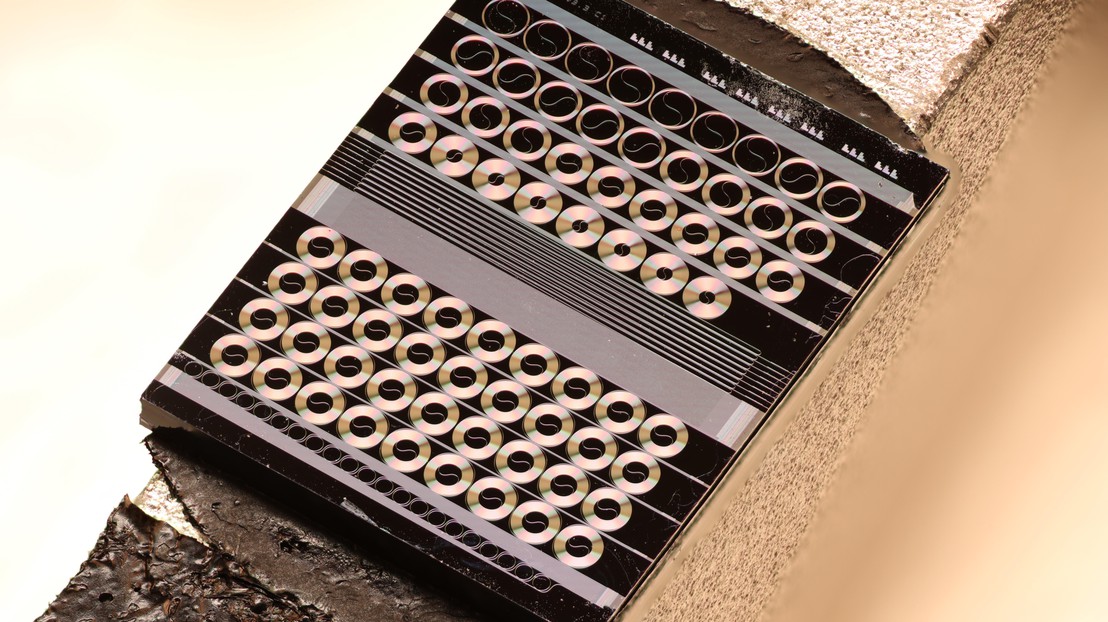

Eine weitere wichtige Anwendung sind Waffensysteme, bei denen KI eingesetzt wird, um Funktionen wie die Zielauswahl oder die Auslösung eines Angriffs teilweise oder vollständig zu steuern, wie dies bei autonomen Waffensystemen (Autonomous Weapon Systems, AWS) der Fall ist.

Und schliesslich wird KI in Werkzeugen eingesetzt, die als Informationsquelle für militärische Entscheide dienen können, etwa durch die Modellierung der Auswirkungen einer Waffe. Aber unterdessen auch, um komplexere Empfehlungen zu potenziellen Zielen oder Vorgehensweisen zu geben.

Mehr

Die Maschine und die Moral

SWI: Kann die Regulierung mit der rasanten technologischen Entwicklung Schritt halten?

GH: Wir müssen uns vor Augen halten, dass sich KI nicht von selbst entwickelt. Der Mensch entscheidet sich für die Entwicklung dieser Technologie. Und er entscheidet auch, wann und wie er sie auf dem Schlachtfeld einsetzt.

Das humanitäre Völkerrecht (HVR) regelt militärische KI oder autonome Waffen nicht ausdrücklich. Allerdings ist es «technologieneutral». Das heisst, seine Regeln gelten für den Einsatz jeder Waffe oder Art der Kriegsführung – in diesem Sinn gibt es also keine Regelungslücke.

Menschliche Befehlshaber bleiben weiterhin dafür verantwortlich, dass bei jedem Angriff die Prinzipien der Unterscheidung (nur auf Kombattanten oder militärische Ziele abzielen), der Verhältnismässigkeit (Vermeidung unverhältnismässiger Schäden für die Zivilbevölkerung) und der Vorbeugung (Ergreifen aller möglichen Massnahmen, um Schäden für die Zivilbevölkerung zu vermeiden) eingehalten werden, unabhängig davon, welche Technologie eingesetzt wird.

Dennoch halten wir es für dringend erforderlich, besonders im Hinblick auf autonome Waffen, neue rechtsverbindliche Regeln aufzustellen, um mehr Klarheit und Orientierung zu schaffen, wie das humanitäre Völkerrecht anzuwenden ist, um bestimmte AWS zu verbieten und den Einsatz anderer zu beschränken.

Diese Art von Anleitung ist nicht nur für Armeen notwendig, sondern auch für die Industrie, für die Entwickler und auch, um die breiteren Bedenken zu adressieren, die diese Waffen aufwerfen, einschliesslich humanitärer, ethischer und sicherheitsbezogener Gesichtspunkte.

SWI: Welche Massnahmen sollten ergriffen werden, um autonome Waffensysteme (AWS) zu regulieren?

GH: Das IKRK definiert autonome Waffen als Systeme, die ohne menschliches Eingreifen Ziele auswählen und Gewalt anwenden.

Und wir haben einen neuen, verbindlichen Vertrag gefordert, der bis 2026 abgeschlossen werden soll, um bestimmte autonome Waffen zu verbieten und strenge Auflagen für die Entwicklung und den Einsatz aller anderen zu erlassen.

Ganz besonders müssen diese Regeln unberechenbare autonome Waffen verbieten (deren Auswirkungen nicht kontrolliert werden können, etwa wenn Maschinen von selbst «lernen») und solche, die sich direkt gegen Menschen richten.

Solche Regelungen sind dringend notwendig, um die menschliche Kontrolle über die Anwendung von Gewalt in bewaffneten Konflikten zu erhalten und damit die Auswirkungen des Kriegs zu begrenzen und wichtige Schutzmassnahmen nicht nur für Zivilpersonen, sondern auch für Kombattanten aufrechtzuerhalten.

SWI: 2023 rief der UNO-Generalsekretär zusammen mit dem Präsidenten des IKRK die Staaten auf, bis 2026 ein rechtsverbindliches Instrument zum Verbot tödlicher autonomer Waffen zu verabschieden. Inzwischen hat die UNO-Generalversammlung eine Resolution verabschiedetExterner Link, in der sie ihre Besorgnis über die Risiken autonomer Waffen zum Ausdruck bringt. Was sind die nächsten Schritte?

GH: In den kommenden Monaten wird der UNO-Generalsekretär einen umfassenden Bericht über autonome Waffen vorlegen, der sich auf die Ansichten von Staaten, aber auch von internationalen und regionalen Organisationen wie dem IKRK, der Zivilgesellschaft, der Wissenschaft und der Industrie stützt.

Es wird dann Aufgabe der internationalen Gemeinschaft sein, auf der Grundlage der Empfehlungen dieses Berichts zu handeln, und wir fordern die Staaten nachdrücklich auf, Verhandlungen über ein rechtsverbindliches Instrument aufzunehmen, um sicherzustellen, dass wichtige Schutzmassnahmen auch für künftige Generationen erhalten bleiben.

Seit mehr als einem Jahrzehnt diskutieren die verschiedenen Organisationen in Genf die Risiken und Herausforderungen, die von autonomen Waffen ausgehen.

Dies geschieht im Rahmen der Konvention über bestimmte konventionelle Waffen, die darauf abzielt, den Einsatz von Waffen zu verbieten oder einzuschränken, deren Wirkung als übermässig verletzend oder unterschiedslos betrachtet wird.

Eine klare Mehrheit der Staaten befürwortet nun rechtsverbindliche Regeln, und wir sind optimistisch, dass diese Dynamik bis 2026 zu einem wirksamen Vertrag führen kann.

Mehr

Die Schweiz als Ideenlabor für den Roboter von morgen

SWI: Ende Mai fand in Genf der «AI for Good»-Gipfel statt. Kann künstliche Intelligenz eingesetzt werden, um zivile Opfer bei der Kriegsführung zu vermeiden und damit das humanitäre Völkerrecht besser zu achten?

GH: Es ist wichtig, jede Behauptung kritisch zu hinterfragen, dass neue Technologien die Kriegsführung irgendwie humaner machen werden.

Ähnliche Behauptungen haben wir in der Vergangenheit zum Beispiel im Zusammenhang mit chemischen Waffen und auch Drohnen gehört, und dennoch erleben wir weiterhin grosses Leid und die Verwicklung von Zivilpersonen in Konflikte.

Um mehr Menschlichkeit in die Kriegsführung zu bringen, muss der Einhaltung des humanitären Völkerrechts Vorrang eingeräumt werden, und zwar mit dem spezifischen Ziel, Zivilpersonen zu schützen.

Wir sind uns bewusst, dass bestimmte KI-Systeme die Entscheidungsträger bei der Einhaltung des Rechts unterstützen können, zum Beispiel bei der Kriegsführung in Städten, wenn sie den Befehlshabern zusätzliche Informationen über Faktoren wie zivile Infrastruktur und Bevölkerung liefern können.

Gleichzeitig müssen die Entscheidungsträger die Grenzen dieser Technologien verstehen und berücksichtigen, wie zum Beispiel erhebliche Datenlücken, Verzerrungen und Unvorhersehbarkeit.

SWI: Gemäss den Recherchen von Journalistinnen und Journalisten aus JerusalemExterner Link hat die israelische Armee im Gazastreifen ein ausgeklügeltes KI-System eingesetzt, um mutmassliche Hamas-Führer ins Visier zu nehmen. In einigen Fällen soll das Programm Berichten zufolge eine Fehlerquote von bis zu 100 toten Zivilist:innen pro Ziel toleriert haben. Was halten Sie davon? Wie können wir Länder zur Verantwortung ziehen, wenn es keine entsprechenden Gesetze gibt?

GH: Das IKRK ist eine neutrale, unparteiische humanitäre Organisation, und deshalb sehen wir im Allgemeinen davon ab, uns öffentlich zu bestimmten Einsätzen und Situationen in laufenden Konflikten zu äussern – dies sind Dinge, die Teil unseres vertraulichen, bilateralen Dialogs mit den Konfliktparteien sind.

Wie ich jedoch bereits erwähnt habe, gibt es in bewaffneten Konflikten keine rechtsfreien Räume oder Situationen. Das humanitäre Völkerrecht und der Verantwortungsrahmen gelten auch weiterhin unabhängig von den eingesetzten Mitteln.

Um diese Regeln auf einen Angriff anzuwenden, bei dem eine Armee ein KI-System eingesetzt hat, könnten wir untersuchen, ob es für einen Befehlshaber vernünftig war, sich auf die Ergebnisse eines KI-Systems zu verlassen. Und ob er alle erdenklichen Vorsichtsmassnahmen getroffen hat, um Schaden von der Zivilbevölkerung abzuwenden.

SWI: Verliert der Mensch die Kontrolle über seine Waffen?

GH: Der Verlust der menschlichen Kontrolle über die Wirkung von Waffensystemen ist eine unserer Hauptsorgen im Zusammenhang mit autonomen Waffensystemen, zumal wir einen Trend zu immer komplexeren Systemen mit erweiterten Betriebsparametern beobachten.

Derzeit gehen wir jedoch davon aus, dass die Streitkräfte ihre Waffensysteme weiterhin aus der Ferne steuern oder überwachen, selbst wenn bestimmte Waffen – wie bewaffnete Drohnen – mit der Möglichkeit des autonomen Betriebs beworben werden.

Es kommt jetzt darauf an, der Entwicklung und dem Einsatz autonomer Waffen klare Grenzen zu setzen, um sicherzustellen, dass diese Kontrolle über die Gewaltanwendung erhalten bleibt.

SWI: Bis 2030 könnte ein Viertel der britischen Armee aus RoboternExterner Link bestehen. Wie sehen Sie die Zukunft der Kriegsführung?

GH: Leider sieht die Zukunft der Kriegsführung schrecklich aus, unabhängig von der eingesetzten Technologie. Diese Realität geht manchmal verloren, wenn über neue Technologien gesprochen wird, weil diese Diskussionen weit weg vom Schlachtfeld stattfinden und neue Technologien irgendwie als sauber oder klinisch dargestellt werden.

Wir sind der Meinung, dass physische Robotertechnologien langsamer voranschreiten als die KI-Entwicklungen. Die weniger sichtbaren Fortschritte im Bereich der künstlichen Intelligenz geben Anlass zu unmittelbarer Sorge, und diese werden zweifellos irgendwann weitere Robotersysteme ermöglichen.

In naher Zukunft sehen wir die Integration von KI als Schlüsselmerkmal auf dem Schlachtfeld, nicht nur in Waffensystemen, sondern im gesamten Planungs- und Entscheidungszyklus, von der Bereitstellung von Empfehlungen bis hin zur Kontrolle von Aspekten der Waffensysteme bei Angriffen.

Die künftige Kriegsführung wird also zunehmend komplexer und unberechenbarer. Daher ist es unsere Priorität, die Aufmerksamkeit der internationalen Gemeinschaft auf die spezifischen Anwendungen von KI in bewaffneten Konflikten zu lenken, die das grösste Risiko für das Leben und die Würde von Menschen darstellen.

Editiert von Virginie Mangin; Übertragung aus dem Englischen: Michael Heger

In Übereinstimmung mit den JTI-Standards

![Félix Vallotton - Gabrielle Vallotton Seated in a Rocking Chair [1902]](https://www.swissinfo.ch/content/wp-content/uploads/sites/13/2025/06/53715547480_948a0f3612_o.jpg?ver=af84b45e)

Einen Überblick über die laufenden Debatten mit unseren Journalisten finden Sie hier. Machen Sie mit!

Wenn Sie eine Debatte über ein in diesem Artikel angesprochenes Thema beginnen oder sachliche Fehler melden möchten, senden Sie uns bitte eine E-Mail an german@swissinfo.ch