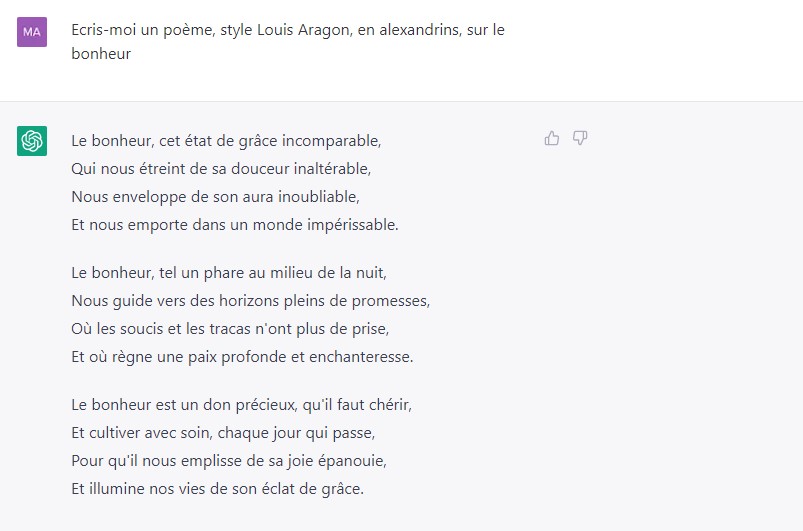

Ist die Künstliche Intelligenz dumm oder gefährlich?

Er hat auf alles eine Antwort und spricht wie ein Buch. Dennoch ist ChatGPT noch weit von einem menschlichen Verstand entfernt. Und Fachleute warnen: Es mangelt an einem gesetzlichen Rahmen.

Wer konnte sich ChatGPT-Welle entziehen? Seit der Einführung vor vier Monaten sind allein in den Printmedien der Schweiz im Durchschnitt 10 Artikel pro Tag über ChatGPT erschienen (erfasst auf smd.ch). Zählt man Radio, Fernsehen, Online-Medien und soziale Netzwerke hinzu, kann man sagen, dass selten ein Produkt eine derartige – völlig kostenlose – Einführungskampagne erlebt hat.

Die Kommentare waren anfangs überschwänglich, der Ton änderte sich aber schnell, als die Maschine ihre Schwachstellen offenbarte und Risiken sichtbar wurden: die Zuverlässigkeit der Informationen und der Schutz der Nutzer:innendaten.

Am 29. März riefen tausend Tech-Expert:innen Unternehmen und Regierungen in einer PetitionExterner Link dazu auf, die Entwicklung von KI für sechs Monate einzufrieren, und begründeten dies mit «grossen Risiken für die Menschheit». Darunter Steve Wozniak, Mitbegründer von Apple, und Elon Musk, der allerdings einer der ersten Geldgeber von OpenAIExterner Link ist, dem Unternehmen, das ChatGPT entwickelt.

Drei Tage später beschloss die nationale italienische Datenschutzbehörde, den Zugang zu sperrenExterner Link. Sie warf ChatGPT insbesondere vor, Informationen zu sammeln und zu speichern, um seine Algorithmen zu trainieren, dies ohne jegliche Rechtsgrundlage. Die Behörde forderte OpenAI auf, innerhalb von 20 Tagen mitzuteilen, welche Massnahmen ergriffen wurden, um diesen Zustand zu beheben. Sonst drohe eine Geldstrafe von bis zu 20 Millionen Euro.

Bereits am 27. März hatte Europol, die europäische Kriminalpolizeibehörde, in einem BerichtExterner Link ihre Besorgnis über die mögliche missbräuchliche Nutzung von ChatGPT durch Cyberkriminelle zum Ausdruck gebracht.

Unsurprisingly, after the pre-mature release of #ChatGPTExterner Link, and the race to the bottom in terms of safety caused by Microsoft, Google or Facebook, GPT-4 is out.

— El Mahdi El Mhamdi | mastodon.social/@elmahdi (@L_badikho) March 14, 2023Externer Link

It claims to "solve" a physics @polytechniqueExterner Link entry exam. This will make it harder to calm down the hype in France… pic.twitter.com/dG47v4Rr8NExterner Link

«Es überrascht nicht, dass nach der verfrühten Veröffentlichung von #ChatGPT und dem von Microsoft, Google oder Facebook verursachten Wettlauf nach unten in puncto Sicherheit nun GPT-4 auf dem Markt ist.

Es behauptet, eine Einstiegsprüfung in Physik «lösen» zu können. Das wird es noch schwieriger machen, den Hype in Frankreich zu drosseln…»

Ist der Chatbot wirklich so gefährlich? Er sieht nicht so aus, mit seiner nüchternen Benutzeroberfläche und der Höflichkeit, die schon Siri, Cortana, OK Google und andere an den Tag gelegt haben.

Um die Bedenken besser zu verstehen, müssen wir uns ein wenig damit beschäftigen, was diese Maschine ist und vor allem, was sie nicht ist.

Ein elektronisches Gehirn? Auf keinen Fall

Wenn man ihn direkt fragt, macht ChatGPT kein Geheimnis aus seiner Natur: «Als Computerprogramm unterscheide ich mich grundlegend von einem menschlichen Gehirn.» Er erklärt, dass er grosse Datenmengen viel schneller als ein Mensch verarbeiten kann, dass sein Gedächtnis nichts vergisst, dass ihm aber emotionale Intelligenz, Selbstbewusstsein, Inspiration, kreatives Denken und die Fähigkeit, selbstständige Entscheidungen zu treffen, fehlen.

Mehr

Die KIs sind ausser (demokratischer) Kontrolle

Der Grund dafür ist, dass die Architektur der KI nichts mit der des Gehirns zu tun hat, wie ein Buch auf brillante Weise erklärt. A Thousand BrainsExterner Link ist das Ergebnis der jüngsten Forschungen der Teams von Jeff Hawkins. Der amerikanische Computeringenieur war in den 1990er-Jahren einer der Väter des Palm, eines persönlichen Assistenten im Taschenformat, der das Smartphone vorwegnahm. Nach seinem Wechsel in die Neurowissenschaften ist Hawkins heute Leiter des KI-Unternehmens Numenta.

Einer der Hauptgedanken des Buches ist, dass das Gehirn Referenzsysteme schafft, Hunderttausende von «Karten» von allem, was wir wissen, die es ständig mit den Informationen, die es von unseren Sinnen erhält, verändert. Eine KI hingegen hat weder Augen noch Ohren und ernährt sich nur von den Daten, die man ihr liefert, die starr bleiben und sich nicht weiterentwickeln.

Er weiss nicht einmal, was eine Katze ist

Hawkins illustriert seine Ausführungen mit einfachen Beispielen. So ist eine KI, die Bilder etikettiert, in der Lage, eine Katze zu erkennen. Sie weiss aber nicht, dass es sich um ein Tier handelt, dass es einen Schwanz, Pfoten und Lungen hat, dass manche Menschen Katzen lieber mögen als Hunde, dass eine Katze schnurrt oder Haare verliert. Mit anderen Worten: Die Maschine weiss viel weniger über Katzen als ein fünfjähriges Kind.

ChatGPT zu fragen, ob Tim auf dem Mond war, ist eine ziemlich heimtückische Falle. Die Maschine fällt nicht darauf herein, sondern stellt gleich zu Beginn klar, dass Hergés Album ein fiktionales Werk ist. Sie fügt jedoch hinzu, dass die Mondmission «von Syldavien und Bordurien organisiert» wurde.

Ist das so? In Hergés Welt sind Syldavien und Bordurien so etwas wie die Ukraine und Russland im Moment, nur ohne Krieg… ChatGPT gibt zu, dass diese beiden imaginären Länder «oft als Feinde und Rivalen dargestellt werden«, bleibt aber dabei: Die Rakete sei eine Zusammenarbeit zwischen Syldavien und der «Zbroïa Airfix von Bordurien» (das kann man sich nicht ausdenken, nicht einmal Google findet das!).

Was macht also Oberst Boris, der als Bordspion an Bord der Rakete ist, die er entführen soll? ChatGPT bestätigt ohne zu zögern: Boris ist ein Spion, der als blinder Passagier an Bord ist, aber die Rakete ist immer noch eine Zusammenarbeit zwischen Syldavien und dem, was jetzt das «Bordurische Raumfahrtzentrum» genannt wird.

Bei der vierten Antwort hat die Maschine endlich herausgefunden, dass Bordurien nichts mit dem Bau der Mondrakete zu tun hat. Eine Stunde später, auf dieselbe Frage, hat ChatGPT Bordurien (und Syldavien) vergessen, sagt uns aber, dass die Rakete von Professor Tournesol gebaut wurde, möglicherweise in dem Labor, in dem er arbeitet, «in der Schweiz, in den Bergen» (!).

Test durchgeführt mit der kostenpflichtigen Version von ChatGPT am 31. März 2023

Und warum ist das so? Weil das Kind schon einmal eine Katze gesehen hat, sie gestreichelt hat, sie schnurren gehört hat und all diese Informationen die «Landkarte» der Katze in seinem Gehirn erweitert haben. Während ein Konversationsbot wie ChatGPT sich nur auf Wortfolgen und die Wahrscheinlichkeit, dass Wörter nebeneinander vorkommen, stützt.

In diesem Video erklärt Lê Nguyên Hoang, Co-Autor der Bücher von El Mahdi El Mhamdi und Rachid Guerraoui (zitiert unten), was seiner Meinung nach die wahre Gefahr von ChatGPT ist (auf Französisch).

Diese Grenzen der KI, wie sie heute noch konzipiert ist, wurden bereits vor über 70 Jahren von Alan Turing vorhergesagt, dem genialen britischen Mathematiker, der die Grundlagen der Informatik schuf. In seinem Artikel «Computing Machinery and Intelligence» sah Turing bereits 1950, dass es, wenn man eine denkende Maschine bauen will, nicht ausreichen wird, sie darauf zu programmieren, aus Massen von Daten Schlüsse zu ziehen. Um ihren Namen wirklich zu verdienen, müssen Künstliche Intelligenzen auch in der Lage sein, induktiv zu argumentieren, d. h. von einem Einzelfall auszugehen und zu einer Verallgemeinerung zu gelangen. Und davon sind wir noch sehr weit entfernt.

Mehr

Regierungen und Unternehmen werden das KI-Rennen nicht stoppen

Gut formuliert und oft wahr

Rachid Guerraoui leitet das Labor für verteiltes Rechnen an der École polytechnique fédérale de Lausanne (EPFL). Zusammen mit seinem Mitarbeiter Lê Nguyên Hoang, der auch den Youtube-Kanal «Science4AllExterner Link» betreibt, veröffentlichte er 2020 «Turing à la plage L’intelligence artificielle dans un transat Externer Link(Touring am Strand – KI im Liegestuhl). Ein Buch mit dem Versprechen, dass man nach der Lektüre den «Computer nicht mehr auf die gleicheWeise betrachten» wird.

«Meistens ist das, was er sagt, wahr. Aber er macht auch regelmässig grosse Fehler. Man sollte sich also nicht blind auf ihn verlassen». Rachid Guerraoui, EPFL

Für Guerraoui besteht eines der Hauptrisiken bei ChatGPT darin, dass man sich zu sicher fühlt. «Meistens ist das, was er sagt, wahr, oder zumindest ist es so gut geschrieben, dass es wahr klingt. Aber er macht auch regelmässig grosse Fehler. Man sollte sich also nicht blind auf ihn verlassen.» Leider ist nicht jeder kritisch genug, um das, was die Maschine sagt, zu hinterfragen – vor allem, wenn sie es klar und deutlich sagt, ohne Rechtschreib- oder Grammatikfehler.

«Eine weitere Gefahr ist, dass es den Menschen das Verantwortungsbewusstsein nimmt», fährt der Professor fort. «Und sogar Unternehmen werden den Bot verwenden. Aber wer ist die Quelle und wer ist verantwortlich, wenn die dargereichten Informationen problematisch sind? Das ist überhaupt nicht klar.»

Hat Guerraoui Angst davor, dass KIs Journalist:innen, Schriftsteller:innen und sogar Lehrpersonen ersetzen könnten, wie man oft hört? Noch nicht, aber er kann sich vorstellen, dass «einige Berufe sich vielleicht verändern werden. Der Lehrer oder Journalist wird eher mit der Überprüfung und dem Abgleich von Quellen betraut sein, denn die Maschine wird einen Text ausgeben, der plausibel erscheint und in den meisten Fällen wahr ist. Aber wir werden trotzdem alles überprüfen müssen.»

Drigender Regulierungsbedarf

«Die grosse Herausforderung im Bereich der KI ist heute nicht die Leistung, sondern die Governance, die Regulierung und die Notwendigkeit der Zuverlässigkeit», sagt El Mahdi El Mhamdi, ehemaliger Doktorand an der EPFL und heute Professor für Mathematik und Datenwissenschaften an der École polytechnique in Paris.

«Meiner Meinung nach ist ChatGPT nicht einfach nur überbewertet, sondern sein verfrühter Einsatz ist unverantwortlich und gefährlich». El Mahdi El Mhamdi, École polytechnique, Paris

2019 veröffentlichte er – ebenfalls zusammen mit Lê Nguyên Hoang – «Le fabuleux chantier – rendre l’intelligence artificielle robustement bénéfique» («Die fabelhafte Baustelle – Künstliche Intelligenz robust nutzbar machen»). Ein Buch, das sich insbesondere mit den Gefahren der sogenannten Empfehlungsalgorithmen befasst, also jener Algorithmen, die es sozialen Netzwerken ermöglichen, auf Grundlage eines Profils Inhalte vorzuschlagen, die eine Person mutmasslich interessieren. El Mhamdi musste also nicht auf ChatGPT warten, um die Auswirkungen dieser Algorithmen auf das «Informationschaos in unseren Gesellschaften» anzuprangern.

«Meiner Meinung nach ist ChatGPT nicht einfach nur überbewertet, sondern sein verfrühter Einsatz ist unverantwortlich und gefährlich», warnt der Professor. «Wenn ich die uneingeschränkte Begeisterung für dieses Tool sehe, auch bei einigen Kollegen, frage ich mich, ob wir auf demselben Planeten leben». Er erinnert an die Skandale um die massenhafte Datenspeicherung durch Cambridge Analytica oder die Verbreitung von Spyware wie Pegasus, die heimlich auf Mobiltelefonen installiert werden kann.

El Mhamdi gibt zwar zu, dass ChatGPT eine gute Arbeitshilfe sein kann, erinnert aber daran, dass die Wissenschaft, die seine Entstehung ermöglicht hat, «das Ergebnis einer Kumulation dessen ist, was von Tausenden von Forscherinnen und Forschern im letzten Jahrzehnt veröffentlicht wurde, von kolossalen technischen Mitteln sowie auch der ethisch sehr problematischen Arbeit unterbezahlter und in Kenia ansässiger Helferinnen und Helfer».

ChatGPT macht keinen Unterschied zwischen der Beschreibung eines Schwalbenschwarms über einem Tulpenfeld und der Beschreibung der Vergewaltigung eines Kindes durch seinen Vater. Für den Bot sind diese Situationen lediglich Informationsquellen – wie Schmerz für den Terminator.

Die Entwickler von KI müssen der Maschine – die keine Werte, kein Gewissen und keine Moral hat – also beibringen, was zulässig ist und was nicht. Dazu muss man ihr Beispiele für die abscheulichsten Dinge liefern, die Menschen produzieren können, damit sie diese erkennen und eliminieren kann.

Im Januar 2023 enthüllte eine Untersuchung des US-Magazins Time, wie OpenAI dieses Problem an Subunternehmer ausgelagert hatte. Ab November 2021 schickte es Zehntausende toxische Textauszüge aus dem Internet an die kalifornische Firma Sama, welche die Texte vor allem in ihrer Niederlassung in Nairobi, Kenia, aufschlüsseln liess. Dort mussten etwa 30 Personen neun Stunden pro Tag damit verbringen, klinisch genau beschriebene Vergewaltigungen, Folterungen, zoophile und pädokriminelle Handlungen zu lesen und zu kennzeichnen – für knapp zwei Dollar pro Stunde.

Da niemand eine so grausame Erfahrung unversehrt übersteht, hat Sama, das mit einem «ethischen» Gütesiegel wirbt, den Schattenarbeiter:innen psychologische Unterstützung angeboten. Ehemalige Mitarbeitende, die sich bereit erklärten, mit einem anonymen Time-Reporter zu sprechen, berichteten jedoch, dass die psychologische Betreuung bei weitem nicht ausreichte. Inzwischen wurde der Vertrag zwischen OpenAI und Sama aufgelöst.

ChatGPT hat diese unrühmliche Seite seiner Entwicklung nicht aufgezeichnet. Egal wie man fragt, die Antworten beginnen alle mit dem notorischen «Tut mir leid, aber als Sprachmodell habe ich keinen Zugang…, ich bin nicht in der Lage…, ich kann keine Informationen liefern…, ich habe nicht die Fähigkeit…»

Letztendlich liegt für ihn «die tatsächliche Genialität von OpenAI nicht in der Technik hinter ChatGPT, sondern im Marketing, das an eine von technischen Spielereien begeisterte Öffentlichkeit delegiert wurde». Eine Öffentlichkeit und die Medien, könnte man hinzufügen, um zum Anfang dieses Artikels zurückzukehren. Also: Haben Sie schon einmal eine Werbung für ChatGPT gesehen?

Editiert von Sabrina Weiss, aus dem Französischen übertragen von Marc Leutenegger

In Übereinstimmung mit den JTI-Standards

Einen Überblick über die laufenden Debatten mit unseren Journalisten finden Sie hier. Machen Sie mit!

Wenn Sie eine Debatte über ein in diesem Artikel angesprochenes Thema beginnen oder sachliche Fehler melden möchten, senden Sie uns bitte eine E-Mail an german@swissinfo.ch