L’intelligenza artificiale è davvero così intelligente come pensiamo?

I computer prendono sempre più spesso decisioni importanti per noi. Dovremmo lasciarli fare? Un team di ricerca dell'Istituto svizzero Idiap mostra perché gran parte dell'intelligenza delle macchine è solo un'illusione.

Le macchine possono pensare? È con questa domanda che il matematico britannico Alan Turing apre il suo scritto più famosoCollegamento esterno. Pubblicato nel 1950, il testo ha gettato le basi per la concezione e la definizione dell’intelligenza artificiale (IA). Per rispondere alla sua domanda, Turing inventò il “gioco dell’imitazione”, usato ancora oggi per giudicare l’intelligenza di una macchina.

Il gioco, che in seguito divenne noto come Test di Turing, coinvolge tre giocatori: il giocatore A è un uomo, il giocatore B è una donna e il giocatore C, che interpreta il ruolo dell’interrogatore, può essere di entrambi i sessi.

L’interrogatore non può vedere gli altri due giocatori e pone una serie di domande per iscritto, per determinare quale giocatore è l’uomo e quale la donna. Lo scopo dell’interrogato uomo è quello di ingannare l’interrogatore, dando risposte fuorvianti, mentre la donna deve facilitare la sua corretta identificazione.

Ora, immaginate che il giocatore A sia sostituito da un computer. Turing scrisse che se l’interrogatore non è in grado di distinguere tra un computer e una persona, il computer dovrebbe essere considerato un’entità intelligente, poiché si dimostrerebbe cognitivamente simile a un essere umano.

Settant’anni dopo, i risultati del test sono stupefacenti. “Al momento, non c’è un solo sistema di intelligenza artificiale, e dico nemmeno uno, che abbia superato il primo test di Turing”, dice Hervé Bourlard, che dirige l’IdiapCollegamento esterno, l’istituto di ricerca con sede a Martigny, nel Canton Vallese, specializzato in intelligenza artificiale e cognitiva.

Altri sviluppi

La macchina e la morale

Né artificiale né intelligente

Caduto in disuso già negli anni ’70 – essendo considerato fuori moda e ridicolo – il termine intelligenza artificiale torna di moda negli anni ’90, “per motivi pubblicitari, di marketing e di business”, sostiene Bourlard, che è anche professore di ingegneria elettrica, “ma senza aver fatto alcun progresso reale, se non nella potenza dei modelli matematici”. Bourlard rimane scettico verso l’espressione e verso l’uso che se ne fa oggi.

Secondo il professore, non esiste una cosa come “l’intelligenza artificiale” perché nessun sistema riflette la minima intelligenza umana. Persino un bebè di due o tre mesi sa fare ciò che un’IA non sarebbe mai in grado di fare.

Un esempio? Prendiamo un bicchiere d’acqua che si trova su un tavolo. Un bambino piccolo sa bene che, se capovolto, il bicchiere d’acqua diventa un bicchiere vuoto. “Per questo si diverte a rovesciarlo. Nessuna macchina al mondo può capire questa differenza”, dice Bourlard. Ciò che questo esempio dimostra vale anche per il buon senso, una capacità che distingue gli umani dagli altri esseri viventi, ma che le macchine non possono e – secondo Bourlard – non saranno mai in grado di imitare.

L’intelligenza è nei dati

L’IA è comunque ben radicata in molti settori commerciali e sta contribuendo sempre più ai processi decisionali in campi come le risorse umane, le assicurazioni e i prestiti bancari, solo per citarne alcuni. Analizzando il comportamento umano su Internet, le macchine stanno imparando chi siamo e cosa ci piace. I sistemi di raccomandazione filtrano le informazioni meno rilevanti e ci consigliano film da guardare, notizie da leggere o vestiti che potrebbero piacerci sui social media.

Ma questo non rende ancora l’intelligenza artificiale intelligente, dice Bourlard, che ha assunto la direzione dell’Idiap nel 1996. Il professore preferisce parlare di apprendimento automatico. Secondo Bourlard, sono tre gli aspetti che rendono l’IA potente a modo suo: potenza di calcolo, modelli matematici e banche dati molto vaste e diffuse.

I computer sempre più potenti e la digitalizzazione delle informazioni hanno reso possibile migliorare enormemente i modelli matematici. Internet con i suoi infiniti database ha fatto il resto, spingendo le capacità dei sistemi di IA sempre più lontano.

I ricercatori e le ricercatrici dell’Idiap mostrano al pubblico come funziona l’IA e cosa può fare:

L’Idiap sta cercando di mostrare al pubblico quanto i dati siano centrali per le macchine attraverso una serie di dimostrazioni, che saranno esposte al Museo della Mano di LosannaCollegamento esterno dal 1° aprile 2022.

Il pubblico avrà l’opportunità, per esempio, di sperimentare come la tecnologia basata sull’IA che sta dietro alle fotocamere dei nostri smartphone può migliorare significativamente la qualità delle immagini a bassa risoluzione o, al contrario, peggiorarla, a seconda dei dati con cui è stata addestrata.

Non si tratta di un processo facile, ma richiede molti dati di buona qualità che devono essere annotati, o ‘etichettati’, da un essere umano (anche se non del tutto manualmente) per renderli comprensibili a una macchina. “Non siamo di fronte a qualcosa che ha una vita propria, ma a un sistema alimentato con dei dati”, dice Michael Liebling, che dirige il Computational Bioimaging Group dell’Idiap.

Ciò non significa che l’IA non presenti dei rischi. I limiti delle macchine dipendono dai limiti dei dati. Questo, secondo Liebling, dovrebbe far riflettere su dove stia il pericolo reale. “Il pericolo è davvero in una macchina fantascientifica che conquista il mondo? O è nel modo in cui distribuiamo e annotiamo i dati? Personalmente, penso che la minaccia risieda nel modo in cui i dati sono gestiti piuttosto che nelle macchine stesse”, sostiene Liebling.

Altri sviluppi

Per un’intelligenza artificiale con valori europei

Più trasparenza necessaria

I giganti tecnologici come Google e Facebook sono ben consapevoli del potere dei modelli alimentati con grandi quantità di dati e vi hanno costruito attorno il proprio business. Questo aspetto, insieme all’automazione di alcuni compiti umani, è quello che preoccupa di più la comunità scientifica. L’ex ricercatrice di Google Timnit Gebru è stata addirittura licenziata per aver criticato i modelli linguistici molto vasti e imperscrutabili alla base del motore di ricerca più utilizzato al mondo.

Il limite dei modelli di machine learning è che non mostrano – o almeno non ancora – una capacità di ragionamento pari alla nostra. Sono in grado di fornire risposte ma non di spiegare perché sono arrivati a una certa conclusione. “Bisogna anche renderli trasparenti e comprensibili per un pubblico umano”, dice André Freitas, che dirige il gruppo di ricerca Reasoning & Explainable AI all’Idiap.

La buona notizia, afferma Freitas, è che la comunità dell’IA – che in passato si concentrava principalmente sul miglioramento delle performance e sull’accuratezza dei sistemi – ora sta anche spingendo per sviluppare modelli etici, spiegabili, sicuri ed equi.

Con il suo gruppo di ricerca, Freitas sta costruendo modelli di IA in grado di spiegare le loro deduzioni. Questo permetterebbe non solo di prevedere e raccomandare quando le e i pazienti positivi alla Covid-19 dovrebbero essere ammessi nei reparti di terapia intensiva, ma anche di esporre al personale medico che utilizza il modello come sono state raggiunte tali conclusioni e quali sono i possibili limiti del sistema.

“Costruendo modelli di IA capaci di spiegarsi al mondo esterno, possiamo dare agli utenti gli strumenti per avere una visione critica sui loro limiti e punti di forza”, dice Freitas. L’obiettivo è di trasformare gli algoritmi complessi e il gergo tecnico in qualcosa di comprensibile e accessibile. Poiché le applicazioni dell’IA iniziano a permeare le nostre vite, il ricercatore raccomanda: “Se vi imbattete in un sistema di IA, sfidatelo a spiegarsi”.

Altri sviluppi

Cosa succede se Google licenzia la sua etica

Illusioni di intelligenza

L’IA è spesso descritta come il motore che sta dietro alle innovazioni odierne. È quindi naturale che susciti eccitazione e grandi aspettative. Grazie ai modelli di reti neurali, che si ispirano al cervello umano, i computer stanno ottenendo buone prestazioni in settori che prima erano impensabili.

“Questo ci ha fatto credere che l’IA diventerà intelligente come noi e risolverà tutti i nostri problemi”, dice Lonneke van der Plas, che guida il gruppo Computation, Cognition and Language all’Idiap.

Van der Plas fa l’esempio delle capacità sempre più avanzate dei sistemi linguistici, come gli assistenti virtuali o gli strumenti di traduzione automatica. “Ci lasciano senza parole e pensiamo che se un computer può cimentarsi in qualcosa di così complesso come il linguaggio ci deve essere un’intelligenza dietro”, dice.

Gli strumenti linguistici possono imitarci, perché i modelli sottostanti sono in grado di imparare degli schemi da un grande volume di testi. Ma se confrontiamo le capacità di un assistente virtuale (ad attivazione vocale) con quelle di un bambino medio in una discussione su un aeroplano di carta, per esempio, il software necessita di molti più dati per arrivare al livello del bambino – e farà persino fatica a esprimersi ricorrendo al buon senso. “È facile ingannare noi stessi, perché sembrare un essere umano non significa automaticamente che ci sia un’intelligenza umana dietro”, dice Van der Plas.

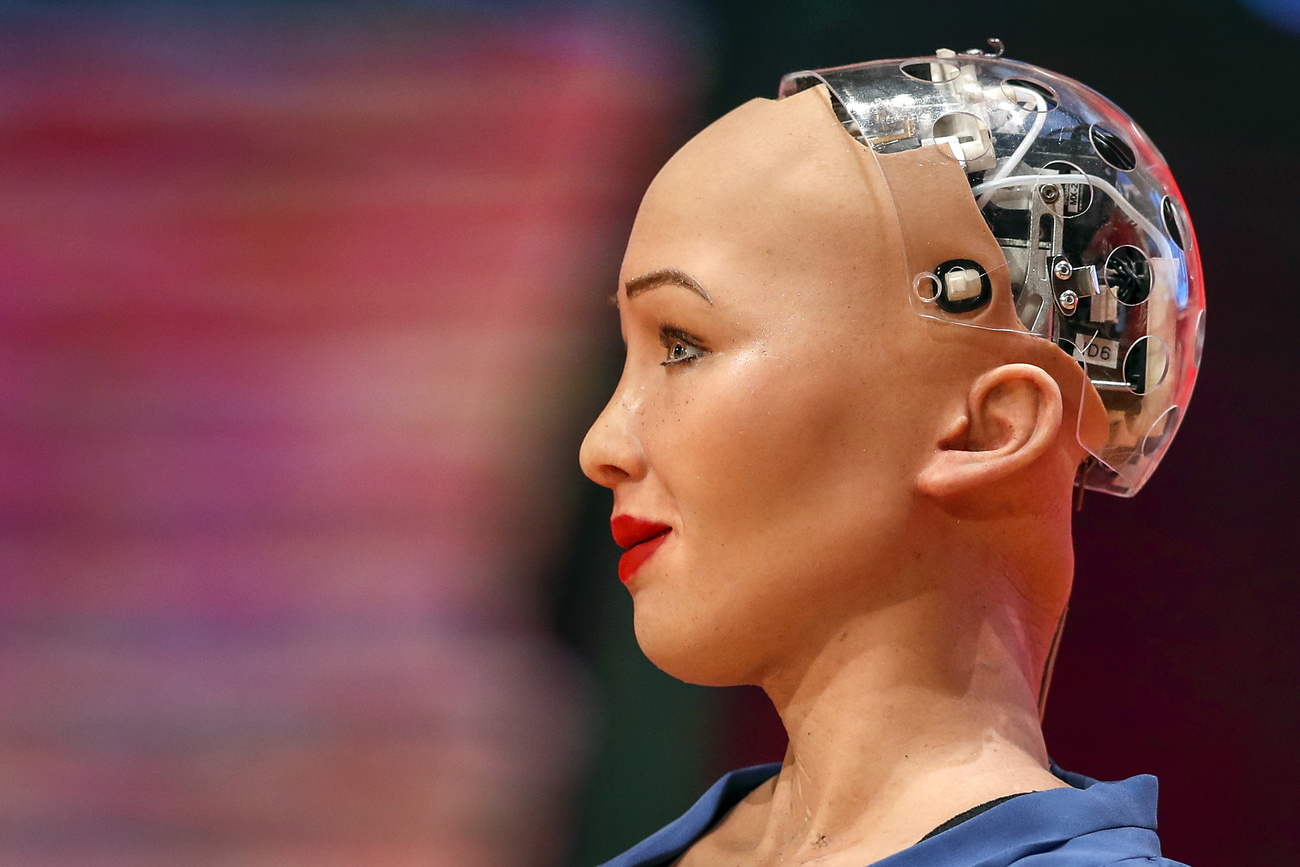

Dopo tutto, Turing lo diceva già settant’anni fa: non vale la pena di cercare di umanizzare una “macchina pensante” attraverso accorgimenti estetici. Il valore di un libro non si giudica dalla copertina.

Altri sviluppi

In conformità con gli standard di JTI

Altri sviluppi: SWI swissinfo.ch certificato dalla Journalism Trust Initiative

![[illustrazione] Una sala conferenze con persone in platea, logo NecrosIA ai lati e una donna in sedia a rotelle sullo schermo](https://www.swissinfo.ch/content/wp-content/uploads/sites/13/2021/10/b80d83598138bf549074a25c11723640-necrosia_03-data.jpg?ver=4daa9e4a)

Potete trovare una panoramica delle discussioni in corso con i nostri giornalisti qui.

Se volete iniziare una discussione su un argomento sollevato in questo articolo o volete segnalare errori fattuali, inviateci un'e-mail all'indirizzo italian@swissinfo.ch.