Come gli scienziati svizzeri tentano di smascherare i deepfake

I video falsificati tramite l'intelligenza artificiale diventano sempre più sofisticati. Esperti in Svizzera stanno rivalutando i rischi che il loro uso malevolo comporta per la società, sviluppando al contempo dei metodi innovativi per fermare chi li crea.

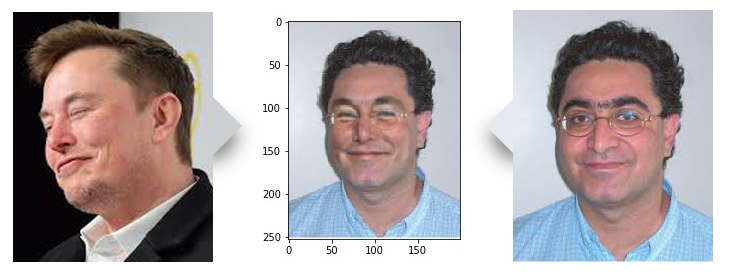

In un laboratorio informatico del vasto campus universitario del Politecnico federale di Losanna (EPFL), un piccolo team di ingegneri sta contemplando l’immagine di un uomo sorridente con gli occhiali, dalla carnagione rosea e i riccioli scuri.

“Sì, questa è buona”, dice il responsabile del gruppo di ricerca, Touradj Ebrahimi, il quale ha una vaga somiglianza con l’uomo sullo schermo. Il team ha abilmente manipolato l’immagine in primo piano di Ebrahimi, sovrapponendola a quella del fondatore di Tesla, Elon Musk, trovata su Internet. Hanno così creato un deepfake, un’immagine o un video digitale di sintesi realizzata con l’intelligenza artificiale.

Si tratta di una delle tante falsificazioni – alcune più realistiche di altre – create dal gruppo di ricercatori guidato da EbrahimiCollegamento esterno, durante lo sviluppo di un software in grado di rilevare immagine ritoccate, inclusi i deepfake. Il lavoro si svolge in collaborazione con la società di sicurezza informatica Quantum Integrity (QICollegamento esterno).

Utilizzando l’apprendimento automatico (‘machine learning’), ovvero la stessa tecnica che sta dietro alla creazione dei deepfake, il software sta imparando a distinguere il vero dal falso: un ‘creatore’ lo alimenta con immagini false, mentre un ‘rilevatore’ cerca di scovarle.

“Con molto apprendimento, le macchine possono contribuire a rilevare i falsi così come farebbe un essere umano”, spiega Ebrahimi. “Più il programma è utilizzato, più i risultati migliorano”.

Foto e filmati sono stati ritoccati fin dalla nascita delle rispettive tecnologie. Ma è solo di recente che le tecniche di intelligenza artificiale permettono ai contraffattori di alterare i volti in un video o di far dire a una persona qualcosa che in realtà non ha mai detto. Negli ultimi anni, la tecnologia deepfake si è diffusa più velocemente di quanto previsto dalla maggior parte degli esperti.

La realizzazione di video deepfake è diventata “esponenzialmente più rapida, facile ed economica” grazie alla diffusione di strumenti informatici di facile utilizzo e di servizi a pagamento online, rilevaCollegamento esterno l’International Risk Governance Center dell’EPFL.

“Proprio perché si sta evolvendo così velocemente, dobbiamo capire dove ci potrebbe portare e quali settori, gruppi e paesi potrebbe colpire”, spiega il suo vicedirettore, Aengus Collins.

Anche se gran parte del problema è costituito dall’uso malevolo dei deepfake nella pornografia, urge prepararsi anche per casi in cui la stessa tecnica viene utilizzata per manipolare l’opinione pubblica.

Settore in rapida evoluzione

Quando Ebrahimi tre anni fa ha iniziato a lavorare con Quantum Integrity sul software di rilevamento, i deepfake non erano ancora sul radar della maggior parte dei ricercatori. All’epoca, i clienti di QI erano preoccupati per le fotografie falsificate di incidenti domestici o stradali e utilizzate per delle frodi assicurative. Nel 2019, tuttavia, i deepfake hanno raggiunto un livello di sofisticazione tale che i responsabili del progetto hanno deciso di concentrarsi maggiormente sulla questione.

“Sono sorpreso. Non pensavo che [la tecnologia] si sarebbe evoluta così velocemente”, afferma Anthony Sahakian, amministratore delegato di QI.

Sahakian ha visto coi suoi occhi fino a che punto le tecniche deepfake possono raggiungere risultati realistici. Ultimo in ordine di tempo è stato un caso di sostituzione di volti su una foto di passaporto, che ha lasciato intatti tutti i timbri sul documento.

A preoccupare gli esperti non sono solo i progressi nelle tecniche di manipolazione, ma pure il diffondersi di contenuti falsi. Il numero di filmati deepfake in rete è quasi raddoppiato in nove mesi, raggiungendo quota 14’678 nel settembre 2019, secondo una stimaCollegamento esterno di Deeptrace, una società olandese di sicurezza informatica.

“Se l’autore si sforza di perfezionare il risultato, il falso può essere molto difficile da rilevare”

Sébastien Marcel, esperto di sicurezza biometrica

Aree a rischio

Tra le principali vittime dei deepfake maligni ci sono donne il cui viso viene trasposto su immagini o filmati pornografici. Secondo Deeptrace, il 96% dei video deepfake presenti in rete rientrano in questa categoria. Alcuni sono pubblicati direttamente su siti pornografici, altri circolano sottoforma di ‘revenge porn’, la diffusione illecita di immagini sessualmente esplicite per infangare la reputazione della vittima.

“Le molestie e il bullismo online sono temi ricorrenti”, rileva Aengus Collins dell’International Risk Governance Center.

Al contrario, ci sono stati pochi casi noti di deepfake distribuiti allo scopo di commettere una frode. La maggior parte di questi prevedevano un’imitazione della voce per ingannare le vittime e indurle a inviare denaro all’autore del falso.

Tuttavia, le aziende si stanno informando. Società quali Zurich Insurance, Swiss Re e BNP Paribas hanno inviato rappresentanti a un recente workshop sui rischi dei deepfake presso l’IRGC. Anthony Sahakian di QI afferma che il potenziale utilizzo di video falsificati in caso di sinistri, ad esempio, è una preoccupazione per gli assicuratori con cui collabora.

“La tecnologia esistente può rendere obsoleto il KYC [Know Your Customer]”, sostiene, riferendosi al processo di riconoscimento delle aziende utilizzato per verificare l’identità dei clienti e le loro intenzioni.

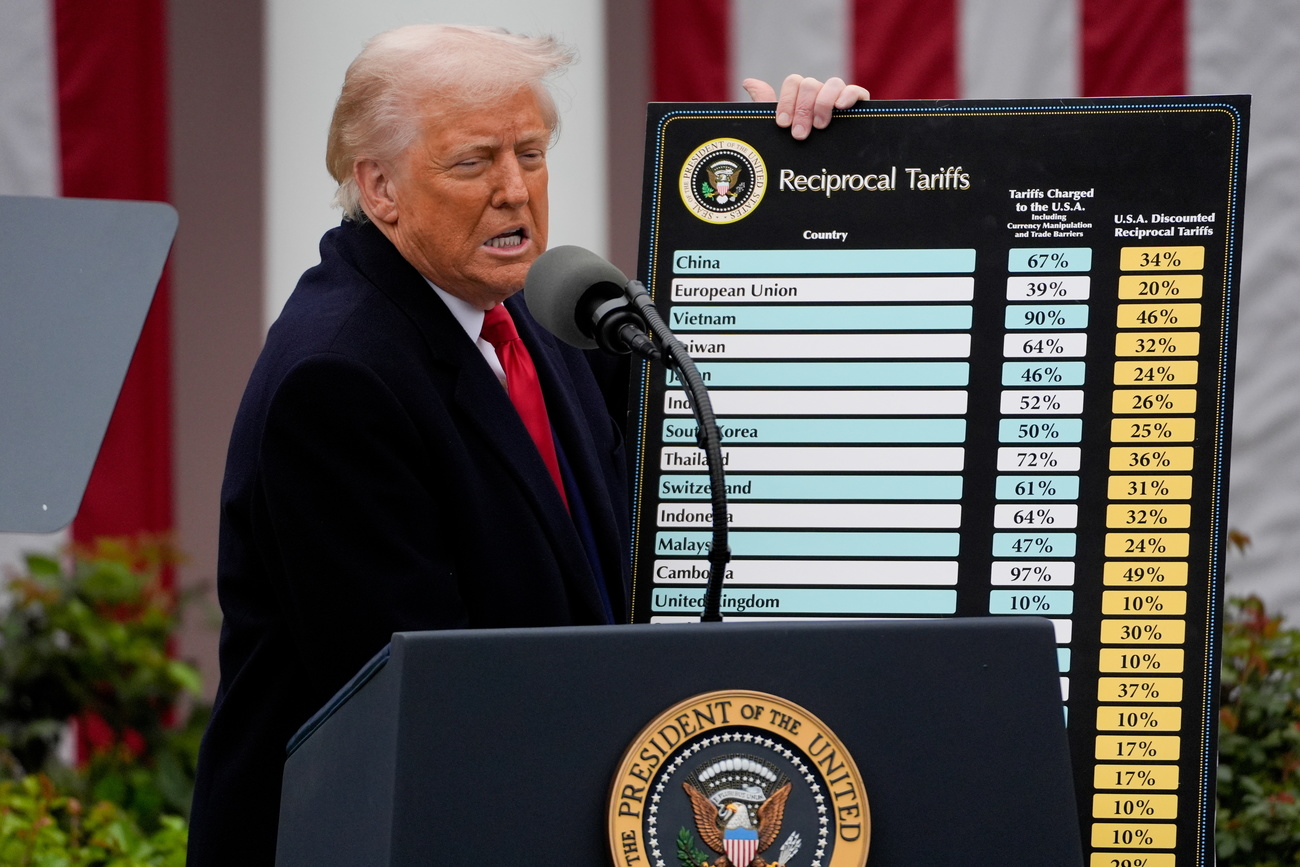

L’aumento dei deepfakes ha anche portato a speculazioni sulla possibilità di interferire con i processi politici. Questi timori sono stati confermati con la pubblicazione di un video manipolato in cui la speaker della Camera dei rappresentanti americana, Nancy Pelosi, biascicava il suo discorso. La manipolazione era di bassa qualità, un cosiddetto ‘shallowfake’, ma come dice Ebrahimi, “è un segnale di ciò che si può fare e dell’intento che sta dietro a questo tipo di media manipolati”.

Intelligenza artificiale per creare e individuare

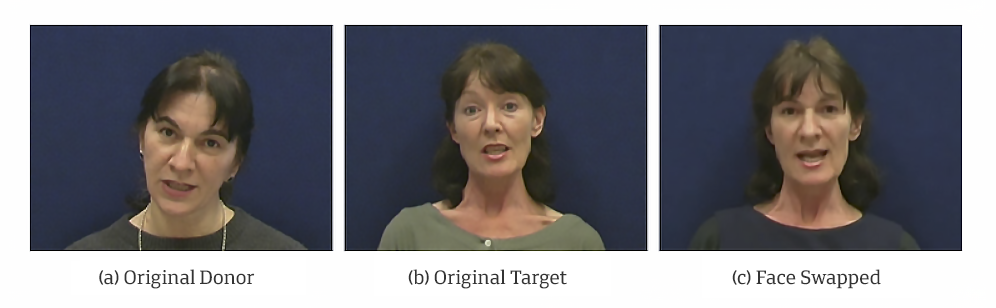

La tecnologia può provocare il panico in alcuni ambienti, ma non tutti sono dell’idea che i video deepfake siano abbastanza realistici da ingannare la maggior parte degli utenti. La qualità dei deepfake, sottolineano gli esperti, dipende ancora in gran parte dalle capacità di chi li crea. Lo scambio di volti su un video porta inevitabilmente ad alcune imperfezioni nell’immagine, spiega l’esperto di sicurezza biometrica Sébastien Marcel.

“La qualità è molto variabile, a seconda dell’intervento manuale fatto per modificare l’immagine”, dice. Se l’autore si sforza di perfezionare il risultato, il falso può essere molto difficile da rilevare, sottolinea.

Marcel e i suoi colleghi dell’istituto di ricerca IdiapCollegamento esterno di Martigny, in Vallese, stanno lavorando a un loro software di rilevamento, nel quadro di un progetto sulla manipolazione di volti e voci nei video. “Questo problema non sarà risolto a breve”, osserva. “È un campo di ricerca in crescita e quindi prevediamo di investire maggiori risorse in questo settore”.

L’istituto senza scopro di lucro affiliato all’EPFL sta partecipando a una sfida lanciata da Facebook per produrre un software di rilevamento dei deepfake. Il gigante dei social media è pronto a distribuire più di 10 milioni di dollari a ricercatori in tutto il mondo (vedi riquadro in fondo all’articolo).

“È improbabile che [uno strumento di rilevamento] rappresenti la soluzione a tutto”, dice Collins. “Qualunque sia l’insieme delle tecniche di rilevamento, qualcuno troverà il modo di aggirarle”.

Il gioco del gatto col topo

Touradj Ebrahimi e Sébastien Marcel puntualizzano che il loro obiettivo non è quello di trovare uno strumento a prova di errore. Parte del loro lavoro è di anticipare la direzione seguita dai manipolatori e di adattare i loro metodi di conseguenza.

In futuro, prevede Marcel dell’Idiap, gli autori di deepfake saranno in grado di cambiare non solo un aspetto di un filmato, come il volto, ma l’intera immagine. “La qualità dei deepfake migliorerà, quindi dobbiamo migliorare anche gli strumenti di rilevazione”, al punto che il rapporto costi-benefici della realizzazione di deepfake malevoli non sarà più a favore di chi li crea.

Ebrahimi dell’EPFL crede che un evento importante, come le elezioni presidenziali negli Stati Uniti, potrebbe incoraggiare i manipolatori ad accelerare il loro lavoro. “Potrebbe essere una questione di mesi o anni” prima che l’occhio allenato non sia più in grado di individuare un falso”, dice. E a quel punto, solo le macchine avranno la capacità di farlo.

Deepfake, la controffensiva delle reti sociali

Twitter ha introdotto nel marzo 2020 una nuova regolamentazione per combattere la condivisione di contenuti mediatici di sintesi o manipolati che possono arrecare danni. In particolare, questi tweet vengono etichettati con uno speciale label e gli utenti avvertiti. YouTube, di proprietà di Google, ha promesso che non tollererà i video falsificati relativi alle elezioni 2020 negli Stati Uniti e al censimento che mirano a indurre in errore il pubblico. Facebook ha lanciato una sfida a ricercatori di tutto il mondo, e investito 10 milioni di dollari, per la messa a punto di un sistema di rilevamento di deepfake. Sia Facebook che Google hanno diffuso dei dataset di immagini deepfake per aiutare i ricercatori a sviluppare delle tecniche di rilevamento.

Deepfake per ridere

I deepfake più diffusi hanno un carattere parodico e concernono individui molto in vista quali celebrità e politici, rileva l’International Risk Governance Center (IRGCCollegamento esterno), sottolineando che “non tutti i deepfake sono creati con intento malevolo”. Anche Hollywood ha fatto ricorso alla tecnologia deepfake, ad esempio per riportare sul grande schermo attori scomparsi da tempo. Touradj Ebrahimi dell’EPFL afferma che, se tutto andrà secondo i piani, un sottoprodotto del progetto EPFL/QI per lo sviluppo di software di rilevamento dei deepfake potrebbe essere l’eventuale utilizzo della stessa tecnologia per creare effetti speciali cinematografici.

Altri potenziali usi positivi delle tecniche di falsificazione includono la sintesi vocale per scopi medici e la medicina legale digitale nelle indagini penali, secondo l’IRGC.

Traduzione dall’inglese: Luigi Jorio

In conformità con gli standard di JTI

Altri sviluppi: SWI swissinfo.ch certificato dalla Journalism Trust Initiative

Potete trovare una panoramica delle discussioni in corso con i nostri giornalisti qui.

Se volete iniziare una discussione su un argomento sollevato in questo articolo o volete segnalare errori fattuali, inviateci un'e-mail all'indirizzo italian@swissinfo.ch.