人工知能は本当に「賢い」のか?

コンピューターが私たちの代わりに重要な決定をする機会が増えてきているが、そうさせていいのだろうか?スイスのイディアップリサーチ研究所の研究チームは、機械知能の多くは実際のところ、ただの錯覚に過ぎないという。

機械は思考できるか?これは、英国の数学者アラン・チューリング氏の最も有名な論文外部リンクの冒頭に書かれた問いだ。1950年に発表されたこの論文は、人工知能(AI)の概念と定義の基礎となった。この問いに答えるためにチューリング氏が考案した「イミテーションゲーム(模倣ゲーム)」は、現在でも機械の知能判定に利用されている。

後にチューリングテストとして知られるようになったこのゲームは、2人のプレーヤー(Aが男性、Bが女性)と1人の質問者C(性別は問わない)の合計3人で行う。プレーヤーA、 Bは質問者からは見えない。筆談で質問と回答を繰り返すことで、どちらが男性でどちらが女性かを判定する。プレーヤーAは質問者が間違えるように回答し、Bは質問者が正しく判定できるよう協力的に答える。

ここでプレーヤーAをコンピューターに置き換えたとする。もし質問者がコンピューターと人を判別できないなら、そのコンピューターは人間に近い認知能力を持っていると証明されるため、知的な存在だと認めるべきだ。チューリング氏はそう記述している。

そして70年後の現在、テストの結果は驚くべきものだった。イディアップ外部リンクのエルベ・ブーラー所長( AI・認知科学専門)によると、「今のところAIシステムと呼べるものは1つもない。つまり、チューリングテストに合格したAIは1つもない」。

おすすめの記事

考慮すべき人工知能(AI)の倫理問題

人工でも知能でもない

人工知能(AI)という言葉は、時代遅れで馬鹿げているという理由から、早くも70年代には使われなくなっていた。だが90年代に入ると流行は復活した。電気工学の教授でもあるブーラー氏はその理由を「宣伝広告やマーケティング、ビジネスのため」だと言う。「しかし実際には、数理モデルの能力以外は何も進歩していない」

同氏はAIという言葉そのものと今の使われ方について、依然として懐疑的だ。人間の知能をわずかでも反映するシステムは存在しないのだから「人工知能」などというものは存在しないと同氏は主張する。生後2、3カ月の赤ん坊でも、 AIが決してできないことができる。

テーブルに置かれた水の入ったコップを手に取るという動作を例に取ろう。もしコップを逆さにすれば空になることを赤ん坊はよくわかっている。「だから赤ん坊はそれをひっくり返して楽しむ。この違いを理解できる機械は世界中どこにも存在しない」と同氏は説明する。

この例が示すことは、常識という人間特有の能力についても当てはまる。つまり、今でも、そして同氏によれば今後も、機械は決して常識を模倣することはできないという。

知能はデータの中に

しかしAIは多様な業種に浸透し、意思決定に関与する場面が増えている。人事や保険、銀行融資などはそのごく一部だ。

機械はインターネット上の人間の行動を分析し、私たちが何者で、何が好みかを学習する。レコメンドエンジンはその中から関連の低い情報を取り除き、見るべき映画や読むべきニュース、気に入るかもしれない衣服などをソーシャルメディア上で薦める。

しかし、それができるからAIは知的な存在と見なせる、とはならないと、96年にイディアップの所長に就任したブーラー氏は言う。AIよりもむしろ、機械学習について語るべきだと主張する。同氏はAIの能力を向上させるには3つの要素があると言う。それは、コンピューター性能、数理モデル、そしてどこからでもアクセスできる膨大なデータベースだ。

コンピューターの性能が向上し、情報がデジタル化されたことで、数理モデルのかなりの改良が可能となった。加えて膨大なデータベースを持つインターネットがAIの性能をどんどん押し上げた。

▼AIがどのように動き、何ができるかを紹介するイディアップの動画

同研究所はデータがAIシステムにとっていかに重要かを、数々のデモンストレーションを通じて一般の人々にも伝えようとしている。これらのデモンストレーションは、4月1日からはローザンヌの手の美術館外部リンクで展示される予定だ。

例えば、スマートフォンのカメラがAI技術を使って写真の画質を修正する様子を実演する。訪れた人々は、ぼんやりした写真が格段にクリアになったり、同じ写真でもAIが違うデータを学習すると逆に画質が落ちたりする様子を直接見学できる。

画質の修正プロセスは簡単ではない。機械がデータを学習できるようにするには、多くの質の良いデータ1つ1つに関連する情報をタグ付けするアノテーションと呼ばれる「ラベル化」の作業が必要だ。これは(完全な手作業ではないとしても)人間が行う。

同研究所の計算バイオイメージンググループを率いるミカエル・リーブリンク氏は「私たちが扱っているのはそれ自体が生命を持つものではなく、データを注入されて動くシステムだ」と言う。

これはAIが完全に安全だという意味ではない。機械の限界はデータの限界に依存する。リーブリンク氏によれば、これこそが、本当の危険がどこにあるのかを考える際に注視すべき点だ。

同氏は「本当に危険なものは、世界を征服するサイエンスフィクションの機械か?あるいはデータの配布やアノテーションの方法か?自分としては、機械そのものよりもデータをどう扱うかの方に脅威が潜んでいると思う」と話す。

おすすめの記事

「AIは人の代わりにはならない」連邦工科大に新研究拠点

透明性を高めることが必要

米IT大手グーグルやフェイスブックなどの巨大ハイテク企業は、大量のデータを使ったモデルの威力を十分に理解し、それを中心にビジネスを構築してきた。科学コミュニティーが最も懸念するのは、人間の仕事の一部が自動化されることと並んで、まさにこの点だ。

元グーグル研究者のティムニット・ゲブル氏は、世界で最も利用されている同社の検索エンジンの基礎となっている、巨大で不可解な言語モデルを批判したことを理由に解雇された。

機械学習モデルの限界は、私たちと同等の思考能力を―少なくとも現時点では―持たないことだ。機械は答えを導き出すことはできるが、なぜその結論に至ったのかは説明できない。

推論し説明できるAIを研究するグループをイディアップで率いるアンドレ・フレイタス氏は「機械の思考過程を透明化し、周囲の人たちにわかりやすく説明できるようにしなければならない」と言う。

同氏の研究グループでは、自身の推論内容を説明できるAIモデルの構築を進めている。

目的は複雑なアルゴリズムや専門用語をかみ砕いてわかりやすくすることだ。私たちの暮らしにAIの応用技術が浸透し始めるに伴い、同氏はこう助言する。「AIシステムに出会ったら、そのAIが自らを説明できるかどうか試してみると良い」

知性はそこに存在しない

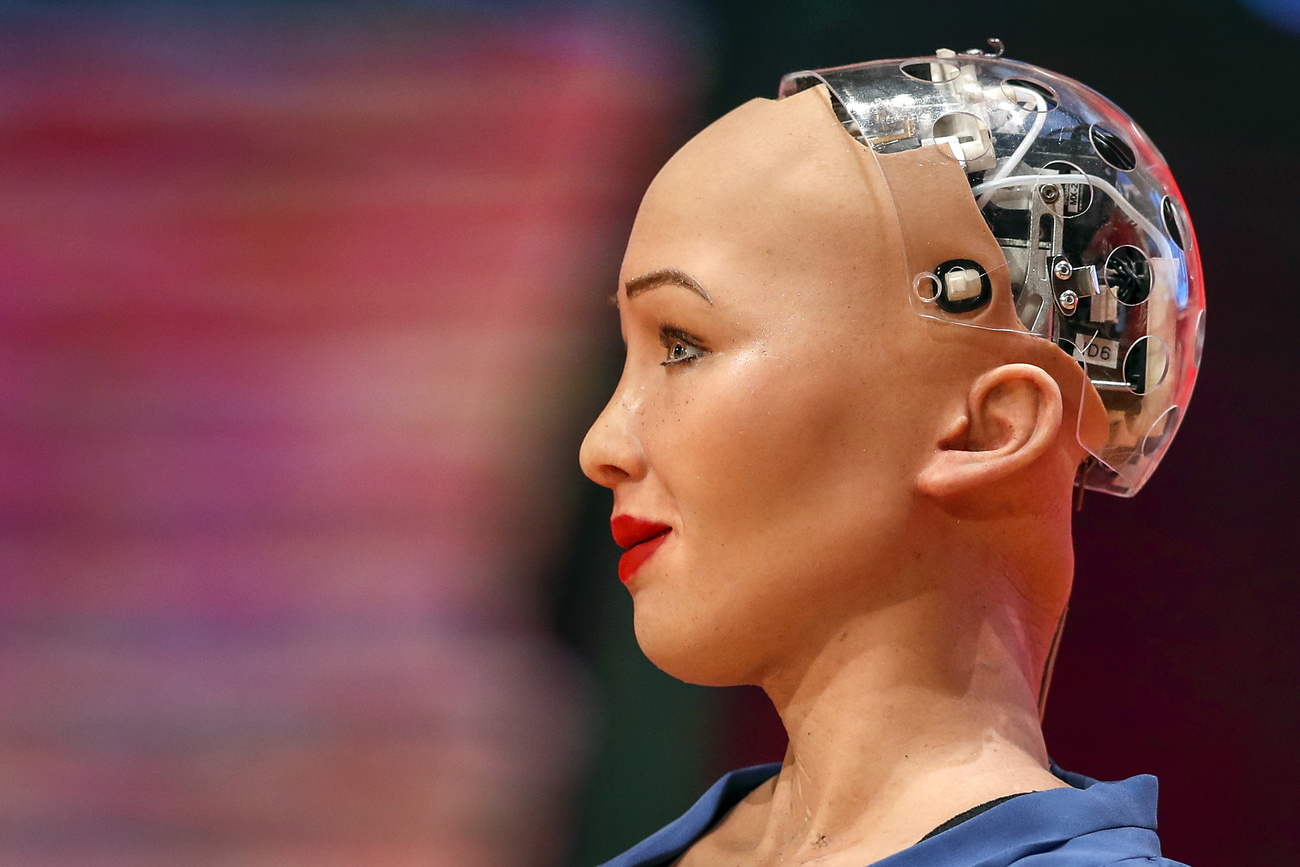

AIは現代のテクノロジーを影で操る技術だとよく言われる。だからAIと聞くと自然と気分が高揚し、高い期待を抱く。人間の脳を模倣したニューラルネットワークモデルを使ったコンピューターは、これまで思いもしなかった数々の領域で活躍している。

「このことが、AIは私たちと同様に知的な存在で、あらゆる問題を解決するだろうと信じさせた」とイディアップの計算・認知・言語グループを率いるロネケ・ファン・デア・プラス氏は言う。

同氏はバーチャルアシスタントや自動翻訳ツールなどの言語ツールの機能が格段な進歩を続けていることを例に挙げる。「(その性能の高さに)私たちは驚きで言葉を失う。そしてコンピューターが言語のような複雑なものを扱えるなら、その背後には知性があるに違いないと考えてしまう」

言語ツールを支えるモデルは膨大なテキストからパターンを学習できるので、私たちの真似ができる。しかし、(音声起動の)バーチャルアシスタントと平均的な子供の能力を比べると、例えば紙飛行機について話す時、機械には子供のレベルよりももっと多くのデータが必要だ。その上、常識などの普通の知識の習得に苦戦するだろう。

「私たちは簡単にだまされる。人間が話しているように聞こえることがそのまま、人間の知性の存在を意味するわけではない(が機械はそれらしく真似できる)からだ」と同氏は言う。

結局、チューリング氏が70年前に言ったように、外見をうまく装うことで「思考する機械」を人間化しようとすることに価値はない。本の表紙だけから中身を判断できないのと同じだ。

おすすめの記事

(英語からの翻訳・佐藤寛子)

JTI基準に準拠

swissinfo.chの記者との意見交換は、こちらからアクセスしてください。

他のトピックを議論したい、あるいは記事の誤記に関しては、japanese@swissinfo.ch までご連絡ください。