Como pesquisadores suíços tentam reconhecer manipulações digitais

Vídeos manipulados utilizando a inteligência artificial são encontrados cada vez mais na internet. Porém a tecnologia traz riscos para a sociedade. Engenheiros suíços desenvolvem tecnologias para detectar e combater as manipulações na rede.

Em um laboratório de informática em um vasto campus da Escola Politécnica Federal de Lausanne (EPFL), alguns informáticos analisam a imagem de um homem sorridente, de óculos, com a pele rosada e cabelos castanhos.

“Sim, é muito boa”, concorda o coordenador da equipe, Touradj Ebrahimi, cuja fisionomia lembra vagamente a do homem na imagem. Seus colegas conseguiram criar no computador um rosto que mistura o seu com o de Elon Musk, o fundador da fabricante de carros elétricos Tesla. Trata-se de um “deepfake”, uma expressão em inglês para denominar esse tipo de imagem manipulada através de inteligência artificial.

Esse e outras imagens falas – algumas, porém, bastante realistas – foram criadas pela equipe de EbrahimiLink externo junto com a empresa de cibersegurança Quantum IntegrityLink externo (QI) no desenvolvimento de um software especial, capaz de detectar imagens manipuladas, incluindo as “deepfakes”.

Ao utilizar a tecnologia de aprendizagem de máquina, o mesmo processo por trás da criação de deepfakes, o software aprende a diferenciar o verdadeiro do falso: um “criador” gera imagens falsas, que um “detector” tenta então encontrar.

“Através do treinamento sistemático, as máquinas são capazes de detectar manipulações da mesma maneira que um ser humano”, explica Ebrahimi. “Quanto mais esse sistema é utilizado, melhor se torna.”

Fotos e vídeos “fakes” existem desde o surgimento das tecnologias multimídias, ou seja, a combinação de mídia estática (texto, fotografia, gráfico) e dinâmica (vídeo, áudio, animação). Mas só as tecnologias atuais de inteligência artificial permitiram recentemente que manipuladores alterassem rostos em um vídeo. Ou conseguissem simular que uma pessoa tenha dito algo que não ocorreu na realidade. Nos últimos anos, a tecnologia do “deepfake” se tornou mais popular do que a maioria dos especialistas imaginava.

A produção de vídeos manipulados se tornou “exponencialmente mais rápida, fácil e barata”, graças a softwares simples e empresas que oferecem o trabalho pela internet, como explica o grupo de pesquisa intitulado Centro Internacional de Governança de RiscosLink externo (IRGC) da EPFL.

“Precisamente, devido à rapidez com que o deepfake se espalha, é que precisamos avaliar as consequências e os setores, grupos e países afetados”, afirma o vice-diretor Aengus Collins.

Embora a maioria das manipulações sejam utilizadas pelos produtores de pornografia, é necessário se preparar quando as mesmas técnicas forem utilizadas para manipular a opinião pública em eleições, por exemplo.

Mudanças rápidas

Quando Ebrahimi começou a trabalhar com a Quantum Integrity, há três anos, no desenvolvimento de softwares de detecção, a questão dos deepfakes não interessava os pesquisadores. Na época, os clientes da empresa de cibersegurança estavam mais preocupados com fotos de acidentes manipuladas, que eram posteriormente utilizadas em reivindicações fraudulentas de seguros de automóveis e residências.

Em 2019, no entanto, os deepfakes haviam chegado a um nível de sofisticação que os engenheiros decidiram se dedicar mais ao tema. “Não podia imaginar que ela (a tecnologia) se desenvolvesse tão rápido”, diz Anthony Sahakian, diretor da QI. Sahakian viu em primeira mão até que ponto as técnicas de deepfake chegam à resultados extremamente realistas. Dentre outros, troca de rostos em passaportes sem deixar traços de manipulação nos sistemas de segurança dos documentos.

Não são apenas as melhorias nas técnicas de manipulação preocupam os especialistas. O número de vídeos “deepfake” na internet quase dobrou em um período de nove meses, chegando a 14.678 em setembro de 2019, segundo as estimativas de DeeptraceLink externo, uma empresa de segurança cibernética na Holanda.

Áreas de risco

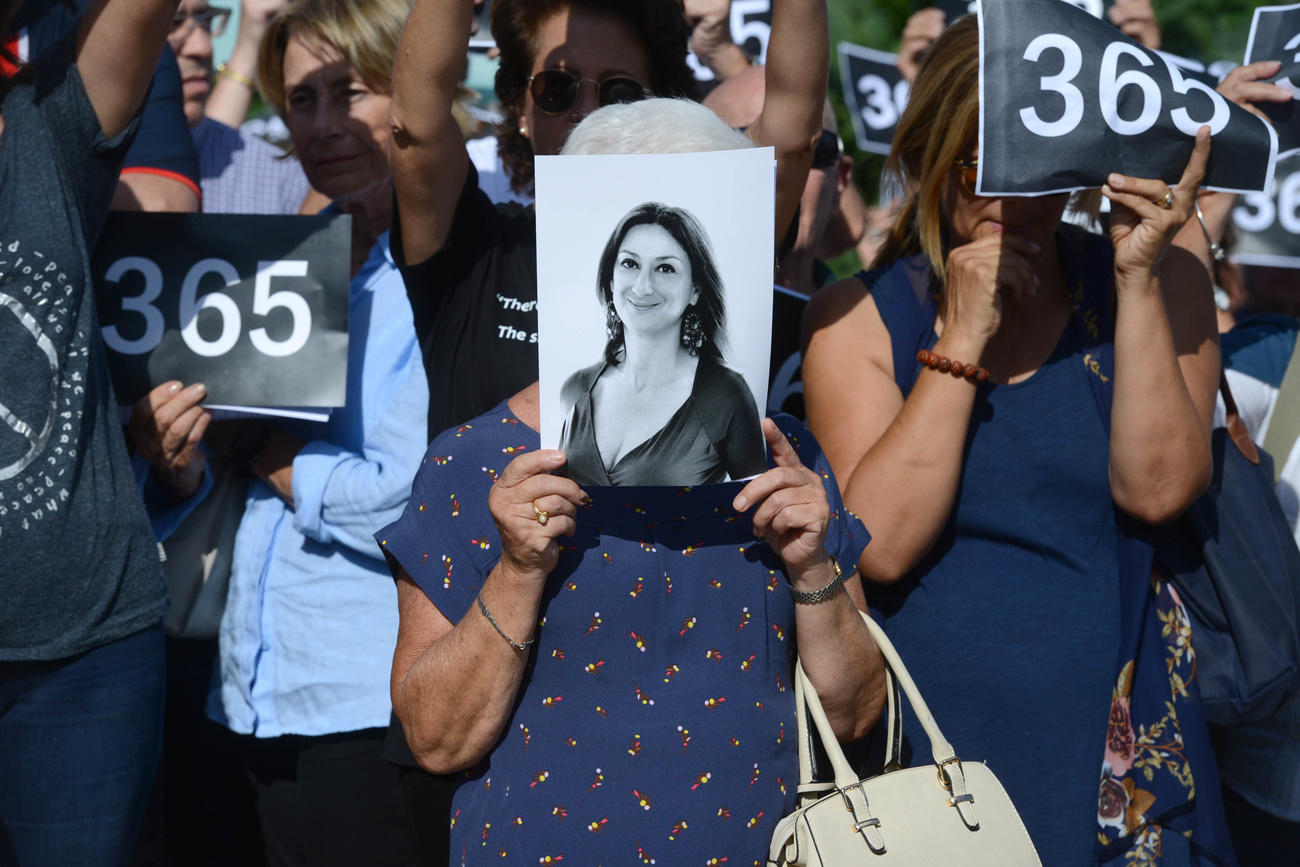

A maioria das vítimas dos produtores de deepfakes foram mulheres, cujos rostos foram transplantados em imagens pornográficas. Esse tipo de uso foi responsável por 96% dos vídeos encontrados na rede em 2019, segundo a Deeptrace. Algumas circulam em sites pornográficos conhecidos. Outras foram produzidas como forma de vingança para manchar a reputação das vítimas. “Assédio online e bullying são temas recorrentes”, explica Collins.

Por outro lado, há casos conhecidos de deepfakes produzidos com intuito de fraude. A maioria utilizava a impostação voz, levando as vítimas a enviar dinheiro a estelionatários.

Essa forma crime está na mira das seguradoras. Zurich Insurance, Swiss Re e BNP Paribas enviaram representantes para um workshop recente na EPFL para discutir sobre os riscos provocados pelo deepfake. Sahakian, da QI, diz que o uso de vídeos manipulados de acidentes é uma das maiores preocupações das seguradoras com as quais trabalha.

“Essa tecnologia serve também para combater a política KYC das empresas”, afirma, referindo-se ao processo de verificação da identidade dos clientes e suas intenções a fim de eliminar possíveis fraudes.

O crescimento de deepfakes também levou a especulações sobre uso potencial da tecnologia na política. Esse temor foi confirmado com a descoberta de um vídeo manipulado de Nancy Pelosi, presidente da Câmara de Deputados dos Estados Unidos. Apesar da baixa qualidade da manipulação (shallowfake), seu objetivo era dar a ideia de que a política americana estava alcoolizada. Porém para Ebrahimi trata-se de um exemplo concreto. “É um sinal do que pode ser feito e das intenções dos seus autores”.

Nova realidade digital

Para Aengus Collin o uso de tecnologia digital na política precisa ser colocado em contexto. “É possível que os deepfakes afetem o processo eleitoral, mas prefiro não enfatizar demais os riscos, senão você deixar de ver o quadro geral”, adverte o vice-coordenador do grupo de pesquisa na EPFL.

Em sua opinião, o que deepfake sinaliza é “a lacuna potencial que surge entre a rapidez com que o ecossistema de informação digital evolui e a capacidade da sociedade de se adaptar”.

Como exemplo, Collins retornar à questão do bullying digital. “Nossos sistemas jurídicos são capazes hoje de punir esses ataques à indivíduos? Como eliminar conteúdo digital danoso se já está em linha? Como encontrar os autores? Como puni-los se estes vivem em outra jurisdição?”, questiona-se.

Deepfake também pode ser utilizado em campanhas de desinformação, corroendo ainda mais o nexo entre verdade e confiança do público.

Inteligência artificial

A tecnologia é vista por muitos como perigosa, mas nem todos concordam que esses vídeos manipulados sejam realistas o suficiente para enganar a maioria dos usuários. Especialistas afirmam que a qualidade dos deepfakes dependem do nível técnico de quem o produziu. Trocar rostos em um vídeo leva inevitavelmente a algumas imperfeições na imagem, explica o especialista em segurança biométrica Sébastien Marcel. “A qualidade é muito variável e depende da intervenção manual para aumentar a imagem”, diz. Se o autor se esforçar bastante para melhorar o resultado, a detecção ser bastante dificultada, acrescenta Marcel.

Marcel e seus colegas do Instituto de Pesquisa IdiapLink externo, uma fundação de pesquisa a fins não lucrativos afiliada à EPFL, desenvolvem seu próprio software de detecção de manipulação de rostos e vozes em vídeos. “O problema não será resolvido ainda hoje”, afirma. “É um tema de pesquisa relevante, onde queremos investir mais.”

Como forma de incentivo, o instituto aceitou um desafio lançado pelo Facebook: produzir um software de detecção de deepfake. O gigante das redes sociais promete mais de 10 milhões de dólares a pesquisadores de todo o mundo (ver box).

Mas outros especialistas consideram difícil o desafio. “É improvável encontrar o sistema perfeito”, diz Collins. “Seja qual for a técnica empregada para detectar manipulações, os adversários sempre encontrarão uma forma de contorná-la.”

Jogo de gato e rato

Ebrahimi e Marcel afirma que o objetivo não é criar uma ferramenta à prova de falhas. Parte do trabalho do detector é antecipar em que direção os manipuladores podem ir e avaliar seus métodos.

O pesquisador do Idiap prevê um futuro no qual manipuladores serão capazes de mudar não apenas um aspecto de um vídeo, como o rosto das pessoas, mas a imagem completa. “A qualidade dos deepfakes vai melhorar. Por isso temos de melhorar as formas de detecção”, ressalta. O objetivo é fazer com que a relação custo-benefício de manipular imagens não seja mais interessante para os criminosos.

Ebrahimi, da EPFL, acredita que as eleições presidenciais nos Estados Unido possam servir de laboratório. “É uma questão de meses ou anos até que o olho treinado não seja mais capaz de detectar uma manipulação. Quando chegarmos nesse nível, só as máquinas serão capazes de fazer esse trabalho.”

Mídia social vs. deepfakes

Twitter introduziu novas regras em março de 2020 para combater o compartilhamento de informações manipuladas através de alertas aos usuários ou marcação dos “tweets” suspeitos.

YouTube, a plataforma de vídeos da Google, prometeu deletar conteúdos suspeitos relacionados à campanha presidencial nos EUA em 2020.

Facebook lançou um desafio, no valor de mais de 10 milhões de dólares, para apoiar engenheiros de software que desenvolvam sistemas de detecção de manipulações em linha. Tanto Facebook como a Google disponibilizam seus arquivos de deepfakes para ajudar os pesquisadores.

Deepfakes no cinema

“As manipulações mais conhecidas são utilizadas no humor, ironizando por exemplo personalidades ou políticos conhecidos”, explicam os pesquisadores da EPFLLink externo. “Nem todos os deepfakes são criados com intenção de prejudicar alguém”. Em Hollywood, as produtoras de cinema utilizam a tecnologia para permitir que atores já falecidos retornem às telas.

Ebrahimi, da EPFL, imagina o possível uso da tecnologia desenvolvida por sua equipe para a criação de efeitos especiais no cinema. Outros usos potenciais seria a síntese de voz para fins médicos e a perícia digital em investigações criminais

Adaptação: Alexander Thoele

Certificação JTI para a SWI swissinfo.ch

Mostrar mais: Certificação JTI para a SWI swissinfo.ch

Veja aqui uma visão geral dos debates em curso com os nossos jornalistas. Junte-se a nós!

Se quiser iniciar uma conversa sobre um tema abordado neste artigo ou se quiser comunicar erros factuais, envie-nos um e-mail para portuguese@swissinfo.ch.