Os robôs devem combater nossas guerras?

Imagine um mundo onde os robôs são enviados para o campo de batalha. Drones zumbindo por cima deles, retirando-os cirurgicamente quando estivesse claro que nenhum ser humano seria ferido. Parece ficção científica – mas também parece muito bom. Os países poderiam lutar, claro, mas sem matar pessoas reais.

Mas há também um cenário mais sombrio. Imagine armas de alta tecnologia que podem ser programadas com anos de antecedência para buscar pessoas ou grupos de pessoas específicos. Reconhecimento facial, gênero, etnia, tudo isso poderia ser utilizado como critério para criar armas destinadas a eliminar adversários políticos, comunidades inúteis e ativistas irritantes.

Já existem armas semiautônomas, e elas estão sendo usadas. Pense nos drones de ataque que os Estados Unidos têm usado no Paquistão e no Afeganistão. Os alvos são identificados, os drones são programados, e lá se vão. Os alvos, é claro, são humanos – Washington afirma ter evitado um ataque terrorista iminente em Cabul ao eliminar um dos homens que o planejavam.

Mas essas armas – ou, mais especificamente, aqueles que as programam – não são infalíveis. Civis já foram mortos por drones de ataque, que atingiram festas de casamento. Então, embora as armas semiautônomas possam proteger a vida dos soldados que, 20 anos atrás, teriam de realizar tais ataques, elas ainda matam pessoas, e nem sempre as pessoas que deveriam matar.

Precisamos de um tratado?

No último episódio de nosso podcast Inside Geneva, analisamos as complexas negociações que estão em andamento aqui nas Nações Unidas. Elas têm como objetivo decidir se a próxima geração desse tipo de arma, os modelos totalmente autônomos, deve ser regulada por um tratado, ou talvez até mesmo banida. O Comitê Internacional da Cruz Vermelha (CICV), o guardião das Convenções de Genebra, é um dos grupos que insistem que sejam ao menos criadas algumas regras em torno do uso dessas novas armas.

Mostrar mais

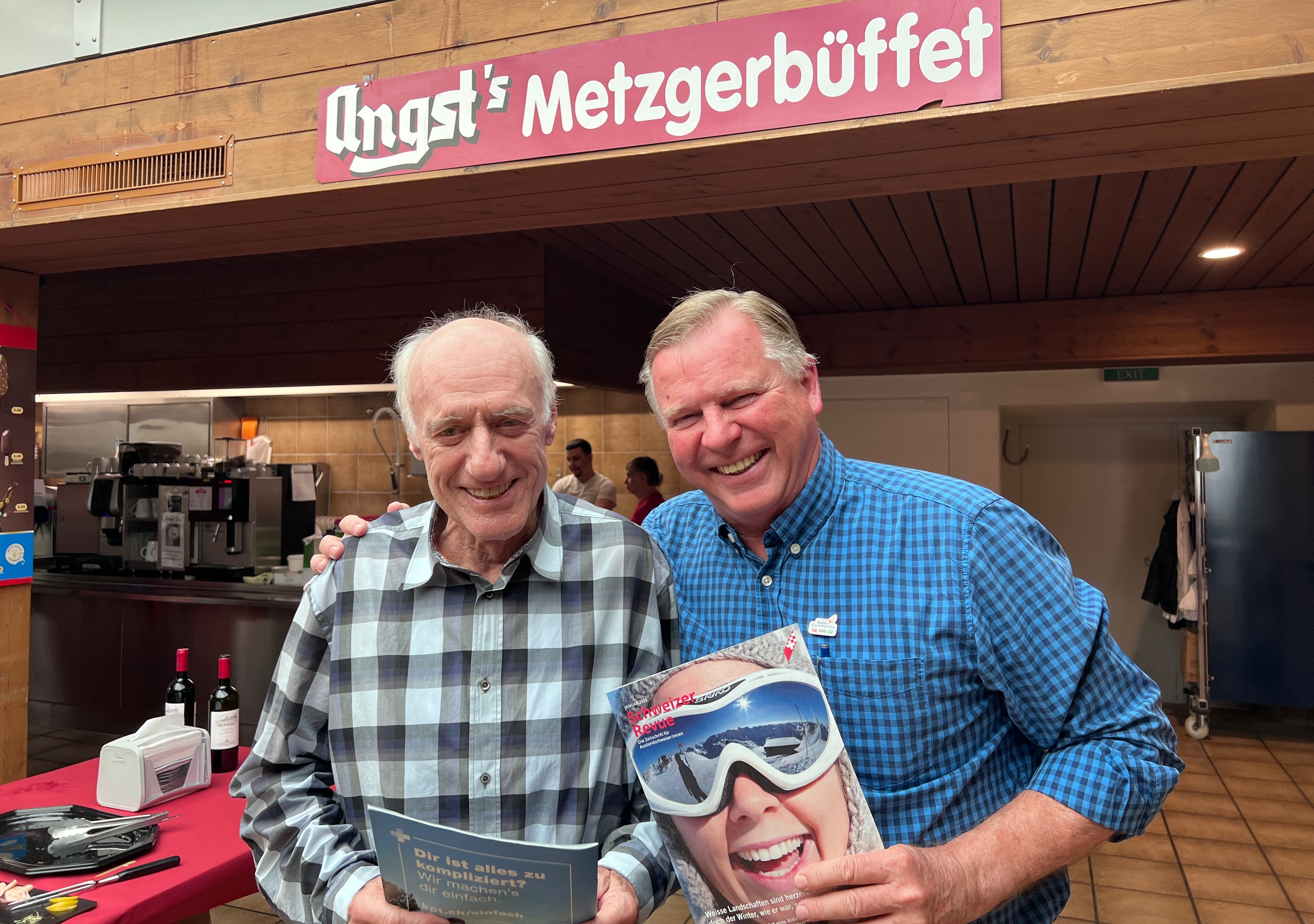

Em breve num campo de batalhas perto de você?

“Trata-se do risco de relegar decisões de vida ou morte ao processo de uma máquina”, diz Neil Davison, especialista do CICV. “Um algoritmo não deve decidir quem vive ou morre”.

A opinião do CICV é de que armas autônomas imprevisíveis devem ser proibidas, assim como aquelas cujos alvos são pessoas. Todas as outras devem permanecer sob algum tipo de “controle humano significativo”.

Obviamente, os Estados-membros da ONU que mais avançaram no desenvolvimento de armas autônomas (EUA, China, Rússia e Israel) estão hesitantes em relação a um tratado. Eles temem que sejam criadas restrições antes mesmo que a tecnologia esteja pronta para o uso mais amplo.

Tecnologia à frente da ética

Mas aqueles que advogam pela proibição do que chamam de “robôs assassinos” afirmam que é exatamente esse o ponto. Todos nós aderimos às mídias sociais antes de entender o que elas poderiam fazer em termos de coleta de dados. A tecnologia envolvida nas armas autônomas é muito avançada, e Mary Wareham, da Human Rights Watch, se preocupa que, da mesma forma que foi com as mídias sociais, nós não tenhamos entendido completamente quais são suas implicações.

Se algo der errado, ela ressalta, vai ser muito difícil responsabilizar alguém. Afinal de contas, um robô não pode ser processado por crimes de guerra. “Você considera o comandante responsável, aquele que ativou o sistema de armas?”, pergunta ela. “Quando se trata de robôs assassinos, há o que chamamos de lacuna de responsabilidade.”

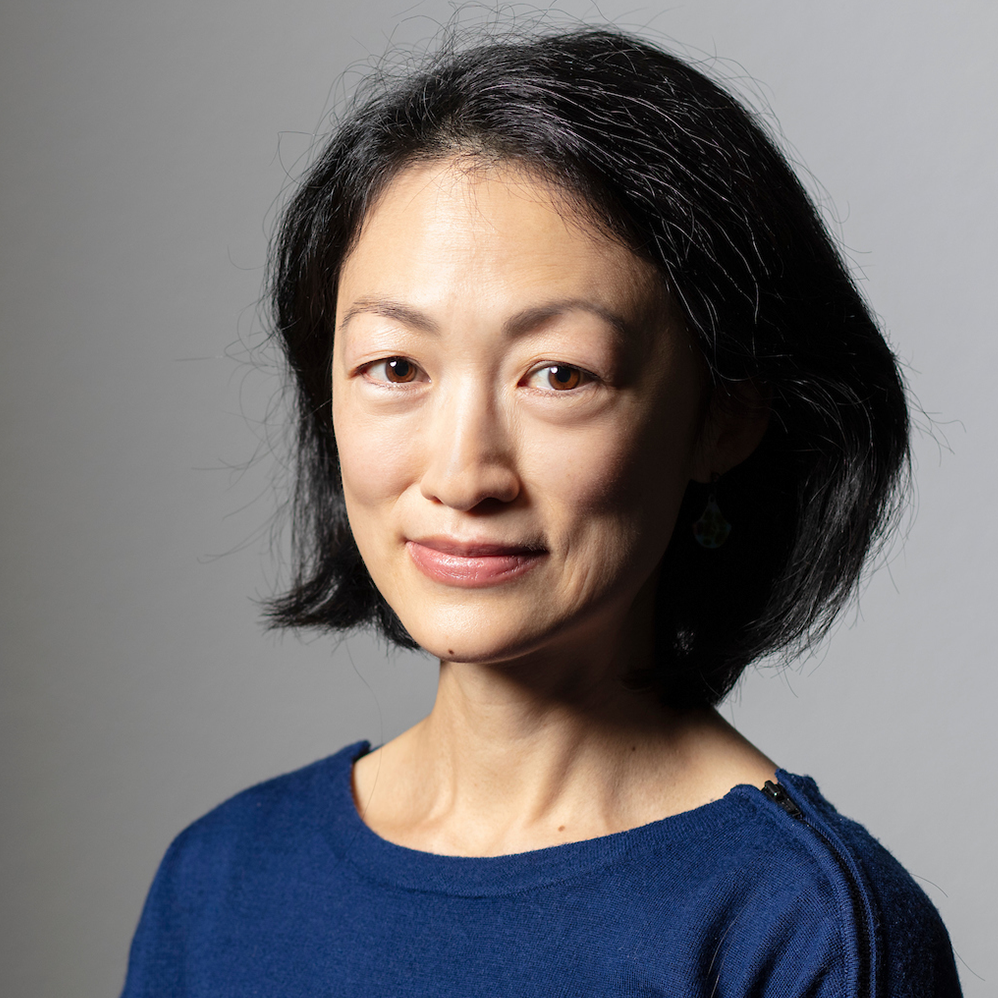

A professora de direito internacional no Instituto de Pós-Graduação de Genebra, Paola Gaeta, que participou do nosso episódio, acredita que o termo “controle significativo” também é preocupante. “O que significa ‘controle humano significativo’? E se uma arma é utilizada e desenvolvida sem controle humano significativo, quais são as consequências disso? Como se atribui a responsabilidade?”

Negociações lentas

Essas são questões que os diplomatas, organizações humanitárias e grupos de direitos humanos estão atualmente discutindo em Genebra. Eles terão de tentar respondê-las até dezembro, quando Convenção da ONU sobre Armas Convencionais (CCW, em inglês) se reunirá para decidir se devem ou não abrir negociações formais sobre um tratado.

Essas negociações normalmente levam anos, e há pouca esperança de que se possa elaborar um rascunho do tratado nos próximos meses. Mas os ativistas alertam que o tempo está se esgotando – afinal, o debate acerca da regulação de robôs assassinos começou em 2013.

E a CCW não tem o melhor histórico quando se trata de chegar a um acordo. Ela tentou redigir um tratado sobre minas terrestres e sobre munições de fragmentação. No final, os Estados-membros discordavam tanto que as negociações foram retiradas do processo da ONU, e acordadas separadamente por Estados que concordavam entre si, tornando-se a Convenção de Ottawa sobre minas terrestres, e a Convenção de Oslo sobre munições de fragmentação.

Ativistas como Wareham já suspeitam que o debate acerca das armas autônomas letais terá de seguir o mesmo caminho. Seu colega Frank Slijper, do grupo de desarmamento Pax for Peace, investiu anos nas negociações e está pronto para dar mais tempo ao processo, apesar de também não estar otimista.

“Se não tivermos um tratado dentro de dez anos, será tarde demais. A tecnologia está progredindo a um ritmo muito maior do que a diplomacia, e eu temo pelo pior”.

Por outro lado, Davison, do CICV, está envolvido nas negociações em Genebra e acredita que há motivo para certo otimismo. “Há um consenso cada vez maior de que certos tipos de armas autônomas precisam ser proibidos, e que outros precisam ser regulamentados. É claro que há muito trabalho a ser feito… mas há uma oportunidade real. Por isso, permaneço otimista”.

Adaptação: Clarice Dominguez

Adaptação: Clarice Dominguez

Certificação JTI para a SWI swissinfo.ch

Mostrar mais: Certificação JTI para a SWI swissinfo.ch

Veja aqui uma visão geral dos debates em curso com os nossos jornalistas. Junte-se a nós!

Se quiser iniciar uma conversa sobre um tema abordado neste artigo ou se quiser comunicar erros factuais, envie-nos um e-mail para portuguese@swissinfo.ch.