Как характер будущих войн связан с регулированием автономных боевых систем?

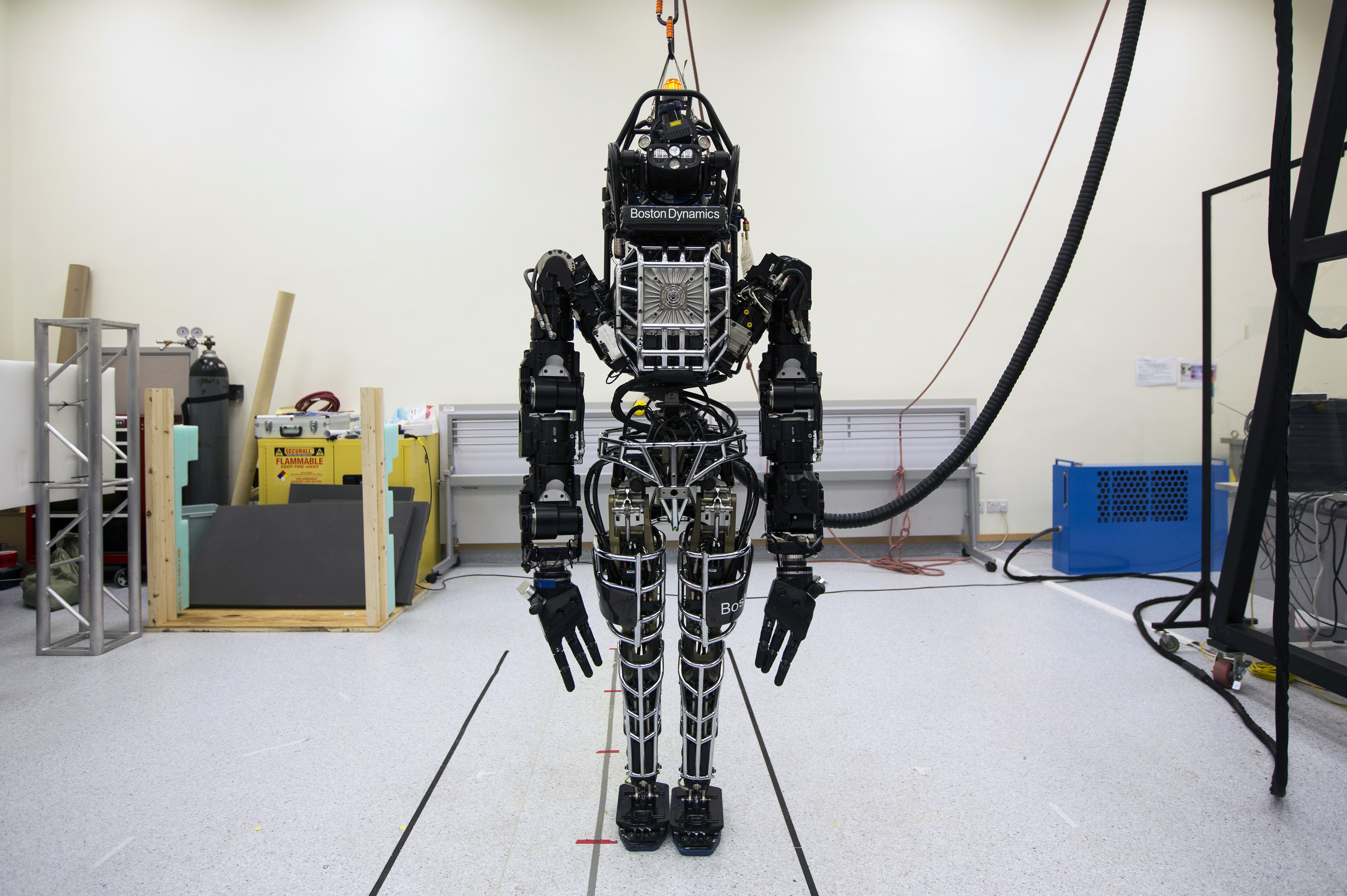

Так называемые роботы-убийцы все активнее принимают участие в современных военно-политических конфликтах, вызывая беспокойство и озабоченность международных гуманитарных организаций. Джорджа Хиндс (Georgia Hinds), юрисконсульт Международного комитета Красного Креста (МККК) в Женеве, считает, что юридически обязательный международный договор, регулирующий порядок и условия применения автономных систем вооружений, следует создать как можно скорее, уже к 2026 году.

Согласно недавним сообщениям международных СМИ, включая портал «Медуза»Внешняя ссылка, программное обеспечение на основе искусственного интеллекта (ИИ), известное как «Лаванда» и разработанное израильской армией, смогло вычислить и локализовать до 37 000 потенциальных целей в секторе Газа. Источники в израильской разведке рассказали журналистам издания «Сиха мекомит» и «+972», что программа сама учитывала погрешность в 10%, имея разрешение ликвидировать от 15 до 300 гражданских лиц в качестве допустимого «сопутствующего ущерба» в пересчете на каждую цель, связанную с ХАМАС.

Израиль не является исключением. Во всем мире способы ведения военных действий развиваются сейчас с опорой на цифровые системы автоматизации процессов. Эти системы реагируют настолько быстро, что у человека порой остается всего несколько секунд, чтобы принять окончательное решение. Война России против Украины во многом превратилась в войну новейших автоматических или полуавтоматических средств ведения войны, включая First Person View (FPV)-дроны и планирующие авиабомбы. В Женеве Организация Объединенных Наций и ряд гуманитарных организаций опасаются всплеска числа военных преступлений, связанных с этими технологиями, развивающимися быстрее, чем правила и нормы, регулирующие их применение.

Показать больше

«Убивать людей — это немного похоже на компьютерную игру»

В кулуарах организованной ООН в Женеве 30–31 мая 2024 года конференции «ИИ во благо» (AI for GoodВнешняя ссылка), портал SWI swissinfo.ch побеседовал с Джорджей Хиндс, юрисконсультом МККК, обсудив с ней вопрос новых технологий ведения войны. Ранее она уже опубликовала два доклада о влиянии систем на основе искусственного интеллекта на принятие военных решений и о последствиях этих решений для гражданских лиц, комбатантов и сферы законодательного регулирования.

Показать больше

Швейцарские беспилотники в зонах боевых действий: повод для беспокойства?

SWI swissinfo.ch: Каковы сегодня основные форматы боевого применения систем на основе искусственного интеллекта (ИИ)?

Джорджа Хиндс: Искусственный интеллект все активнее внедряется сегодня на поле боя, по крайней мере в трех ключевых областях. Первая — это системы, изменяющие саму природу процесса распространения информации. Я имею в виду в том числе и технологии создания deepfake, способные генерировать цифровой контент реалистичный — но при этом полностью фальсифицированный. Другое ключевое направление — системы вооружений, где ИИ используется для частичного или полного управления такими функциями, как выбор цели или нанесение удара (т. н. системы AWS).

Наконец, системы на основе ИИ используются в инструментах оперативной поддержки или информирования о принятии военных решений, например для моделирования эффектов, возникающих в результате применения тех или иных видов вооружений, включая предоставление комплексных рекомендаций о потенциальных целях или о направлениях и порядке действий по их ликвидации.

SWI: Учитывая, что эти технологии развиваются так быстро, способно ли вообще правовое регулирование идти в ногу со временем?

Джорджа Хиндс: Нужно помнить, что системы на основе ИИ не развиваются сами по себе. Именно люди форсируют развитие этих технологий, и у них по-прежнему есть выбор, когда и как применять их на поле боя. Международное гуманитарное право (МГП) не регулирует в явном виде применение боевых систем на основе ИИ или автономных систем вооружений. Однако оно «технологически нейтрально», то есть его нормы применимы к использованию любого оружия или любого способа ведения войны. Так что в этом смысле пробелов в регулировании у нас нет. Человек по-прежнему несет ответственность за то, чтобы при любой атаке с применением любых систем вооружений соблюдались базовые принципы МГП.

Во-первых, это принцип «различия»: нацеливание должно происходить только на комбатантов или на военные цели. Во-вторых, это принцип «пропорциональности»: необходимо избегать непропорционального побочного ущерба, наносимого гражданскому населению. В-третьих, речь идет о принципе «предосторожности»: необходимо принимать все возможные меры, с тем чтобы избегать ущерба, наносимого гражданскому населению, какая бы технология при этом ни использовалась. Тем не менее что касается полностью автономных систем вооружений, то тут мы видим острую необходимость в новых, юридически обязательных нормах и правилах.

Они должны были бы обеспечить ясность в отношении того, как международное гуманитарное право применяется с целью запрета одних видов AWS и ограничения использования других видов «автономного смертельного оружия». Такое руководство было бы полезно не только Вооруженным силам, но и сфере ВПК, а также для решения более широких проблем гуманитарного и этического характера, а также вопросов, связанных с более широкими факторами обеспечения безопасности.

Показать больше

Переговоры в Женеве: делать с роботами-убийцами?

SWI: Какие меры, по вашему мнению, должны быть приняты для регулирования автономных систем вооружений (AWS)?

Джорджа Хиндс: МККК определяет автономное оружие в качестве системы, которая сама выбирает себе цель и применяет силу по избранным целям без вмешательства человека. Мы уже призвали заключить к 2026 году новый, обязательный к исполнению договор, который запретил бы некоторые виды автономного оружия и наложил бы строгие ограничения на разработку и использование всех остальных видов AWS. В частности, эти нормы и правила должны будут запрещать непредсказуемое автономное оружие, то есть такое направленное непосредственно против людей оружие, последствия применения которого невозможно контролировать. Такие правила давно назрели, если только, конечно, мы хотим сохранить человеческий контроль над применением силы в вооруженных конфликтах, а значит, ограничить негативные последствия войны и обеспечить ключевую защиту не только гражданских лиц, но и комбатантов.

SWI: В 2023 году Генеральный секретарь ООН и президент МККК призвали все государства мира заключить юридически обязывающий документ о запрете смертоносного автономного оружия уже к 2026 году. Затем Генеральная Ассамблея ООН приняла резолюцию,Внешняя ссылка в которой выражается озабоченность рисками, связанными с применением автономных систем вооружений. Каковы будут последующие шаги?

Джорджа Хиндс: В ближайшие месяцы Генеральный секретарь ООН подготовит субстанциональный доклад об автономном оружии, основанный на мнениях всех государств, международных и региональных организаций, таких как МККК, а также представителей гражданского общества, научного сообщества и промышленных кругов. Затем международному сообществу предстоит действовать в соответствии с рекомендациями этого доклада, и мы призываем все государства начать переговоры о юридически обязывающем документе, с тем чтобы гарантировать, что ключевые меры защиты интересов людей будут сохранены и останутся действенными для будущих поколений.

Уже более десяти лет различные организации в Женеве обсуждают риски и проблемы, связанные с автономным оружием, в контексте Конвенции ООН о конкретных видах обычного оружия*. Сейчас у нас есть явное большинство государств, выступающих за юридически обязывающие нормы и правила, и поэтому мы оптимистично настроены в том смысле, что этот импульс может привести к созданию действенного документа уже к 2026 году.

SWI: Сейчас в Женеве проходит саммит «ИИ во благо». Можно ли использовать искусственный интеллект для того, чтобы избежать нанесения чрезмерного вреда гражданскому населению во время военных действий и, следовательно, сделать так, чтобы автономные системы вооружений могли в большей степени соответствовать духу и букве международного гуманитарного права?

Джорджа Хиндс: Важно критически относиться к любым заявлениям о том, что новые технологии каким-то образом могут сделать войну более гуманной. Мы уже слышали подобные утверждения, например в контексте химического оружия, а также беспилотников, и все же мы продолжаем регистрировать масштабные страдания именно мирных жителей, оказавшихся втянутыми в конфликты. Для того чтобы привнести в войну больше гуманности, необходимо сделать приоритетом соблюдение международного гуманитарного права с конкретной целью защиты гражданского населения.

Мы признаем, что у некоторых систем искусственного интеллекта есть потенциал для помощи ответственным лицам в плане соблюдения норм МГП, например при ведении боевых действий в районах плотной городской застройки, особенно если эти системы способны предоставлять командованию дополнительную информацию о гражданской инфраструктуре и о ситуации с гражданским населением. В то же время лица, принимающие решения, должны понимать и учитывать факт ограниченности таких технологий, включая значительные пробелы в массивах данных, на основе которых действуют такие системы, а также их предвзятость и непредсказуемость.

Показать больше

Швейцария получит израильские БПЛА на два года позже

SWI: Согласно журналистскому расследованию, о котором шла речь выше, израильская армия развернула в Газе сложную систему на основе искусственного интеллекта, направленную на локализацию и ликвидацию предполагаемых лидеров ХАМАС. В некоторых случаях программа допускает погрешности до 100 смертей мирных жителей на одну легитимную цель. Таково мнение журналистов. А какова ваша точка зрения? Как можно было бы призвать какую-то страну к ответу, когда для этого не существует соответствующего законодательного базиса?

Джорджа Хиндс: МККК — нейтральная, беспристрастная гуманитарная организация, и поэтому мы обычно воздерживаемся от публичных комментариев по поводу конкретных случаев использования таких систем в текущих конфликтах — эти вещи являются элементом нашего конфиденциального двустороннего диалога со сторонами данных конфликтов. Однако, как я уже говорила, в любом вооруженном конфликте нет пространства или ситуации вне сферы действия МГП. Международное гуманитарное право и соответствующие рамки ответственности будут продолжать действовать независимо от того, какие инструменты используются для ведения войны. Если в теории применить все эти правила к акции, в рамках которой армия применяла системы вооружений на основе искусственного интеллекта, то мы могли бы и в самом деле поставить некоторые вопросы. Например, насколько разумно было данному командиру полагаться в данной ситуации на результаты работы систем искусственного интеллекта? Принял ли он все возможные меры предосторожности, с тем чтобы избежать нанесения излишнего вреда гражданскому населению?

Показать больше

Роботы – братья по оружию?

SWI: Теряет ли человечество контроль над своим собственным оружием?

Джорджа Хиндс: Потеря человеком контроля над характером воздействия и над последствиями применения тех или иных систем вооружений — одна из ключевых проблем в контексте развития правовых основ применения автономных систем вооружений, особенно с учетом того, что мы наблюдаем тенденции к созданию все более сложных систем со все более сложными рабочими параметрами. В настоящее время, по нашим оценкам, Вооруженные силы в целом продолжают сохранять дистанционный контроль и/или надзор за автономными системами вооружений, пусть даже некоторые виды таких вооружений — например, боевые БПЛА — и рекламируются в качестве систем, способных якобы действовать полностью автономно. Сейчас очень важно установить четкие ограничения в сфере разработки и использования автономных систем вооружений, чтобы убедиться, что человек сохраняет финальный контроль над применением вооруженной силы.

SWI: Роботы-солдаты могут составить четверть британской армии уже к 2030 году. Каким вам видится будущее военных действий?

Джорджа Хиндс: К сожалению, какие бы технологии ни использовались, характер будущих военных действий выглядит, с моей точки зрения, весьма печально. Эти вопросы иногда теряются в ходе обсуждении плюсов и минусов новых технологий, так как все эти дискуссии происходят вдали от поля боя, поэтому новые технологии почему-то представляются нам порой как клинически чистые инструменты войн будущего. Если же говорить более конкретно, то мы считаем, что технологии в области робототехники развиваются медленнее, нежели разработки в области систем на основе ИИ. А именно они в итоге и позволят создавать новые роботизированные боевые системы.

В ближайшей перспективе интеграция систем ИИ с обычными вооружениями станет ключевым элементом на протяжении всего цикла планирования и принятия решений, от формирования предварительных рекомендаций вплоть до систем и порядка контроля над отдельными аспектами и факторами систем вооружения во время их прямого применения по целям. Таким образом, война будущего будет становиться все более сложной и непредсказуемой. Поэтому наша приоритетная задача сейчас — сфокусировать внимание международного сообщества на конкретных вариантах применения ИИ в вооруженных конфликтах, представляющих наибольший риск для жизни и достоинства людей.

Показать больше

ВВС Швейцарии получили первый израильский БПЛА

Англоязычная оригинальная версия: под редакцией Вирджини Манжан, перевод на русский язык выполнен русскоязычной редакцией SWI / ап.

Примечание

*Конвенция о «негуманном» оружии, или Конвенция о некоторых конкретных видах обычных вооружений (Convention on Certain Conventional Weapons), — важный международно-правовой инструмент в сфере контроля над обычными вооружениями и один из ключевых элементов международного гуманитарного права (МГП). Целью Конвенции является запрещение или ограничение применения конкретных видов обычных вооружений, способных причинять ненужные или неоправданные страдания комбатантам или оказывающих неизбирательное воздействие на гражданское население. КНО вступила в силу 2 декабря 1983 года, её участниками являются 126 государств.

Показать больше

Наша рассылка по теме Внешняя политика

В соответствии со стандартами JTI

Показать больше: Сертификат по нормам JTI для портала SWI swissinfo.ch

Обзор текущих дебатов с нашими журналистами можно найти здесь. Пожалуйста, присоединяйтесь к нам!

Если вы хотите начать разговор на тему, поднятую в этой статье, или хотите сообщить о фактических ошибках, напишите нам по адресу russian@swissinfo.ch.