Как швейцарские ученые хотят помешать нейросетям копировать реальность

Видеоматериалы, сфальсифицированные с использованием искусственного интеллекта, становятся все более изощренными. Как швейцарские эксперты оценивают риски, связанные с противоправным использованием технологий изготовления так называемых дипфейков (deepfakes)? И когда, по их мнению, появятся автоматизированные способы отличать подделку от оригинала?

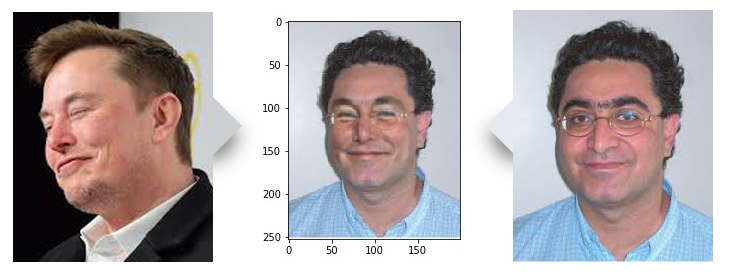

В компьютерной лаборатории где-то на территории огромного кампуса Федеральной политехнической школы Лозанны (EPFL) небольшая группа ученых внимательно рассматривает изображение розовощёкого, темноволосого кудрявого человека в очках. «Да, это сделано качественно», — говорит Турадж Эбрахими (Touradj EbrahimiВнешняя ссылка), глава экспериментального отдела Лозаннского политеха, занимающегося основами стандартизации фотоизображений и технологиями их сжатия с использованием машинно-обучаемых нейросетей (Multimedia-Signal Processing Group EPFLВнешняя ссылка).

Внешне он очень похож на человека на экране, однако на деле такого человека не существует. Ученые «создали» путем наложения его портретного фото на фотографию основателя компании Tesla Илона Маска. И так получился дипфейк — цифровое изображение или видео, сфальсифицированное с помощью искусственного интеллекта, причем так, что обычный глаз не будет в состоянии отличить оригинал от подделки. И это только один из примеров таких подделок (некоторые из них получаются более реалистичными, другие менее, но тенденция ясна), возникших в ходе сотрудничества команды ученых под руководством Т. Эбрахими с компанией Quantum Integrity (QI), специализирующейся на кибер-безопасности.

Задача стояла разработать программное обеспечение, способное обнаруживать отредактированные и изменённые изображения, включая так называемые дипфейки. Используя машинное обучение, программа сама учится все более эффективно различать подлинное и поддельное. Как это работает? Так называемый «генератор» постоянно вводит в программу большие объемы фальсифицированных изображений, а так называемый «детектор» пытается выяснить родовые признаки фальшивки и разработать потом на этой основе алгоритм распознавания «глубоких фейков».

Показать больше

Швейцарские подростки читают новости онлайн, но не верят им

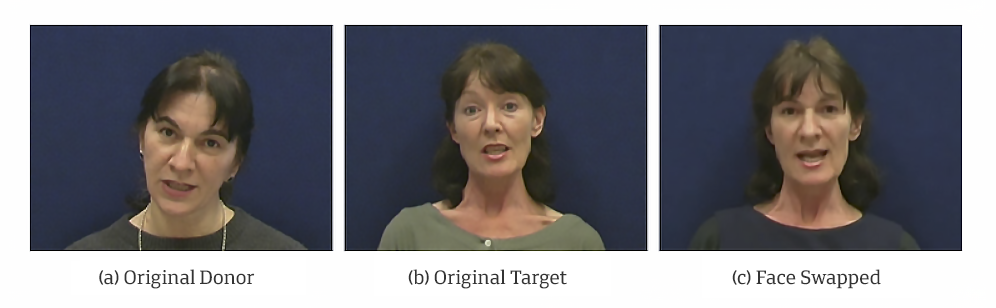

«Интенсивная „тренировка“ может в итоге дать машине способность обнаруживать подделки так же, как это делает человек. Чем больше использовать программу, тем совершеннее и эффективнее она становится», — объясняет Т. Эбрахими, и эта способность, видимо, может стать очень востребованной. Сфабрикованные фото и видео существуют с момента зарождения прессы как таковой. Однако современные технологии возвели «искусство фальсификации» до невиданных высот. Сейчас мы можем приставить к телу одного человека голову другого лица и заставить его произносить слова, которых он никогда не говорил.

По мнению экспертов Международного центра управления рисками (International Risk Governance Center IRGCВнешняя ссылка), созданного при EPFL, производство фальшивых видеороликов стало сейчас «во много раз быстрее, проще и дешевле» благодаря распространению удобных для пользователя программных инструментов и платных услуг в режиме онлайн. «Вот как раз именно потому, что всё развивается так быстро, нам и необходимо понять, куда это может нас завести, какие сектора, группы и страны это может задеть».

Таково мнение заместителя директора центра Энгус Коллинс (Aengus Collins). Пока дипфейки в основном используются при производстве порноконтента, однако недалек тот час, когда они окажутся в арсенале разного рода «троллей» и «политтехнологов». В течение последних нескольких лет технология производства дипфейков распространяется даже быстрее, чем предполагало большинство экспертов, и скоро она точно выйдет за пределы шоу-бизнеса и просто развлечений.

Быстро развивающаяся область

Когда профессор Эбрахими только начинал три года назад сотрудничать с компанией Quantum IntegrityВнешняя ссылка в рамках проекта по разработке программы обнаружения таких подделок, большинство исследователей и экспертов ими почти не интересовались. В то время основные клиенты QI были больше озабочены проблемой фотошопа, применяемого для фотоманипуляций фиктивных ДТП, или ущерба, якобы нанесенного объектам недвижимости, которые потом использовались в мошеннических схемах по получению денег со страховых компаний.

Показать больше

Как страны-единомышленники могут сотрудничать в борьбе с дезинформацией

Однако примерно в 2019 году качественный рубеж был пройден: дипфейки достигли такого уровня сложности, что было решено посвятить гораздо больше времени именно этой проблеме в рамках отдельного совместного проекта. «Я даже и представить себе не мог, что [эта технология] будет развиваться так быстро», — говорит исполнительный директор компании QI Энтони Саакян (Anthony Sahakian).

Однако потом он сам воочию убедился, насколько далеко зашли методы создания дипфейков в плане реалистичности результатов. Совсем недавно эта технология позволила, например, изменить лицо на фотографии на паспорт, причем так, что при этом остались нетронутыми все печати и другие официальные отметки. Эксперты озабочены не только усовершенствованием собственно технологий манипулирования изображениями. По данным нидерландской компании DeeptraceВнешняя ссылка, занимающейся кибер-безопасностью, к сентябрю 2019 года, всего за девять предыдущих месяцев, количество видеодипфейков в интернете увеличилось почти вдвое и составило 14 678 единиц.

Области риска

Пока большинство жертв дипфейков, сделанных для преднамеренного нанесения вреда, — женщины, чьи лица были «вставлены» в фото или видео порнографического содержания. По информации Deeptrace, в 2019 году такие подделки составляли 96% всех видео-дипфейков в интернете. Какие-то из них оказались на специализированных дипфейковых порносайтах, а остальные распространялись в качестве так называемой «порномести», с тем чтобы прицельно запятнать репутацию жертв.

«Домогательства, шельмование, преследование и издевательства в интернете — это постоянно возникающие темы», — говорит Э. Коллинс. При этом, как ни странно, нам известно довольно мало случаев использования дипфейков в мошеннических целях. Но если такое и происходило, то пока большинство таких случаев представляло собой голосовые подражания, дабы обманным путём заставить жертв отправить преступнику деньги. Тем не менее деловой мир сейчас учитывает и возможность такой угрозы.

Неслучайно ведущие страховые компании, в том числе Zurich Insurance, Swiss Re и BNP Paribas, направили недавно своих представителей на научно-практический семинар по рискам, связанным с такими подделками, организованный IRGC при Лозаннском политехе. Э. Саакян из компании QI подтверждает, что особую обеспокоенность у страховщиков вызывает сейчас возможность использования, например, фальшивых видеороликов в исках по несчастным случаям, авариям, ДТП или по делам, якобы связанным с причинением материального ущерба.

«Существующие в настоящее время технологии уже делают „KYC“ [„Знай своего клиента“], известный метод проверки и верификации личности клиента, устаревшим и ненужным», — говорит он, имея в виду метод отсеивания потенциальных мошенников, популярный у менеджеров в банковской среде. Но одновременно распространение дипфейков также поставило вопрос и о том, насколько с их помощью реально вмешиваться в текущие политические процессы.

Показать больше

Как бороться с лживой информацией в соцсетях?

Обоснованность этих страхов нашла подтверждение самое позднее в момент публикации в сети сфабрикованного видео, на котором спикер Палаты представителей США Нэнси Пелоси говорила так, словно была пьяной. Эта подделка была сделана на основе устаревшей технологии — так называемый shallowfake («фейк неглубокого залегания»). Но, как говорит Т. Эбрахими, «это яркий образец того, что можно сделать даже с такой технологией, и того, какие намерения могут лежать в основе таких фальшивок».

Приспосабливаясь к новой цифровой реальности

Эксперты, и в том числе Э. Коллинс, предупреждают, что использование в политике сфабрикованных медиа нужно рассматривать в соответствующем контексте. «Возможно, дипфейки и могут сыграть определённую роль, например, если будет поставлена цель вмешаться в выборы, но я бы не стал переоценивать риск таких фальсификаций, иначе вы рискуете не увидеть леса за деревьями», — предупреждает он. По его мнению, дипфейки на самом деле прежде всего свидетельствуют о «возникновении некоего разрыва между темпами развития цифровых информационных экосистем и развитием способности общества адаптироваться к ним».

Э. Коллинс снова в связи с эти указывает на использование дипфейков в качестве инструмента интернет-травли. «Поэтому возникает вопрос, насколько адекватно правовая система реагирует на причинение личности вреда в интернет-пространстве, — говорит он. — Встает также вопрос, как избавиться от вредоносного цифрового контента, когда он уже создан, как найти его создателя и как применить против него существующие правовые методы, особенно, если создатель дипфейка находится в другой юрисдикции».

«Противник тоже учится»

Технология видеофальсификации уже вызывает кое-где панику, но не все согласны с тем, что такие ролики настолько уж реалистичны, чтобы действительно быть в состоянии обмануть коллективного пользователя с его миллионами глаз и огромным совокупным опытом пребывания в сети. Эксперты говорят, что сегодня качество дипфейков все ещё во многом зависит от навыков их создателей, а эти навыки сегодня не везде еще на высоте. Как нам объяснил эксперт по биометрической безопасности Себастьян Марсель (Sébastien Marcel), замена лица на видео неизбежно приводит к определенным дефектам изображения.

При этом он подчёркивает, что если создатель не будет лениться и приложит специальные усилия для того, чтобы внимательно отредактировать и откорректировать конечный результат, то тогда фальшивку действительно будет очень трудно обнаружить. Себастьян Марсель и его коллеги из Исследовательского института Idiap Research Institute in MartignyВнешняя ссылка на юго-западе Швейцарии работают сейчас над собственной версией программы, обнаруживающей сфабрикованные изображения и изменённые голоса в видеоматериалах.

Показать больше

Обычные СМИ в Швейцарии уступают соцсетям

«Сегодня эту проблему еще не решить, — говорит С. Марсель. — Это постоянно расширяющаяся область исследований, и именно поэтому мы планируем вложить в её изучение дополнительные ресурсы». В качестве стартового импульса этот некоммерческий НИИ использует участие в конкурсе на разработку выявляющего дипфейки программного обеспечения, который сейчас проводит Facebook (см. инфобокс). Но изменит ли что-то в реальном мире сама возможность обнаруживать фальшивки? Это остаётся спорным вопросом. «Такая программа вряд ли станет палочкой-выручалочкой, — говорит Э. Коллинс. — Противник тоже учится, и он всегда найдёт способы обойти возводимые нами преграды».

Как Турадж Эбрахими, так и Себастьян Марсель говорят, что не ставят перед собой цель создать некий на сто процентов безотказный инструмент. Но они все-таки хотят научить программу-детектор предвидеть, в каком направлении могут двигаться создатели фальшивок, и соответствующим образом корректировать методы, используемые этим инструментом, для их обнаружения. Это важно, потому что в будущем, по их словам, можно будет менять не только, например, лицо, но вообще полное изображение человека.

«Качество дипфейков будет повышаться, поэтому нам необходимо совершенствовать и наши программы-детекторы таким образом, чтобы соотношение затрат и выгод от создания злостных подделок было не в пользу их создателей», — говорит он. Профессор Эбрахими из EPFL полагает, что какое-то объективно важное событие, например президентские выборы в США, может стать стимулом для злоумышленников ускорить свою работу. Но как скоро настанет время, когда даже натренированный человеческий глаз не сможет больше отличить подделку от оригинала и когда справиться с этой задачей будут в состоянии только машины? «Это вопрос максимум нескольких лет», — резюмирует Турадж Эбрахими.

Платформы социальных сетей против видеоподделок

В марте 2020 года социальная сеть «Твиттер» ввела новую норму, которая запрещает «делиться» специально препарированным или манипулированным медиаконтентом, потенциально способным нанести вред обществу. Среди этих мер особая маркировка таких твитов и отображение предупреждений для пользователей.

Хостинговая платформа YouTube, принадлежащая Google, указала, что не собирается мириться с откровенно поддельными видеоматериалами, особенно связанными с выборами и с переписью населения США в 2020 году.

Социальная сеть Facebook выделила более 10 млн. долл. на финансовую поддержку проектам в области обнаружения, идентификации и противодействия видеофальшивкам. Как Facebook, так и Google опубликовали в открытом доступе коды-исходники сфальсифицированных видеоизображений, с тем чтобы помочь ученым в разработке эффективных методов их распознавания.

Русскоязычную версию материала подготовила Нина Шулякова, ред. Игорь Петров.

В соответствии со стандартами JTI

Показать больше: Сертификат по нормам JTI для портала SWI swissinfo.ch

Обзор текущих дебатов с нашими журналистами можно найти здесь. Пожалуйста, присоединяйтесь к нам!

Если вы хотите начать разговор на тему, поднятую в этой статье, или хотите сообщить о фактических ошибках, напишите нам по адресу russian@swissinfo.ch.